Big Brother ansigtsgenkendelse kræver etiske regler

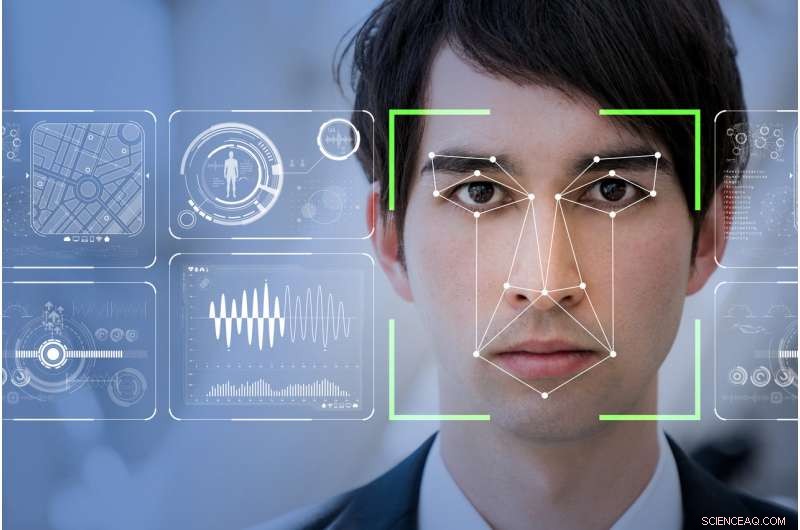

Vil ansigtsgenkendelsessoftware gøre verden til et mere sikkert sted, som tech-firmaer hævder, eller vil det gøre de marginaliserede mere sårbare og overvågede? Kredit:Shutterstock

Min mor sagde altid, at jeg havde et ansigt til radio. Gudskelov, da radio kan være det sidste sted i denne teknologiforbedrede verden, hvor dit ansigt ikke vil bestemme din sociale status eller potentiale til at begå en forbrydelse.

RealNetworks, den globale leder af en teknologi, der muliggør problemfri digital levering af lyd- og videofiler på tværs af internettet, har netop udgivet sin seneste computervision:En maskinlæringssoftwarepakke. Håbet er, at denne nye software vil opdage, og potentielt forudsige, mistænkelig adfærd gennem ansigtsgenkendelse.

Kaldet SAFR (Secure, Nøjagtig ansigtsgenkendelse), Værktøjssættet er blevet markedsført som en omkostningseffektiv måde at glide ind i eksisterende CCTV-videoovervågningssystemer. Det vil være i stand til at "opdage og matche millioner af ansigter i realtid, " specifikt inden for skolemiljøer.

Tilsyneladende, RealNetworks ser sin teknologi som noget, der kan gøre verden mere sikker. Den fængende branding, imidlertid, maskerer de reelle etiske problemer omkring implementeringen af ansigtsdetektionssystemer. Nogle af disse problemer omfatter spørgsmål om de iboende skævheder indlejret i koden og, ultimativt, hvordan de opsamlede data bruges.

Den kinesiske model

Storebror ser på. Intet andet land i verden har mere videoovervågning end Kina. Med 170 millioner CCTV-kameraer og omkring 400 millioner nye, der installeres, det er et land, der har adopteret og implementeret ansigtsgenkendelse på en orwellsk måde.

I den nærmeste fremtid, sine borgere, og de af os, der rejser der, vil blive udsat for et stort og integreret netværk af ansigtsgenkendelsessystemer, der overvåger alt fra brugen af offentlig transport, at fremskynde, hvor meget toiletpapir man bruger på det offentlige toilet.

Det mest foruroligende element indtil videre er den nylige introduktion af ansigtsgenkendelse for at overvåge skolebørns adfærd i kinesiske offentlige skoler.

Som en del af Kinas fulde integration af deres lige så Orwellske sociale kreditsystem - et incitamentsprogram, der belønner hver enkelt borgers forpligtelse til statens dikterede moral - vil dette fuldt integrerede digitale system automatisk identificere en person. Det kan så bestemme ens evne til at gøre fremskridt i samfundet – og i forlængelse heraf denne persons nærmeste families økonomiske og sociale status – ved at overvåge statens ikke-sanktionerede adfærd.

I det væsentlige, Ansigtsgenkendelse gør det umuligt for de udsatte at få den luksus at have en dårlig dag.

Ansigtsgenkendelsessystemer, der nu implementeres i kinesiske skoler, overvåger alt fra klasseværelset til om et barn dagdrømmer eller er opmærksom. Det er et komplet overvågningssystem, der bestemmer, i høj grad, et barns fremtid uden at overveje, at nogle kvaliteter, såsom abstrakt tanke, kan ikke let opdages eller i bedste fald, set positivt på, med ansigtsgenkendelse.

Det rejser også nogle meget ubehagelige forestillinger om etik eller manglen på samme, især over for mere udsatte medlemmer af samfundet.

Behov for offentlig regulering

RealNetworks lancering af SAFR kommer varmt i hælene på Microsofts præsident Brad Smiths lidenskabelige manifest om behovet for offentlig regulering og virksomhedsansvar i udviklingen og implementeringen af ansigtsgenkendelsesteknologi.

Smith påpegede med rette, at ansigtsgenkendelsesværktøjer stadig er noget skæve og har "større fejlprocenter for kvinder og farvede." Dette problem er dobbelt, med en erkendelse af, at de mennesker, der koder, ubevidst kan indlejre kulturelle skævheder.

De tilgængelige datasæt mangler muligvis den objektive robusthed, der kræves for at sikre, at folks ansigter ikke bliver fejlidentificeret, eller endnu værre, forudbestemt gennem indkodet bias, som det nu begynder at ske i det kinesiske skolesystem.

I et forsøg på at løse dette og utallige andre relaterede problemer, Microsoft etablerede et udvalg for kunstig intelligens og etik i teknik og forskning (AETHER). Denne komité er også nedsat for at hjælpe dem med at overholde EU's nyligt håndhævede generelle databeskyttelsesforordning (GDPR) og dens eventuelle fremtidige vedtagelse, i en eller anden form, i Nordamerika.

Smiths glødende appel stiller med rette spørgsmålstegn ved den nuværende og fremtidige tilsigtede brug og implementering af ansigtsgenkendelsessystemer, alligevel undlader at adressere, hvordan Microsoft eller, i forlængelse, andre ledere af kunstig intelligens, kan eliminere skævheder i deres basiskode eller datasæt fra starten.

Mindretalsrapport

Trækkene i vores ansigt er næppe mere end gestus, som vanens kraft har gjort permanent .- Marcel Proust, 1919

Ligesom mange andre teknologier, Pandora har allerede forladt kassen. Hvis du ejer en smartphone og bruger internettet, du har allerede fravalgt alle grundlæggende forestillinger om personlig anonymitet i det vestlige samfund.

Med GDPR nu fuldt engageret i Europa, at besøge et websted kræver nu, at du "tilvælger" muligheden for, at det pågældende websted muligvis indsamler personlige data. Ansigtsgenkendelsessystemer har ingen mulighed for at følge GDPR-reglerne, så som sådan, vi som samfund er automatisk "opted-in" og dermed fuldstændig prisgivet, hvordan vores ansigter bliver optaget, behandlet og opbevaret af offentlige myndigheder, virksomheds- eller endda privat udrullede CCTV-systemer.

Ansigtsgenkendelsesforsøg afholdt i England af London Metropolitan Police har konsekvent givet en fejlrate på 98 procent. Tilsvarende i det sydvestlige Wales, test har kun gjort det lidt bedre med mindre end 10 procent succes.

Omvendt University of California, Berkeley, Forskere har konkluderet, at substantiel ansigtsvariation er en evolutionær egenskab, der er unik for mennesker. Så hvor er afbrydelsen?

Hvis som Marcel Proust har foreslået, vores liv og dermed vores personligheder er unikt identificerbare ved vores ansigter, hvorfor kan ansigtsgenkendelsessystemer ikke nemt give positive resultater?

Svaret går tilbage til, hvordan computerprogrammering er skrevet, og de datasæt, der bruges af den kode til at returnere et positivt match. uundgåeligt, kode er skrevet for at understøtte en idealiseret forestilling om ansigtstype.

Som sådan, outlying variations like naturally occurring facial deformities or facial features affected by physical or mental trauma represent only a small fraction of the infinite possible facial variations in the world. The data sets assume we are homogeneous doppelgängers of each other, without addressing the micro-variations of peoples faces.

Hvis det er tilfældet, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.

Varme artikler

Varme artikler

-

Falske nyheder ændrer form, efterhånden som EU går ind i valgI denne 9. maj 2011 filbillede, EU-flag vajer uden for Europa-Kommissionens hovedkvarter i Bruxelles. Desinformation har udviklet sig ud over den spillebog, der blev brugt af russiske trolde i det ame

Falske nyheder ændrer form, efterhånden som EU går ind i valgI denne 9. maj 2011 filbillede, EU-flag vajer uden for Europa-Kommissionens hovedkvarter i Bruxelles. Desinformation har udviklet sig ud over den spillebog, der blev brugt af russiske trolde i det ame -

Otte aero -konceptinnovationer peger mod 75% reduktion af CO2 -emissioner i 2050Kredit:Jag_cz, Shutterstock EUs vision for luftfart i 2050 er at gøre Europa til verdens førende inden for bæredygtige luftfartsprodukter og -tjenester og samtidig opfylde borgernes og samfundets

Otte aero -konceptinnovationer peger mod 75% reduktion af CO2 -emissioner i 2050Kredit:Jag_cz, Shutterstock EUs vision for luftfart i 2050 er at gøre Europa til verdens førende inden for bæredygtige luftfartsprodukter og -tjenester og samtidig opfylde borgernes og samfundets -

Seattles anden teknologisektor, livsvidenskab, er på vej op igenKredit:CC0 Public Domain I en stille erhvervspark langt fra Seattles blomstrende South Lake Union, spillere i Nordvestens anden teknologisektor klarer deres voksende smerter. Hos FujiFilm-SonoSit

Seattles anden teknologisektor, livsvidenskab, er på vej op igenKredit:CC0 Public Domain I en stille erhvervspark langt fra Seattles blomstrende South Lake Union, spillere i Nordvestens anden teknologisektor klarer deres voksende smerter. Hos FujiFilm-SonoSit -

Croc-spotting dronepatrulje letter Down UnderDe højteknologiske droner kendt som croc spotters blev testet langs flodsenge, at opdage dyr, mens de gik Australiens barske krokodilleland kan blive mere sikkert takket være verdens første droner

Croc-spotting dronepatrulje letter Down UnderDe højteknologiske droner kendt som croc spotters blev testet langs flodsenge, at opdage dyr, mens de gik Australiens barske krokodilleland kan blive mere sikkert takket være verdens første droner

- Hvad er det ældste fossil, der nogensinde er fundet?

- Fysik-teamet beregner, at grafenskiver kunne være komplette optiske absorbere

- Kunstvandet landbrug i Wisconsins centrale sand afkøler regionens klima

- Skovenes kulstoflagre har været overvurderet i 50 år

- Fysik viser, at ufuldkommenheder gør mester

- Spilanmeldelse:Phoenix Point er kaotisk og dejlig