Hvorfor kunstig intelligens sandsynligvis vil tage flere liv

Kredit:Geralt/Pixabay

Kunstige neuroner til dybt intelligente maskiner - dette er den nye kunstig intelligens (AI) revolution, ledet af Geoffrey Hinton og hans team siden 2012. Det år, Hinton, en ekspert i kognitiv videnskab ved University of Toronto og en forsker ved Google Brain, demonstrerede den slående effektivitet af et dybt neuralt netværk (DNN) i en billedkategoriseringsopgave.

I kølvandet på disse bemærkelsesværdige resultater, universiteter – og internationale virksomheder – investerede massivt i det lovende og fascinerende område AI. Men på trods af den imponerende præstation af DNN'er på en række forskellige områder (visuel og vokal genkendelse, oversættelse, medicinske billeder, etc.), der er stadig spørgsmål om grænserne for dyb læring til andre formål, såsom anonyme køretøjer.

For at forstå grænserne for AI i dens nuværende tilstand, vi er nødt til at forstå, hvor DNN'er kommer fra, og først og fremmest, hvilke områder af den menneskelige hjerne de er modelleret efter – man ved lidt om dette inden for industriteknik, og endda i nogle forskningscentre. Siden begyndelsen af denne nye revolution, dyb læring bruges nogle gange som en slags "tryllestav", med ringe opmærksomhed på dens baggrund eller begrænsninger. "For en meningsfuld kunstig intelligens", titlen på en nylig rapport af den franske matematiker Cédric Villani, er bevis på den dybe ambivalens omkring dette emne.

Hvor kom dyb læring fra?

Begyndelsen af kunstige neurale netværk går tilbage til 1940'erne, med de banebrydende opdagelser inden for neurovidenskab og psykologi af Warren McCulloch og Walter H. Pitts (som leverede den første matematiske model af en neuron) og Donald Hebb (som beskrev mekanismerne for synaptisk læring). Disse forskere ønskede at forstå, hvordan neuroner, de grundlæggende byggesten i hjernen, kunne generere psyken.

Deres skelsættende arbejde førte til skabelsen af det første kunstige neuronale netværk, Perceptronen, designet i 1958 af den amerikanske psykolog Frank Rosenblatt. Naturligt, indledende forskning blev efterfulgt af væsentlige udviklinger baseret på for eksempel, om de neurovidenskabelige undersøgelser af Alan L. Hodgkin og Andrew F. Huxley, der beskriver den tidsmæssige dynamik af neural integration, og om forskning i datalogi og matematik af Bernard Widrow og Ted Hoff, der foreslog brugen af stokastiske gradientnedstigningsalgoritmer som en mere effektiv måde at ændre de synaptiske forbindelser i neurale netværk.

Disse matematiske optimeringer blev videreudviklet i 1980'erne med forskning i kognitiv videnskab af David Rumelhart, Geoffrey Hinton og James McClelland, medlemmer af Parallel Distributed Processing Research Group. Deres arbejde hjalp med at optimere modifikationen af synaptiske forbindelser i dybe neuronale lag og førte til skabelsen af Multilayer Perceptron (MLP). DNN'er, udviklet af forskere som Geoffrey Hinton, Yann LeCun og Yoshua Bengio, er dens direkte efterkommere.

Er der en sammenhæng mellem dyb læring og hjernen?

Selvom DNN'er oprindeligt blev udviklet gennem tværfagligt arbejde og inspireret af hjernefunktion, man kan undre sig over, i hvilket omfang disse algoritmer stadig udgør en simulering af den menneskelige hjerne. De blev designet til at udføre opgaver som billedgenkendelse og kategorisering. For at gøre dette, DNN'er bruger forskellige foldnings- og poollag forud for billedgenkendelse.

Med hensyn til foldningslag, David Hubels og Torsten Wiesels arbejde i 1960'erne, og Leonie Jones og Derecke Palmer i 1980'erne, demonstrere anvendeligheden af denne metode til at simulere den sandsynlige reaktion fra neuroner i den primære visuelle cortex. Adskillige undersøgelser i kognitionsvidenskab, inklusive vores eget arbejde, bruge denne proces som et neuro-inspireret system til at simulere responsen fra perceptuelle neuroner i den primære visuelle cortex for eksempel.

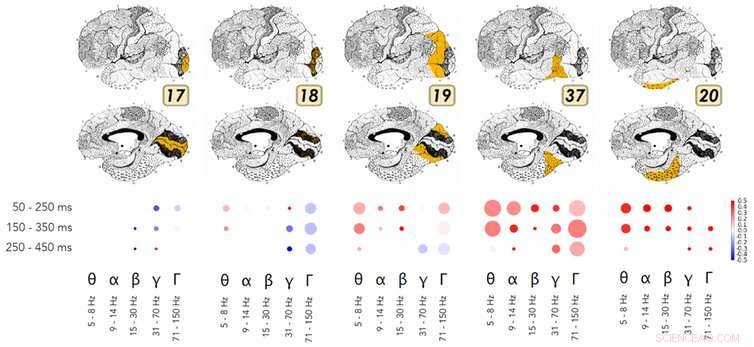

Et eksempel på forskning, der viser lighederne i den måde, som dybe neurale netværk og den ventrale strøm af den visuelle cortex fungerer på. Kredit:Kuzovkin, Vicente, Petton, Lachaux, Baciu, Kahane et Aru, 2018., Forfatter angivet

Med hensyn til pooling, forskellige undersøgelser inden for neurovidenskab og kognitiv psykologi gennem de sidste tredive år har vist, hvordan hjernen udfører denne abstraktionsproces i den ventrale visuelle strøm. Rufin Vogels og Keiji Tanakas arbejde viser, hvordan denne strøm muliggør visuel identifikation og kategorisering, uafhængigt af overfladeegenskaberne af et billede, såsom tekstur, farve, afstand, eller placeringen af objekter i billedet. Disse hjerneområder er derfor følsomme over for den samme information som de perceptuelle lag lært af en DNN under poolingsprocessen.

Endnu mere overraskende, forskning udført af Rodrigo Quian Quiroga og hans kolleger viser eksistensen af specifikke neuroner for begreber eller identiteter (f.eks. en "Jennifer Aniston" neuron, eller en "Tower of Pisa" neuron). Disse brand som reaktion på direkte eksponering for et koncept, såsom at se navnet "Jennifer Aniston" på tryk. Hvad der er mere spændende for fremtiden for kunstig intelligens er, at hr. Quirogas arbejde viser, at denne neuronale aktivitet er korreleret med bevidst opfattelse af en stimulus i omgivelserne.

At opsummere, selvom de er forenklet og matematisk optimeret sammenlignet med en biologisk hjerne, DNN'er gengiver meget lignende processer som et meget specifikt område i cortex (nemlig, den occipito-temporale cortex). Brug af MR eller elektroder implanteret i hjernen, nyere undersøgelser inden for kognitiv neurovidenskab viser ligheder i funktionen af DNN'er og disse specifikke hjerneområder.

Er AI mere pålidelig, når den er inspireret af hjernen?

Grundlæggende tværfaglig forskning om DNN'er har produceret imponerende håndgribelige resultater på en lang række områder:visuel genkendelse og kategorisering, vokal genkendelse, oversættelse, spillet af gå, musikalsk komposition, for blot at nævne nogle få. Desværre, gennem en mangel på forståelse af den kognitive videnskab, der ligger til grund for dem, DNN'er bruges stadig alt for ofte som en slags tryllestav til at løse alle problemer.

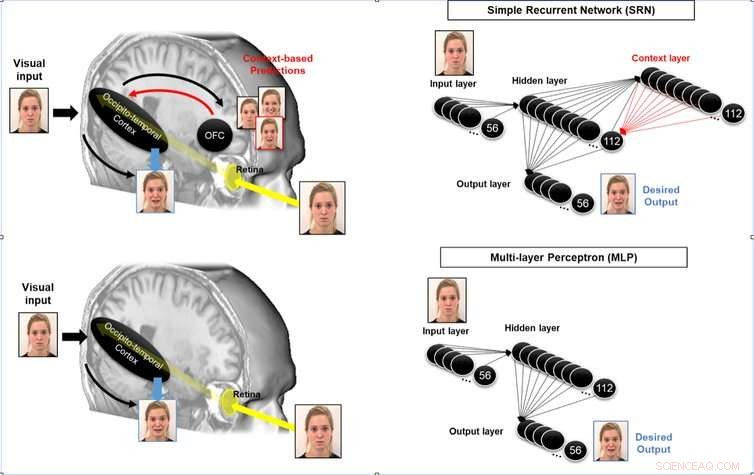

Det er muligt at forbedre et neuromorfisk systems evne til at foregribe ved at simulere de tilbagevendende sløjfer fra associative områder til perceptuelle områder, der arbejder i den menneskelige hjerne. Kredit:Mermillod, Bourrier, David, Kauffmann, Chauvin, Guyader, Dutheil et Peyrin, 2018., Forfatter angivet

For at tage eksemplet med førerløse biler, Tankeløst at koble DNN'er til køretøjets kontrolsystemer ville være meget risikabelt:Det ville være ensbetydende med at bede en taxachauffør, der mistede over 80 % af sin hjernefunktion i en ulykke (og efterlod kun den visuelle ventralstrøm) om at køre bil. At kræve, at disse systemer gør mere end det, de oprindeligt var designet til, kan føre til katastrofale ulykker.

De menneskelige hjerneområder, der er involveret i forventning (se nedenfor), rumlig orientering og de sensorisk-motoriske funktioner, der kræves til kørsel i et komplekst miljø, er meget forskellige fra de neurale processer, der arbejder i den visuelle ventralstrøm. Placeret i occipito-parietal cortex, de neuronale processer involveret i forståelsen og planlægningen er meget forskellige fra dem, der finder sted i den visuelle ventrale strøm! Det er meget forskellige neuroner, følsom over for afstand, position og hastighed – alle grundlæggende parametre for at bestemme, hvordan vi opfører os i miljøet.

Udiskriminerende brug af DNN'er (eller andre kunstige systemer) uden reference eller sammenligning med neuro-inspirationen bag de forskellige kognitive funktioner er ikke kun ineffektiv, men direkte farlig. Vi hævder ikke, at neuro-inspiration er den eneste effektive vej mod sikrere AI. Imidlertid, givet AI's tumultariske fortid, og under hensyntagen til den nu beviste effektivitet af neuro-inspirerede systemer som DNN'er sammenlignet med tidligere ingeniørmetoder (til visuel genkendelse, for eksempel), vi mener, det er vigtigt at forstå, hvordan hjernen udfører andre kognitive funktioner (motorisk kontrol, multisensorisk integration, osv.) for at sammenligne dette med nuværende tekniske teknikker til at udføre disse funktioner, og producere en sikrere, mere effektiv AI.

AI-forskning udført i tættere samarbejde med kognitionsvidenskaberne ville gøre os i stand til at:

- forstå og simulere hjerneområder, som endnu ikke er omfattet af dyb læring.

- udvikle mere pålidelig og effektiv kunstig intelligens sammenlignet med menneskelig præstation.

Denne udfordring kræver tværfaglig forskning, der ikke kun involverer matematik og datalogi, men også neurovidenskab og kognitiv psykologi, samt forskning i elektronik og fysik for at udvikle de neurale processorenheder (NPU), der i øjeblikket er ved at blive designet. Vi har muligheden for endelig at overvinde grænserne for Turing-Von Neumann-maskinerne, der har domineret elektronik og informationsteknologi siden Anden Verdenskrig.

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

WhatsApps administrerende direktør Jan Koum forlader Facebook midt i privatlivets fredI denne mandag, 24. februar, 2014, fil foto, Whatsapp medstifter og CEO Jan Koum taler under en konference på Mobile World Congress, verdens største mobiltelefonmesse i Barcelona, Spanien. På mandag,

WhatsApps administrerende direktør Jan Koum forlader Facebook midt i privatlivets fredI denne mandag, 24. februar, 2014, fil foto, Whatsapp medstifter og CEO Jan Koum taler under en konference på Mobile World Congress, verdens største mobiltelefonmesse i Barcelona, Spanien. På mandag, -

AI-teknologi forbedrer kritisk revnedetektion i atomreaktorer, broer, bygningerKredit:CC0 Public Domain En lille revne i en atomreaktor, skyskraber, bro eller dæmning kan forårsage katastrofale konsekvenser. Minneapolis broen kollapser, som dræbte 13 mennesker i 2007, er blo

AI-teknologi forbedrer kritisk revnedetektion i atomreaktorer, broer, bygningerKredit:CC0 Public Domain En lille revne i en atomreaktor, skyskraber, bro eller dæmning kan forårsage katastrofale konsekvenser. Minneapolis broen kollapser, som dræbte 13 mennesker i 2007, er blo -

3-D-printede aktive metamaterialer til lyd- og vibrationskontrolPrøve af det 3-D-printede akustiske metamateriale. Kredit:Qiming Wang Forskere har presset på materialernes muligheder ved omhyggeligt at designe præcise strukturer, der udviser unormale egenskabe

3-D-printede aktive metamaterialer til lyd- og vibrationskontrolPrøve af det 3-D-printede akustiske metamateriale. Kredit:Qiming Wang Forskere har presset på materialernes muligheder ved omhyggeligt at designe præcise strukturer, der udviser unormale egenskabe -

Japans SoftBank vil sænke 2,25 milliarder dollars i GM's autonome bilenhedI denne 20. juli, 2017, fil foto, SoftBank Group Corp. administrerende direktør Masayoshi Son, venstre, taler under en SoftBank World-præsentation på et hotel i Tokyo. SoftBank vil bruge 2,25 milliard

Japans SoftBank vil sænke 2,25 milliarder dollars i GM's autonome bilenhedI denne 20. juli, 2017, fil foto, SoftBank Group Corp. administrerende direktør Masayoshi Son, venstre, taler under en SoftBank World-præsentation på et hotel i Tokyo. SoftBank vil bruge 2,25 milliard

- Ny opdagelse åbner en ny vej for høj-titerproduktion af drop-in biobrændstoffer

- Ekkoer af 2008:Kan klimaændringer udløse en global finanskrise?

- Videnskabsprojekter at lære, om en isterning smelter hurtigere i luft eller vand

- Asiens gletschere giver buffer mod tørke

- Tager spor fra naturen for at udvikle farver, der ikke falmer

- Midaldrende iværksættere klarer sig bedre end tyve