Certificering af angrebsmodstand af foldede neurale netværk

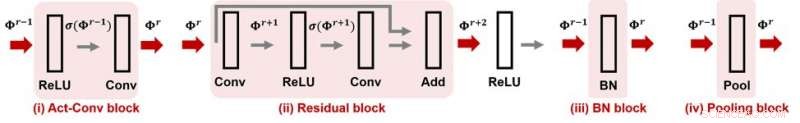

Figur 1. CNN-Cert understøtter mange populære moduler og lagoperationer i foldede neurale netværk. Kredit:IBM

Når du køber et ur, du kan bemærke dens vandtæthedsvurdering, hvilket indikerer, at uret garanteres at være vandtæt til et vist niveau. Hvad med dit neurale netværk? Kan man sikre, at et neuralt netværk er "angrebssikkert", betyder, at dens funktionalitet er robust over for modstridende forstyrrelser? Hvis så, hvordan kan dette kvantificeres med et angrebsmodstandsnummer? Ved AAAI 2019, vores gruppe af forskere fra MIT og IBM Research foreslår en effektiv og effektiv metode til at certificere angrebsmodstand af foldede neurale netværk til givne inputdata. Dette papir er udvalgt til mundtlig præsentation på AAAI 2019 (30. januar, 14.00-15.30 @ coral 1).

De nuværende dybe neurale netværksmodeller er kendt for at være sårbare over for modstridende forstyrrelser. En omhyggeligt udformet, men alligevel lille forstyrrelse af inputdata kunne nemt manipulere forudsigelsen af modellens output, herunder maskinlæringsopgaver såsom objektgenkendelse, taleoversættelse, billedtekst, og tekstklassificering, for at nævne et par stykker. Mangel på robusthed over for modstridende forstyrrelser medfører nye udfordringer i AI-forskning og kan hæmme vores tillid til AI-systemer.

Givet et neuralt netværk og i betragtning af en adversariel trusselsmodel, hvor angrebsstyrken er karakteriseret ved Lp-normen for forstyrrelsen, for enhver datainput, dens modstandsdygtighed kan kvantificeres som den minimale angrebsstyrke, der kræves for at ændre modelforudsigelsen (se figur 1 i det forrige indlæg for en visuel illustration). Her, et angrebssikkert robusthedscertifikat for et input specificerer en angrebsstyrke ε og tilbyder følgende garanterede angrebsmodstand:under den normbundne trusselmodel, ingen modstridende forstyrrelser kan ændre forudsigelsen af input, hvis deres angrebsstyrke er mindre end ε. Med andre ord, større ε betyder, at inputtet er mere robust. Denne robusthedscertificering kan være afgørende i sikkerhedskritiske eller omkostningsfølsomme AI-applikationer, der kræver høj præcision og pålidelighed, såsom autonome køresystemer.

Vores foreslåede metode, CNN-Cert, giver en generel og effektiv ramme til certificering af niveauet af modstridende robusthed af foldede neurale netværk til givne inputdata. Vores rammer er generelle:vi kan håndtere forskellige arkitekturer, herunder foldningslag, max-pooling lag, batch normaliseringslag, resterende blokke, samt generelle aktiveringsfunktioner såsom ReLU, tanh, sigmoid og arctan. Figur 1 viser nogle almindeligt anvendte byggeklodser, der tages i betragtning i vores CNN-Cert-ramme. Nøgleteknikken i CNN-Cert er at udlede eksplicit netværksoutput bundet ved at overveje input/output-relationerne for hver byggeblok, markeret som røde pile. Aktiveringslaget kan være andre generelle aktiveringer end ReLU. Vores tilgang er også effektiv - ved at udnytte den særlige struktur af foldede lag, vi opnår op til 17 og 11 gange speed-up sammenlignet med de avancerede certificeringsalgoritmer og 366 gange speed-up sammenlignet med en standard dual-LP-tilgang, mens vores metode opnår lignende eller endnu bedre grænser for angrebsmodstand .

Denne historie er genudgivet med tilladelse fra IBM Research. Læs den originale historie her.

Varme artikler

Varme artikler

-

Fossile brændstoffer giver i stigende grad et ringe afkast af energiinvesteringerKredit:CC0 Public Domain En evaluering af det globale energiafkast af investeringer for fossile brændstoffer og vedvarende kilder afslører en meget mere lige vilkår end tidligere antaget. Et vedv

Fossile brændstoffer giver i stigende grad et ringe afkast af energiinvesteringerKredit:CC0 Public Domain En evaluering af det globale energiafkast af investeringer for fossile brændstoffer og vedvarende kilder afslører en meget mere lige vilkår end tidligere antaget. Et vedv -

Nyt tidsbanksystem bruger blockchain-teknologi til at måle ens værdi for samfundetIllustration af tidsbanksystemet. Kredit:Yu Chen Borgere fra øen Aneityum i Republikken Vanuatu arbejder med fakultetet fra Binghamton University, State University of New York for at teste deres s

Nyt tidsbanksystem bruger blockchain-teknologi til at måle ens værdi for samfundetIllustration af tidsbanksystemet. Kredit:Yu Chen Borgere fra øen Aneityum i Republikken Vanuatu arbejder med fakultetet fra Binghamton University, State University of New York for at teste deres s -

Ransomware-angreb på byer stigerKredit:Shutterstock En ransomware-kampagne, der var rettet mod 23 amerikanske byer i Texas, har rejst alvorlige bekymringer om lokale regeringers og offentlige tjenesters sårbarhed over for cybera

Ransomware-angreb på byer stigerKredit:Shutterstock En ransomware-kampagne, der var rettet mod 23 amerikanske byer i Texas, har rejst alvorlige bekymringer om lokale regeringers og offentlige tjenesters sårbarhed over for cybera -

Sociale medier kan præcist forudsige økonomiske konsekvenser af naturkatastrofer-herunder COVID-19…Tidsserier for det samlede antal Facebook -indlæg foretaget af alle virksomheder i Kathmandu, Nepal viser transformerede udstationeringsaktivitetsdata som følge af den foreslåede metode. Kredit:Univer

Sociale medier kan præcist forudsige økonomiske konsekvenser af naturkatastrofer-herunder COVID-19…Tidsserier for det samlede antal Facebook -indlæg foretaget af alle virksomheder i Kathmandu, Nepal viser transformerede udstationeringsaktivitetsdata som følge af den foreslåede metode. Kredit:Univer

- Video:Overflyvning af Plutos majestætiske bjerge og iskolde sletter

- hård, fleksibel sensor opfundet til bærbar teknologi

- Biokatalysatorer er en bro til grønnere, stærkere kemi

- Højteknologiske rettelser til fødevaresystemet kan få utilsigtede konsekvenser

- Forskere beregner jordens frysedybde ud fra satellitdata

- Forbud mod oliepalme blokerer god praksis