Sensor-pakket handske lærer signaturer af det menneskelige greb

MIT-forskere har udviklet en billig, sensor-pakket handske, der fanger tryksignaler, når mennesker interagerer med genstande. Handsken kan bruges til at skabe højopløselige taktile datasæt, som robotter kan udnytte til bedre at identificere, veje, og manipulere genstande. Kredit:Massachusetts Institute of Technology

Iført en sensor-pakket handske, mens du håndterer en række genstande, MIT-forskere har udarbejdet et massivt datasæt, der gør det muligt for et AI-system at genkende objekter alene gennem berøring. Informationen kunne udnyttes til at hjælpe robotter med at identificere og manipulere objekter, og kan hjælpe med design af proteser.

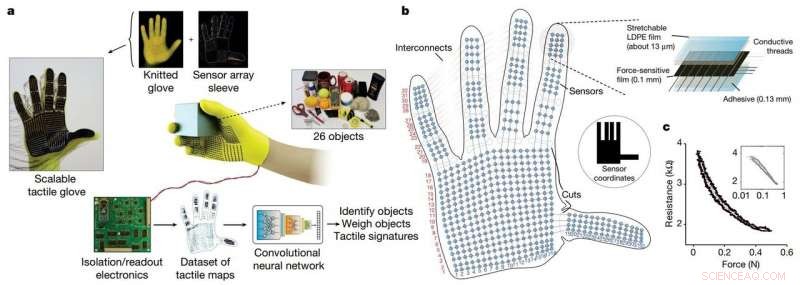

Forskerne udviklede en billig strikket handske, kaldet "skalerbar taktil handske" (STAG), udstyret med omkring 550 bittesmå sensorer på tværs af næsten hele hånden. Hver sensor fanger tryksignaler, når mennesker interagerer med objekter på forskellige måder. Et neuralt netværk behandler signalerne for at "lære" et datasæt af tryksignalmønstre relateret til specifikke objekter. Derefter, systemet bruger dette datasæt til at klassificere objekterne og forudsige deres vægt ved at føle sig alene, uden behov for visuel input.

I et blad udgivet i Natur , forskerne beskriver et datasæt, de kompilerede ved hjælp af STAG til 26 almindelige objekter - inklusive en sodavandsdåse, saks, tennisbold, ske, pen, og krus. Ved hjælp af datasættet, systemet forudsagde objekternes identiteter med op til 76 procents nøjagtighed. Systemet kan også forudsige den korrekte vægt af de fleste genstande inden for omkring 60 gram.

Lignende sensorbaserede handsker, der bruges i dag, løber på tusindvis af dollars og indeholder ofte kun omkring 50 sensorer, der fanger mindre information. Selvom STAG producerer meget høj opløsning data, den er lavet af kommercielt tilgængelige materialer for i alt omkring $10.

Det taktile sensingsystem kunne bruges i kombination med traditionel computervision og billedbaserede datasæt for at give robotter en mere menneskelignende forståelse af interaktion med objekter.

"Mennesker kan identificere og håndtere objekter godt, fordi vi har taktil feedback. Når vi rører ved objekter, vi føler os omkring og indser, hvad de er. Robotter har ikke så rig feedback, " siger Subramanian Sundaram Ph.D. '18, en tidligere kandidatstuderende i Computer Science and Artificial Intelligence Laboratory (CSAIL). "Vi har altid ønsket, at robotter skulle gøre, hvad mennesker kan gøre, som at tage opvasken eller andre gøremål. Hvis du vil have robotter til at gøre disse ting, de skal være i stand til at manipulere objekter rigtig godt."

Forskerne brugte også datasættet til at måle samarbejdet mellem områder af hånden under objektinteraktioner. For eksempel, når nogen bruger mellemleddet af deres pegefinger, de bruger sjældent tommelfingeren. Men spidserne af pege- og langfingeren svarer altid til tommelfingerbrug. "Vi viser kvantificerbart, for første gang, at, hvis jeg bruger en del af min hånd, hvor sandsynligt er det, at jeg bruger en anden del af min hånd, " han siger.

Protetikproducenter kan potentielt bruge information til, sige, vælg optimale steder til placering af tryksensorer og hjælp med at tilpasse proteser til de opgaver og genstande, folk regelmæssigt interagerer med.

Sammen med Sundaram på papiret er:CSAIL postdocs Petr Kellnhofer og Jun-Yan Zhu; CSAIL kandidatstuderende Yunzhu Li; Antonio Torralba, en professor i EECS og direktør for MIT-IBM Watson AI Lab; og Wojciech Matusik, en lektor i elektroteknik og datalogi og leder af Computational Fabrication-gruppen.

STAG som en platform til at lære af det menneskelige greb. Kredit: Natur (2019). DOI:10.1038/s41586-019-1234-z

STAG er lamineret med en elektrisk ledende polymer, der ændrer modstanden over for påført tryk. Forskerne syede ledende tråde gennem huller i den ledende polymerfilm, fra fingerspidserne til bunden af håndfladen. Trådene overlapper hinanden på en måde, der gør dem til tryksensorer. Når nogen, der har handsken på, føler, elevatorer, holder, og taber en genstand, sensorerne registrerer trykket på hvert punkt.

Trådene forbindes fra handsken til et eksternt kredsløb, der oversætter trykdataene til "taktile kort, " som i det væsentlige er korte videoer af prikker, der vokser og krymper hen over en grafik af en hånd. Prikkerne repræsenterer placeringen af trykpunkter, og deres størrelse repræsenterer kraften – jo større prikken er, jo større pres.

Fra disse kort, forskerne kompilerede et datasæt på omkring 135, 000 videobilleder fra interaktioner med 26 objekter. Disse rammer kan bruges af et neuralt netværk til at forudsige objekters identitet og vægt, og give indsigt i det menneskelige greb.

For at identificere objekter, forskerne designet et konvolutionelt neuralt netværk (CNN), som normalt bruges til at klassificere billeder, at forbinde specifikke trykmønstre med specifikke objekter. Men tricket var at vælge rammer fra forskellige typer greb for at få et fuldt billede af objektet.

Ideen var at efterligne den måde, mennesker kan holde et objekt på på et par forskellige måder for at genkende det, uden at bruge deres syn. Tilsvarende forskernes CNN vælger op til otte semirandom frames fra videoen, der repræsenterer de mest uens greb – for eksempel holder et krus fra bunden, top, og håndtere.

Men CNN kan ikke bare vælge tilfældige billeder blandt de tusinder i hver video, eller det vil sandsynligvis ikke vælge tydelige greb. I stedet, den grupperer lignende rammer sammen, resulterer i distinkte klynger svarende til unikke greb. Derefter, den trækker en ramme fra hver af disse klynger, sikre, at den har et repræsentativt udsnit. Derefter bruger CNN de kontaktmønstre, det lærte i træningen, til at forudsige en objektklassificering fra de valgte frames.

"Vi ønsker at maksimere variationen mellem rammerne for at give det bedst mulige input til vores netværk, " Kellnhofer siger. "Alle rammer inde i en enkelt klynge skal have en lignende signatur, der repræsenterer de lignende måder at gribe objektet på. Sampling fra flere klynger simulerer et menneske, der interaktivt forsøger at finde forskellige greb, mens det udforsker et objekt."

Til vægtestimering, forskerne byggede et separat datasæt med omkring 11, 600 billeder fra taktile kort over objekter, der bliver samlet op med finger og tommelfinger, holdt, og faldt. Især CNN blev ikke trænet på nogen frames, det blev testet på, hvilket betyder, at den ikke kunne lære bare at forbinde vægt med en genstand. Ved test, en enkelt frame blev indtastet i CNN. I det væsentlige, CNN udvælger trykket omkring hånden forårsaget af objektets vægt, og ignorerer pres forårsaget af andre faktorer, såsom håndpositionering for at forhindre genstanden i at glide. Derefter beregner den vægten baseret på de passende tryk.

Systemet kunne kombineres med de sensorer, der allerede er på robotled, der måler drejningsmoment og kraft for at hjælpe dem med bedre at forudsige objektvægten. "Leddene er vigtige for at forudsige vægten, men der er også vigtige komponenter af vægt fra fingerspidserne og håndfladen, som vi fanger, " siger Sundaram.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Forskere finder ud af, at tilsætning af silikoneolie øger den sammentrækkende kraft af selv-zip-o…En elektro-origami kran. Kredit:Taghavi et al., Sci. Robot. 3, eaau9795 (2018) En trio af forskere ved University of Bristol har fundet ud af, at tilsætning af en dråbe silikoneolie til modsat lad

Forskere finder ud af, at tilsætning af silikoneolie øger den sammentrækkende kraft af selv-zip-o…En elektro-origami kran. Kredit:Taghavi et al., Sci. Robot. 3, eaau9795 (2018) En trio af forskere ved University of Bristol har fundet ud af, at tilsætning af en dråbe silikoneolie til modsat lad -

En teknik til at forbedre fysisk interaktion i luftrobotterTilt-Hex (NCFTP-antenneplatform med vippede propeller udviklet hos LAAS-CNRS) med den stift fastgjorte sluteffektor. Bemærk, hvordan interaktionen foregår langt væk og off-centreret fra køretøjets CoM

En teknik til at forbedre fysisk interaktion i luftrobotterTilt-Hex (NCFTP-antenneplatform med vippede propeller udviklet hos LAAS-CNRS) med den stift fastgjorte sluteffektor. Bemærk, hvordan interaktionen foregår langt væk og off-centreret fra køretøjets CoM -

Hacky hack hack:Australien teenager bryder Apples sikre netværkPolitiet raidede efter sigende drengens hjem sidste år og fandt hackingfiler og instruktioner gemt i en mappe kaldet hacky hack hack En skoledreng, der drømmede om at arbejde for Apple, hackede fi

Hacky hack hack:Australien teenager bryder Apples sikre netværkPolitiet raidede efter sigende drengens hjem sidste år og fandt hackingfiler og instruktioner gemt i en mappe kaldet hacky hack hack En skoledreng, der drømmede om at arbejde for Apple, hackede fi -

Offentlige rapporter vil vise Firefox-brugeraktivitet, opførselKredit:CC0 Public Domain Hvis der er et ord med blåt bånd, som Mozilla-teammedlemmer elsker, den er åben. Og denne måned markerer den nye Firefox Public Data Report, som udpakker Firefox-brugerakt

Offentlige rapporter vil vise Firefox-brugeraktivitet, opførselKredit:CC0 Public Domain Hvis der er et ord med blåt bånd, som Mozilla-teammedlemmer elsker, den er åben. Og denne måned markerer den nye Firefox Public Data Report, som udpakker Firefox-brugerakt

- Mød Africas fuglemester i vokalimitation

- Kviksølv fra industrialiserede nationer forurener Arktis - her er hvordan det kommer dertil

- Ny arkæologisk forskning undersøger Dark Emus idé om aboriginernes landbrug og landsbyer

- Klimaafgifter på landbruget kan føre til mere fødevareusikkerhed end selve klimaforandringerne

- Probiotika hjælper poppeltræer med at rense toksiner på Superfund-websteder

- Karakteristik af en Proton