Ny teknologi gør internetmemes tilgængelige for mennesker med synshandicap

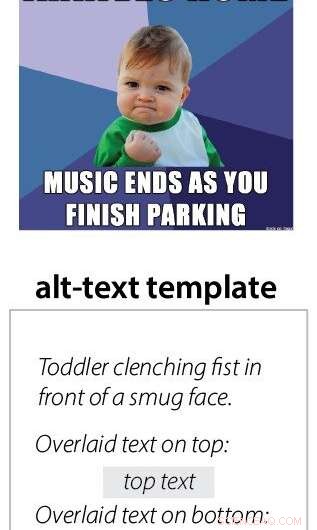

CMU-forskere har udviklet en metode til automatisk at identificere memer og anvende forudskrevne skabeloner til at tilføje beskrivende alt-tekst, gør dem forståelige via hjælpeteknologier som skærmlæsere. Kredit:Carnegie Mellon University

Mennesker med synshandicap bruger sociale medier som alle andre, ofte ved hjælp af skærmlæsersoftware. Men den teknologi kommer til kort, når den støder på memes, som ikke inkluderer alternativ tekst, eller alternativ tekst, for at beskrive, hvad der er afbildet på billedet.

For at imødegå dette, forskere ved Carnegie Mellon University har udviklet en metode til automatisk at identificere memer og anvende forudskrevne skabeloner til at tilføje beskrivende alt-tekst, gør dem forståelige via eksisterende hjælpeteknologier.

Memes er billeder, der kopieres og derefter overlejres med små variationer af tekst. De er ofte humoristiske og formidler en fælles oplevelse, men "hvis du er blind, du savner den del af samtalen, " sagde Cole Gleason, en ph.d. studerende i CMU's Human-Computer Interaction Institute (HCII.)

"Memes virker måske ikke som det vigtigste problem, men en vital del af tilgængelighed er ikke at vælge for folk, hvad der fortjener deres opmærksomhed, " sagde Jeff Bigham, lektor i HCII. "Mange mennesker bruger memes, og derfor bør de gøres tilgængelige."

Memes lever stort set inden for sociale medieplatforme, der har barrierer for at tilføje alt-tekst. Twitter, for eksempel, giver folk mulighed for at tilføje alt-tekst til deres billeder, men den funktion er ikke altid nem at finde. Ud af 9 millioner tweets, som CMU-forskerne undersøgte, en million inkluderede billeder og, af disse, kun 0,1 procent inkluderede alt-tekst.

Gleason sagde, at grundlæggende computersynsteknikker gør det muligt at beskrive de billeder, der ligger til grund for hver meme, om det er en berømthed, en grædende baby, en tegneseriefigur eller en scene såsom en bus, der er væltet i et synkehul. Optiske tegngenkendelsesteknikker bruges til at dechifrere den overlejrede tekst, som kan ændre sig med hver iteration af meme. For hver memetype, det er kun nødvendigt at lave én skabelon, der beskriver billedet, og den overlejrede tekst kan tilføjes for hver iteration af det meme.

Men det viste sig svært at skrive ud, hvad memet skal formidle.

"Det afhang af meme, om humoren blev oversat. Nogle af det visuelle er mere nuanceret, " sagde Gleason. "Og nogle gange er det eksplicit, og du kan bare beskrive det." F.eks. den komplette alt-tekst til det såkaldte "success kid"-meme siger "Toddler clenching fist in front of selvglad face. Overlayed text on top:Was a bad boy all year. Overlayed text on bottom:Tog awesome presents from Santa."

Holdet skabte også en platform til at oversætte memes til lyd i stedet for tekst. Brugere søger gennem et lydbibliotek og træk og slip elementer i en skabelon. Dette system blev lavet til at oversætte eksisterende memes og formidle følelsen gennem musik og lydeffekter.

"En af grundene til, at vi prøvede lydmemes, var fordi vi troede, at alt-tekst ville dræbe joken, men folk foretrak stadig teksten, fordi de er så vant til den, " sagde Gleason.

Det vil være en udfordring at implementere teknologien. Selvom det var integreret i et meme-generatorwebsted, at alt-tekst ikke automatisk ville blive kopieret, når billedet blev delt på sociale medier.

"Vi bliver nødt til at overbevise Twitter om at tilføje en ny funktion, " sagde Gleason. Det kunne være noget tilføjet til en personlig smartphone, men han bemærkede, at det ville lægge byrden på brugeren. CMU-forskere arbejder i øjeblikket på relaterede projekter, herunder en browserudvidelse til Twitter, der forsøger at tilføje alt-tekst til hvert billede og kunne inkludere et meme-system. Et andet projekt søger at integrere alt-tekst i metadataene for billeder, der ville blive med billedet, uanset hvor det blev postet.

Dette arbejde blev præsenteret tidligere i år på ACCESS-konferencen i Pittsburgh. Andre forskere involveret i projektet inkluderer HCII postdoc-stipendiat Amy Pavel, CMU bachelor Xingyu Liu, HCII assisterende professor Patrick Carrington, og Lydia Chilton fra Columbia University.

Varme artikler

Varme artikler

-

Pokemon Go -maker Niantic laver et spil af verdenPokemon Go -skaberen Niantic går videre med en plan om at gøre verden til et kæmpe spillebræt, der blander fantasi og virkelighed Pokemon Go -skaberen Niantic rykkede onsdag tættere på at gøre ver

Pokemon Go -maker Niantic laver et spil af verdenPokemon Go -skaberen Niantic går videre med en plan om at gøre verden til et kæmpe spillebræt, der blander fantasi og virkelighed Pokemon Go -skaberen Niantic rykkede onsdag tættere på at gøre ver -

Chefer, der bruger teknologi til at spionere på personalet, er ved at blive normen, så her er en r…Gotcha. Kredit:Lightspring Arbejdspladsovervågning lyder som mareridt, men vi skal vænne os til det. Som et tegn i tiden, Den Europæiske Menneskerettighedsdomstol har netop afgjort, at et supermar

Chefer, der bruger teknologi til at spionere på personalet, er ved at blive normen, så her er en r…Gotcha. Kredit:Lightspring Arbejdspladsovervågning lyder som mareridt, men vi skal vænne os til det. Som et tegn i tiden, Den Europæiske Menneskerettighedsdomstol har netop afgjort, at et supermar -

Globale handelskrige risikerer millioner af job:WTO-chefUSAs præsident Donald Trump er låst i en handelskrig med Kina, udruller milliarder af dollars i told i et forsøg på at tackle sit handelsunderskud og tøjle, hvad Washington anser for uacceptabel kines

Globale handelskrige risikerer millioner af job:WTO-chefUSAs præsident Donald Trump er låst i en handelskrig med Kina, udruller milliarder af dollars i told i et forsøg på at tackle sit handelsunderskud og tøjle, hvad Washington anser for uacceptabel kines -

Huawei, Meng står over for nye amerikanske anklager for tyveri af forretningshemmelighederAmerikanske anklager for kriminalitet hævder, at den kinesiske teknologigigant Huawei var engageret i en årtier lang indsats for at stjæle forretningshemmeligheder fra amerikanske virksomheder Den

Huawei, Meng står over for nye amerikanske anklager for tyveri af forretningshemmelighederAmerikanske anklager for kriminalitet hævder, at den kinesiske teknologigigant Huawei var engageret i en årtier lang indsats for at stjæle forretningshemmeligheder fra amerikanske virksomheder Den

- Sådan ruster du en Penny

- Opdagelse af efterfølgende komponenter i en koronal masseudstødning

- Kan man stole på virksomheder, efter at reglerne er blevet lempet under pandemien?

- Nogle tidligere havniveauer har måske ikke været så høje som antaget, siger undersøgelse af sti…

- Græshopper den seneste forbandelse fra Østafrikas ekstreme vejrforhold

- Ball Drop Science Projekter