Tilnærmelsesvis en kerne af sandhed

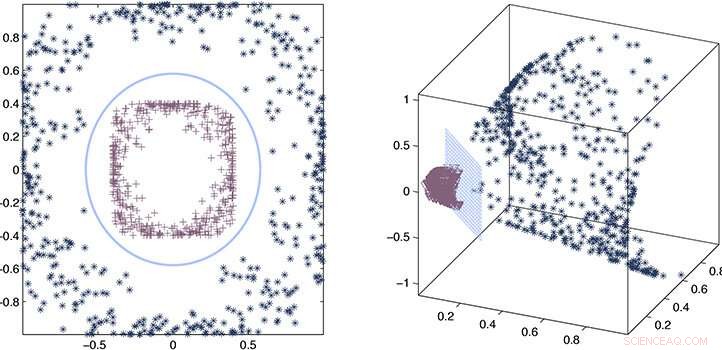

Forskerne brugte en proces med fejlestimering og matematisk tilnærmelse for at bevise, at deres omtrentlige kerne forbliver i overensstemmelse med den nøjagtige kerne. Kredit:2020 Ding et al.

Ved at bruge en omtrentlig snarere end eksplicit "kerne"-funktion til at udtrække relationer i meget store datasæt, KAUST-forskere har været i stand til dramatisk at accelerere hastigheden af maskinlæring. Tilgangen lover i høj grad at forbedre hastigheden af kunstig intelligens (AI) i big data-æraen.

Når AI udsættes for et stort ukendt datasæt, den skal analysere dataene og udvikle en model eller funktion, der beskriver sammenhængene i sættet. Beregningen af denne funktion, eller kerne, er en beregningsintensiv opgave, der øges i kompleksitet kubisk (til tre magt) med størrelsen af datasættet. I en tid med big data og stigende afhængighed af AI til analyse, dette udgør et reelt problem, hvor kernevalg kan blive upraktisk tidskrævende.

Med tilsyn af Xin Gao, Lizhong Ding og hans kolleger har arbejdet på metoder til at fremskynde kernevalg ved hjælp af statistik.

"Den beregningsmæssige kompleksitet af nøjagtig kerneudvælgelse er normalt kubisk med antallet af prøver, " siger Ding. "Denne form for kubisk skalering er uoverkommelig for big data. Vi har i stedet foreslået en tilnærmelsesmetode til kernevalg, hvilket markant forbedrer effektiviteten af kernevalg uden at ofre forudsigelig ydeevne."

Den sande eller nøjagtige kerne giver en ordret beskrivelse af relationer i datasættet. Hvad forskerne fandt er, at statistik kan bruges til at udlede en omtrentlig kerne, der er næsten lige så god som den nøjagtige version, men kan beregnes mange gange hurtigere, lineær skalering, snarere end kubisk, med størrelsen af datasættet.

For at udvikle tilgangen, holdet skulle konstruere specifikt designede kernematricer, eller matematiske arrays, der kunne beregnes hurtigt. De skulle også etablere reglerne og teoretiske grænser for udvælgelsen af den omtrentlige kerne, der stadig ville garantere læringspræstation.

"Den største udfordring var, at vi skulle designe nye algoritmer, der opfylder disse to punkter på samme tid, " siger Ding.

Ved at kombinere en proces med fejlestimering og matematisk tilnærmelse, forskerne var i stand til at bevise, at deres omtrentlige kerne forbliver i overensstemmelse med den nøjagtige kerne og demonstrerede derefter dens ydeevne i rigtige eksempler.

"Vi har vist, at omtrentlige metoder, såsom vores computerramme, give tilstrækkelig nøjagtighed til at løse en kernebaseret læringsmetode, uden den upraktiske beregningsmæssige byrde ved nøjagtige metoder, " siger Ding. "Dette giver en effektiv og effektiv løsning på problemer inden for datamining og bioinformatik, der kræver skalerbarhed."

Varme artikler

Varme artikler

-

Tredje trin øger solcellens ydeevneTeamet bruger løsningsteknikker til at skabe organiske solceller. Kredit:KAUST Et tre-komponent lyshøstlag øger ydeevnen i en organisk solcelle. Tilføjelse af en ekstra ingrediens til det lysopsa

Tredje trin øger solcellens ydeevneTeamet bruger løsningsteknikker til at skabe organiske solceller. Kredit:KAUST Et tre-komponent lyshøstlag øger ydeevnen i en organisk solcelle. Tilføjelse af en ekstra ingrediens til det lysopsa -

Håndtering af energibehovet stiger med sæsonbestemte prognoser for hedebølger og kuldeperioderForskere ønsker at gøre klimaprognoser mere tilgængelige for at hjælpe energi- og andre industrier med bedre at forudsige stigninger i forbruget. Kredit:Pxhere, licenseret under CC0 Virkningen af

Håndtering af energibehovet stiger med sæsonbestemte prognoser for hedebølger og kuldeperioderForskere ønsker at gøre klimaprognoser mere tilgængelige for at hjælpe energi- og andre industrier med bedre at forudsige stigninger i forbruget. Kredit:Pxhere, licenseret under CC0 Virkningen af -

Samsungs aktier stiger, mens Huawei kæmperAktier i verdens største smartphone -producent steg mere end fire procent i eftermiddagshandel Aktierne i Samsung Electronics steg tirsdag næsten tre procent på baggrund af sin chefkonkurrent Huaw

Samsungs aktier stiger, mens Huawei kæmperAktier i verdens største smartphone -producent steg mere end fire procent i eftermiddagshandel Aktierne i Samsung Electronics steg tirsdag næsten tre procent på baggrund af sin chefkonkurrent Huaw -

Ingeniører opfinder smartphone-enhed, der registrerer skadelige alger på 15 minutterSmartphone-enheden kan generere testresultater på stedet, og resultater kan rapporteres i realtid. Kredit:National University of Singapore Et team af ingeniører fra NUS har udviklet et meget følso

Ingeniører opfinder smartphone-enhed, der registrerer skadelige alger på 15 minutterSmartphone-enheden kan generere testresultater på stedet, og resultater kan rapporteres i realtid. Kredit:National University of Singapore Et team af ingeniører fra NUS har udviklet et meget følso

- Forskere løfter sløret for en ny metode til at opdage lungekræft

- Udtalelse:Trumps trussel om løfter om klimaændringer vil ramme Afrika hårdt

- Japan laver et krater på asteroide for at få underjordiske prøver

- Kvinder risikerer gråt hår for at føle sig autentiske

- Paris vil sagsøge Airbnb for uanmeldte annoncer

- Forskning i biovåben er forbudt i henhold til en international traktat, men ingen tjekker for overt…