At lære iCub-robotten at udtrykke grundlæggende menneskelige følelser

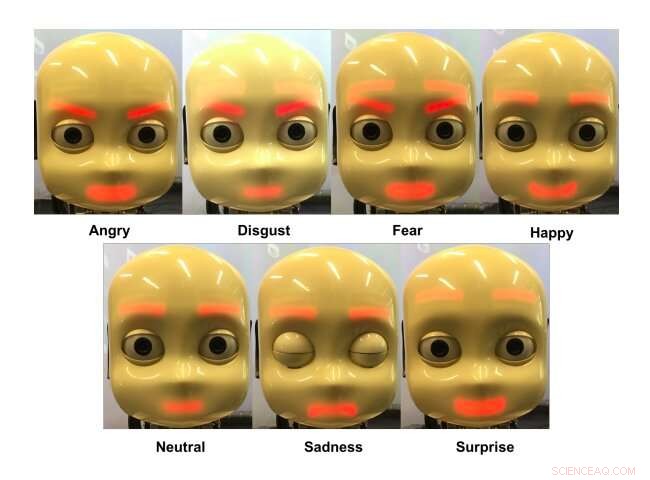

iCub-robotten udtrykker forskellige følelser. Kredit:Churamani et al.

Når robotter kommer ind i en række forskellige miljøer og begynder at interagere med mennesker på en regelmæssig basis, de skal være i stand til at kommunikere med brugerne så effektivt som muligt. I løbet af det seneste årti eller deromkring, forskere verden over har således udviklet maskinlæringsbaserede modeller og andre beregningsteknikker, der kunne forbedre menneske-robot-kommunikation.

En måde at forbedre, hvordan robotter kommunikerer med menneskelige brugere, er ved at træne dem til at udtrykke grundlæggende følelser, såsom tristhed, lykke, frygt og vrede. Evnen til at udtrykke følelser ville i sidste ende give robotter mulighed for at formidle budskaber mere effektivt, på måder, der er tilpasset en given situation.

Forskere ved Universitetet i Hamborg i Tyskland har for nylig udviklet en maskinlæringsbaseret metode til at lære robotter at formidle, hvad der tidligere er blevet defineret som de syv universelle følelser, nemlig vrede, afsky, frygt, lykke, sorg, overraskelse og en neutral tilstand. I deres papir, forudgivet på arXiv, de anvendte og testede deres teknik på en humanoid robot kaldet iCub.

Den nye tilgang foreslået af forskerne henter inspiration fra en tidligere udviklet ramme kaldet TAMER. TAMER er en algoritme, der kan bruges til at træne multilayer perceptrons (MLP'er), en klasse af kunstige neurale netværk (ANN'er).

I den nylige undersøgelse, TAMER-rammen blev tilpasset til at træne en maskinlæringsbaseret model til at formidle forskellige menneskelige følelser ved at producere forskellige ansigtsudtryk i iCub-robotten. iCub er en open source robotplatform udviklet af et forskerhold ved det italienske teknologiske institut (IIT) som en del af EU-projektet RobotCub, som ofte bruges i robotforskning til at evaluere maskinlæringsalgoritmer.

"Roboten bruger en kombination af et konvolutionelt neuralt netværk (CNN) og et selvorganiserende kort (SOM) til at genkende en følelse og lærer derefter at udtrykke det samme ved hjælp af en MLP, " skrev forskerne i deres papir. "Vores mål var at lære en robot at reagere tilstrækkeligt på en brugers opfattelse af følelser og lære at udtrykke forskellige følelser."

CNN, som forskerne brugte, analyserer billeder af en menneskelig brugers ansigtsudtryk, fanget af iCub-robotten. Ansigtsgengivelserne produceret af denne analyse føres derefter til en SOM, som afslører særlige mønstre i, hvordan brugeren udtrykte en bestemt følelse.

Efterfølgende disse mønstre er modelleret og brugt til at træne en MLP til at forudsige, hvordan iCubs ansigtstræk kan tilpasses til bedst at efterligne brugerens ansigtsudtryk. Den menneskelige bruger belønner derefter robotten baseret på, hvor præcist den udtrykte en given følelse.

"Når iCub'en udfører og handling, brugeren forventes at belønne det, hvilket giver den en målværdi at opnå, " forklarede forskerne i deres papir. "Dette gøres ved at bede brugeren om at efterligne robotten, give den information om, hvor meget den udførte handling afviger fra den tilsigtede handling."

Over tid, baseret på de belønninger, den modtager fra menneskelige brugere, den ramme, forskerne har udtænkt, bør lære at udtrykke hver af de syv universelle følelser. Indtil nu, Teknikken er blevet evalueret i en række foreløbige eksperimenter ved hjælp af iCub-robotplatformen, opnår ret lovende resultater.

"Selvom resultaterne var lovende, og det reducerede den nødvendige tid til træning markant, vores metode krævede stadig mere end 100 interaktioner pr. bruger for at lære meningsfulde udtryk, "siger forskerne." Dette antal forventes at falde med forbedringer i træningsmetoder og ved at indsamle flere data til træning. "

© 2020 Science X Network

Varme artikler

Varme artikler

-

USA skal reducere afhængigheden af fossile brændstoffer, men parterne er uenige om, hvordan det …Kredit:CC0 Public Domain Begge sider af det politiske spektrum erkender et behov for at reducere amerikansk afhængighed af kulstofbaserede energikilder, men hvordan nationen gør det er stadig et s

USA skal reducere afhængigheden af fossile brændstoffer, men parterne er uenige om, hvordan det …Kredit:CC0 Public Domain Begge sider af det politiske spektrum erkender et behov for at reducere amerikansk afhængighed af kulstofbaserede energikilder, men hvordan nationen gør det er stadig et s -

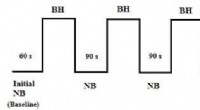

Brug af fotoplethysmografisignal til matematisk modellering af arterielt blodtrykTidsdiagram over protokoller (NB:Normal vejrtrækning, BH:Hold vejret). Kredit:Soltan zadi et al. Et team af forskere ved University of Texas i Arlington og University of Texas Southwestern har for

Brug af fotoplethysmografisignal til matematisk modellering af arterielt blodtrykTidsdiagram over protokoller (NB:Normal vejrtrækning, BH:Hold vejret). Kredit:Soltan zadi et al. Et team af forskere ved University of Texas i Arlington og University of Texas Southwestern har for -

Forskere:AI -overvågning udvides på verdensplanI denne 26. februar, 2019, fil fotopendlere går med overvågningskameraer installeret ved en gangbro mellem to metrostationer i Beijing. Carnegie Endowment for International Peace offentliggjorde en ra

Forskere:AI -overvågning udvides på verdensplanI denne 26. februar, 2019, fil fotopendlere går med overvågningskameraer installeret ved en gangbro mellem to metrostationer i Beijing. Carnegie Endowment for International Peace offentliggjorde en ra -

GE skærer over 1, 000 arbejdspladser i fransk eldriftGE har annonceret endnu en bølge af nedskæringer i Frankrig, da det kæmper med faldende efterspørgsel efter sine gasturbinedrift Det amerikanske industrikonglomerat General Electric sagde tirsdag,

GE skærer over 1, 000 arbejdspladser i fransk eldriftGE har annonceret endnu en bølge af nedskæringer i Frankrig, da det kæmper med faldende efterspørgsel efter sine gasturbinedrift Det amerikanske industrikonglomerat General Electric sagde tirsdag,

- Ny teknik fører til oprettelse af elastisk højstyrke carbon nanorørfilm

- Februar lockdown i Kina forårsagede et fald i nogle typer luftforurening, men ikke andre

- Cambridge Analytica kæmper tilbage på dataskandaler

- Ny hurtig test registrerer kvalitet og ægthed af olivenolie

- Forskere opdager AI-informations-skjulende adfærd til senere brug

- Sådan beregnes Square Miles