Forskere opdager AI-informations-skjulende adfærd til senere brug

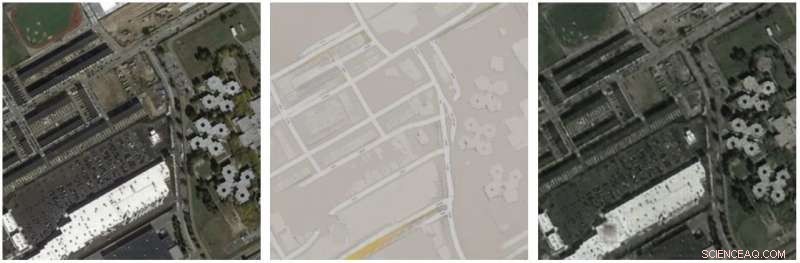

Detaljer i x er rekonstrueret i GF x, på trods af at det ikke fremgår af mellemkortet F x. Kredit:arXiv:1712.02950 [cs.CV]

Kald det klogt, mærke det som en snyder, men skam dig ikke over at finde det frygtelig interessant. "Det" er CycleGAN, og dets link til steganografi - hvor meddelelser og oplysninger er skjult i ikke -hemmelig tekst eller data.

Så, i 2019 kan det ikke være så chokerende for folk at lære, at en maskine, ikke et menneske, kan snyde sig selv om en opgave. AI i dette tilfælde, som gode menneskelige spioner og ulemper, lært, hvornår man skal skjule nogle oplysninger, der kan bruges senere.

I Pakket , ' da detaljerne var blevet forstærket, det var klart, at maskinen havde foretaget tusindvis af bittesmå farveændringer, der indikerede visuelle data, der kunne bruges som et snydeblad ved genskabelse af luftbilledet - derfor de magisk ovenlysvinduer. "

I mellemtiden, en meget citeret artikel om emnet (forskningen var dækket af en række teknologiske overvågningssider, faktisk) kapslede hvad forskerne opdagede. "Et maskinlæringsmiddel, der havde til formål at omdanne luftbilleder til gadekort og ryggen, viste sig at være snyd ved at skjule oplysninger, som det senere skulle have brug for i 'en næsten umærkelig, højfrekvent signal, " sagde TechCrunch .

Lily Hay Newman i Kablet i 2017 mindede læserne om, at steganografi er en gammel praksis, intet født i går. Tænk Da Vinci indlejrer hemmelig betydning i et maleri; eller yesterys spioner, der skrev med usynligt blæk.

Hvis øvelsen er gammel, selvom, der er nogle samtidige problemer. Vi er, trods alt, i en digital verden, hvor alle laster og dyder har taget nye processer online.

Steganografi bliver kun sværere at få øje på, sagde BankInfoSecurity , og er "allerede blevet taget i brug af dårlige skuespillere."

Mathew Schwartz sagde, at digital steganografi syntes at gøre livet vanskeligere for retshåndhævende myndigheder og citerede en universitetsprofessor, der passerede en lignende bemærkning. "En fuldstændig benægtende steganografisk diskkryptering bliver et mareridt, når det kommer til at indsamle digital bevis, "sagde Alan Woodward, professor i datalogi ved University of Surrey.

Spol frem til rapporter, der er i nu, at en gruppe Stanford- og Google -forskere udførte en undersøgelse af, hvordan et neuralt netværk, CycleGAN, lærer at snyde. Papiret:CycleGAN, en Master of Steganography er på arXiv, og de tre forfattere er Casey Chu (Stanford), Andrey Zhmoginov (Google) og Mark Sandler (Google).

De skrev, "CycleGAN lærer at 'skjule' oplysninger om et kildebillede i de billeder, det genererer i en næsten umærkelig, højfrekvent signal. "

Som en del af deres diskussionsafdeling, forfatterne gør opmærksom på, at "Ved at kode oplysninger på denne måde, CycleGAN bliver særligt sårbar over for modstandsangreb; en angriber kan få en af de indlærte transformationer til at producere et billede efter eget valg ved at forstyrre ethvert valgt kildebillede. "

Deres råd? De skrev, at "tilstedeværelsen af dette fænomen indikerer, at forsigtighed er nødvendig, når der designes tabsfunktioner, der involverer sammensætninger af neurale netværk:sådanne modeller kan opføre sig på en uintuitiv måde, hvis en komponent udnytter den anden komponents evne til at understøtte modstridende eksempler."

Fælles rammer, ifølge forfatterne, såsom generative modsætningsnetværk og perceptuelle tab bruger disse sammensætninger. De sagde, at "disse rammer bør analyseres omhyggeligt for at sikre, at modstridende eksempler ikke er et problem."

Men vent. Skal vi løbe for bakkerne med skrigende frygt for, at robotter og AI vil afslutte os alle? Heldigvis, Devin Coldewey beroligede læserne TechCrunch . Forekomsten "afslører simpelthen et problem med computere, der har eksisteret siden de blev opfundet:de gør præcis, hvad du fortæller dem at gøre."

Hvad mente Coldewey med det? "Forskernes hensigt var, som du måske gætter, at fremskynde og forbedre processen med at omdanne satellitbilleder til Googles berømte nøjagtige kort. Til det formål arbejdede teamet med det, der kaldes et CycleGAN - et neuralt netværk, der lærer at omdanne billeder af type X og Y til hinanden, så effektivt men præcist som muligt, gennem en masse eksperimenter. "

Computeren nåede frem til en løsning ", der belyste en mulig svaghed ved denne type neurale netværk - at computeren, hvis det ikke eksplicit er forhindret i at gøre det, vil i det væsentlige finde en måde at overføre detaljer til sig selv for at løse et givet problem hurtigt og nemt. "

© 2019 Science X Network

Varme artikler

Varme artikler

-

Varme eller spise? Hvordan en energibesparelsesstrategi kan skade sårbare befolkningerKredit:CC0 Public Domain Alle økonomiske og bevaringsmæssige fordele forbundet med forbrugstidsregning af el kan opnås på bekostning af nogle af de mest sårbare borgere i vores samfund:mennesker m

Varme eller spise? Hvordan en energibesparelsesstrategi kan skade sårbare befolkningerKredit:CC0 Public Domain Alle økonomiske og bevaringsmæssige fordele forbundet med forbrugstidsregning af el kan opnås på bekostning af nogle af de mest sårbare borgere i vores samfund:mennesker m -

Fuselage af ny Boeing 777X bristede i tryktestBoeing gør, après la krise du 737 MAX, rassurer ses clients sur le long courrier 777X Skroget på et af Boeings nye 777X-fly sprængte fuldstændigt i trykprøver i september, et tidligere urapportere

Fuselage af ny Boeing 777X bristede i tryktestBoeing gør, après la krise du 737 MAX, rassurer ses clients sur le long courrier 777X Skroget på et af Boeings nye 777X-fly sprængte fuldstændigt i trykprøver i september, et tidligere urapportere -

100 år siden, luftpost tog flyveturenDen franske flyver Jean Mermoz var en af pionererne i Aeropostale Den 25. december, 1918 lancerede en vovet fransk industrimand verdens første luftposttjeneste nogensinde, flyver mellem den sydv

100 år siden, luftpost tog flyveturenDen franske flyver Jean Mermoz var en af pionererne i Aeropostale Den 25. december, 1918 lancerede en vovet fransk industrimand verdens første luftposttjeneste nogensinde, flyver mellem den sydv -

Teknologi kan gøre indsamling og analyse af beviser for politik lettereMed så meget forskning, data og beviser i verden, det er svært at samle det på en nyttig måde. Kredit:Shutterstock Der produceres mere og mere forskning rundt om i verden hver dag. I alt, omkring

Teknologi kan gøre indsamling og analyse af beviser for politik lettereMed så meget forskning, data og beviser i verden, det er svært at samle det på en nyttig måde. Kredit:Shutterstock Der produceres mere og mere forskning rundt om i verden hver dag. I alt, omkring

- Snoet lys kunne belyse ny vej til trådløs kommunikation

- Afbrydelse rammer Facebook, Instagram -brugere verden over

- Advarselssystem kan have reddet liv i den indonesiske tsunami

- Hollandske familier slutter sig til folks gård for at modvirke klimaændringer

- Forskere opdagede, hvilke gener der forårsager uoverkommeligt hårsyndrom

- Digital afhængighed – hvordan teknologi holder os hooked