AI, der kan lære det menneskelige sprogs mønstre

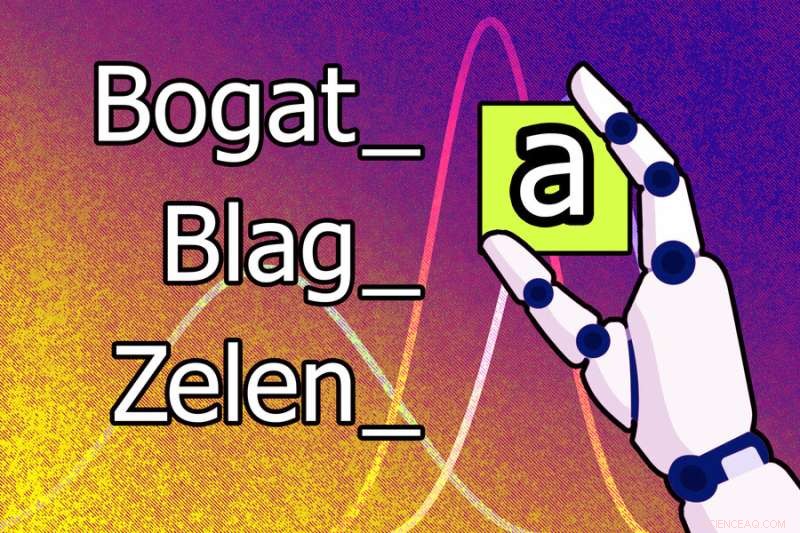

En ny maskinlæringsmodel vil måske lære, at bogstavet "a" skal tilføjes til slutningen af et ord for at gøre den maskuline form feminin på serbokroatisk. For eksempel bliver den maskuline form af ordet "bogat" den feminine "bogata". Kredit:Jose-Luis Olivares, MIT

Menneskelige sprog er notorisk komplekse, og lingvister har længe troet, at det ville være umuligt at lære en maskine at analysere talelyde og ordstrukturer på den måde, som menneskelige efterforskere gør.

Men forskere ved MIT, Cornell University og McGill University har taget et skridt i denne retning. De har demonstreret et kunstig intelligenssystem, der kan lære reglerne og mønstrene for menneskelige sprog på egen hånd.

Når der gives ord og eksempler på, hvordan disse ord ændrer sig for at udtrykke forskellige grammatiske funktioner (som tid, kasus eller køn) på ét sprog, kommer denne maskinlæringsmodel med regler, der forklarer, hvorfor disse ords former ændres. For eksempel kan det lære, at bogstavet "a" skal tilføjes til slutningen af et ord for at gøre den hankønsform feminin på serbokroatisk.

Denne model kan også automatisk lære sprogmønstre på højere niveau, der kan gælde for mange sprog, hvilket gør det muligt for den at opnå bedre resultater.

Forskerne trænede og testede modellen ved hjælp af problemer fra sproglige lærebøger, der indeholdt 58 forskellige sprog. Hver opgave havde et sæt ord og tilsvarende ordformændringer. Modellen var i stand til at komme med et korrekt sæt regler til at beskrive disse ordformændringer for 60 % af problemerne.

Dette system kunne bruges til at studere sproghypoteser og undersøge subtile ligheder i måden forskellige sprog transformerer ord på. Det er især unikt, fordi systemet opdager modeller, der let kan forstås af mennesker, og det erhverver disse modeller fra små mængder data, såsom et par dusin ord. Og i stedet for at bruge ét massivt datasæt til en enkelt opgave, bruger systemet mange små datasæt, hvilket er tættere på, hvordan videnskabsmænd foreslår hypoteser – de ser på flere relaterede datasæt og kommer med modeller til at forklare fænomener på tværs af disse datasæt.

"En af motivationerne for dette arbejde var vores ønske om at studere systemer, der lærer modeller af datasæt, der er repræsenteret på en måde, som mennesker kan forstå. Kan modellen i stedet for at lære vægte lære udtryk eller regler? Og vi ville se, om vi kunne bygge dette system, så det ville lære på et helt batteri af indbyrdes forbundne datasæt, for at få systemet til at lære lidt om, hvordan man bedre modellerer hvert enkelt," siger Kevin Ellis, assisterende professor i datalogi ved Cornell University og hovedforfatter af papiret.

Sammen med Ellis på papiret er MIT-fakultetets medlemmer Adam Albright, en professor i lingvistik; Armando Solar-Lezama, professor og associeret direktør for Computer Science and Artificial Intelligence Laboratory (CSAIL); og Joshua B. Tenenbaum, Paul E. Newtons karriereudviklingsprofessor i kognitiv videnskab og beregning i afdelingen for hjerne- og kognitiv videnskab og medlem af CSAIL; samt seniorforfatter Timothy J. O'Donnell, assisterende professor i Department of Linguistics ved McGill University, og Canada CIFAR AI Chair ved Mila—Quebec Artificial Intelligence Institute.

Forskningen er offentliggjort i dag i Nature Communications .

Ser på sprog

I deres søgen efter at udvikle et AI-system, der automatisk kunne lære en model fra flere relaterede datasæt, valgte forskerne at udforske interaktionen mellem fonologi (studiet af lydmønstre) og morfologi (studiet af ordstruktur).

Data fra sproglige lærebøger tilbød en ideel testbed, fordi mange sprog deler kernetræk, og lærebogsproblemer viser specifikke sproglige fænomener. Lærebogsproblemer kan også løses af universitetsstuderende på en ret ligetil måde, men disse studerende har typisk forudgående viden om fonologi fra tidligere lektioner, de bruger til at ræsonnere om nye problemer.

Ellis, der fik sin ph.d. ved MIT og blev i fællesskab rådgivet af Tenenbaum og Solar-Lezama, lærte først om morfologi og fonologi i en MIT-klasse undervist af O'Donnell, som var postdoc på det tidspunkt, og Albright.

"Sprogforskere har tænkt, at for virkelig at forstå reglerne for et menneskeligt sprog, for at kunne indleve sig i, hvad det er, der får systemet til at tikke, skal man være menneske. Vi ville se, om vi kan efterligne den slags viden og ræsonnementer, som mennesker (lingvister) tager med til opgaven," siger Albright.

For at bygge en model, der kunne lære et sæt regler for sammensætning af ord, som kaldes en grammatik, brugte forskerne en maskinlæringsteknik kendt som Bayesian Program Learning. Med denne teknik løser modellen et problem ved at skrive et computerprogram.

I dette tilfælde er programmet den grammatik, modellen mener er den mest sandsynlige forklaring af ordene og betydningerne i et sprogligt problem. De byggede modellen ved hjælp af Sketch, en populær programsynthesizer, som blev udviklet på MIT af Solar-Lezama.

Men Sketch kan tage meget tid at ræsonnere om det mest sandsynlige program. For at komme uden om dette fik forskerne modellen til at arbejde et stykke ad gangen, hvor de skrev et lille program for at forklare nogle data, og derefter skrev et større program, der modificerer det lille program til at dække flere data, og så videre.

De har også designet modellen, så den lærer, hvordan "gode" programmer plejer at se ud. For eksempel kan det lære nogle generelle regler om simple russiske problemer, som det ville gælde for et mere komplekst problem på polsk, fordi sprogene ligner hinanden. Dette gør det nemmere for modellen at løse det polske problem.

Læsning af lærebogsproblemer

Da de testede modellen ved hjælp af 70 lærebogsopgaver, var den i stand til at finde en grammatik, der matchede hele sættet af ord i opgaven i 60 % af tilfældene og matchede korrekt de fleste af ordformsændringerne i 79 % af problemerne.

Forskerne forsøgte også at forprogrammere modellen med en vis viden, den "skulle" have lært, hvis den tog et lingvistikkursus, og viste, at den kunne løse alle problemer bedre.

"En udfordring i dette arbejde var at finde ud af, om det, modellen lavede, var rimeligt. Dette er ikke en situation, hvor der er ét tal, der er det eneste rigtige svar. Der er en række mulige løsninger, som du kan acceptere som rigtige, tæt på højre osv.," siger Albright.

Modellen kom ofte med uventede løsninger. I et tilfælde opdagede den det forventede svar på et polsk sprogproblem, men også et andet korrekt svar, der udnyttede en fejl i lærebogen. Dette viser, at modellen kunne "fejle" lingvistiske analyser, siger Ellis.

Forskerne udførte også test, der viste, at modellen var i stand til at lære nogle generelle skabeloner af fonologiske regler, der kunne anvendes på tværs af alle problemer.

"En af de ting, der var mest overraskende, er, at vi kunne lære på tværs af sprog, men det så ikke ud til at gøre den store forskel," siger Ellis. "Det tyder på to ting. Måske har vi brug for bedre metoder til at lære på tværs af problemer. Og måske, hvis vi ikke kan finde på disse metoder, kan dette arbejde hjælpe os med at undersøge forskellige ideer, vi har om, hvilken viden vi skal dele på tværs af problemer."

I fremtiden vil forskerne bruge deres model til at finde uventede løsninger på problemer i andre domæner. De kunne også anvende teknikken til flere situationer, hvor viden på højere niveau kan anvendes på tværs af indbyrdes relaterede datasæt. For eksempel kunne de måske udvikle et system til at udlede differentialligninger fra datasæt om bevægelsen af forskellige objekter, siger Ellis.

"Dette arbejde viser, at vi har nogle metoder, som til en vis grad kan lære induktive skævheder. Men jeg tror ikke, vi helt har fundet ud af, selv for disse lærebogsproblemer, den induktive skævhed, der lader en lingvist acceptere de plausible grammatikker og afvis de latterlige," tilføjer han.

"Dette arbejde åbner op for mange spændende steder for fremtidig forskning. Jeg er især fascineret af muligheden for, at den tilgang, som Ellis og kolleger har udforsket (Bayesian Program Learning, BPL) kan tale om, hvordan spædbørn tilegner sig sprog," siger T. Florian Jaeger, en professor i hjerne- og kognitiv videnskab og datalogi ved University of Rochester, som ikke var forfatter til dette papir.

"Fremtidigt arbejde kan for eksempel spørge, under hvilke yderligere induktionsbias (antagelser om universel grammatik) BPL-tilgangen med succes kan opnå menneskelignende læringsadfærd på den type data, spædbørn observerer under sprogtilegnelse. Jeg tror, det ville være fascinerende at se om induktive skævheder, der er endnu mere abstrakte end dem, Ellis og hans team betragter - såsom skævheder, der stammer fra grænserne for menneskelig informationsbehandling (f.eks. hukommelsesbegrænsninger på afhængighedslængde eller kapacitetsgrænser i mængden af information, der kan behandles pr. gang )—ville være tilstrækkeligt til at fremkalde nogle af de mønstre, der observeres i menneskelige sprog." + Udforsk yderligere

Maskinlæringsmodel kan identificere handlingen i et videoklip og mærke den uden hjælp fra mennesker

Varme artikler

Varme artikler

-

Kan FraudBuster hjælpe forsikringsselskaber med at bruge big data til at bekæmpe svindel?Kredit:Mary Ann Liebert, Inc., forlag FraudBuster er en ny datadrevet tilgang designet til at hjælpe forsikringsselskaber på markeder med høj svindelrate, såsom bilforsikringsmarkedet, proaktivt i

Kan FraudBuster hjælpe forsikringsselskaber med at bruge big data til at bekæmpe svindel?Kredit:Mary Ann Liebert, Inc., forlag FraudBuster er en ny datadrevet tilgang designet til at hjælpe forsikringsselskaber på markeder med høj svindelrate, såsom bilforsikringsmarkedet, proaktivt i -

All-perovskite tandem solceller med 24,8% effektivitetEt fotografi af en hel-perovskite tandem solcelle fremstillet af forskerne. Kredit:Lin et al. Et team af forskere ved Nanjing University i Kina og University of Toronto i Canada har for nylig frem

All-perovskite tandem solceller med 24,8% effektivitetEt fotografi af en hel-perovskite tandem solcelle fremstillet af forskerne. Kredit:Lin et al. Et team af forskere ved Nanjing University i Kina og University of Toronto i Canada har for nylig frem -

Amazon tilbyder kasseløs teknologi til rivaliserende detailhandlereEn shopper forlader Amazon Go Grocery den 26. februar, 2020 i Seattle, Washington, den første dagligvarebutik i fuld størrelse, der bruger den kassefrie model Amazon begyndte mandag at tilbyde sin

Amazon tilbyder kasseløs teknologi til rivaliserende detailhandlereEn shopper forlader Amazon Go Grocery den 26. februar, 2020 i Seattle, Washington, den første dagligvarebutik i fuld størrelse, der bruger den kassefrie model Amazon begyndte mandag at tilbyde sin -

Sådan laver du en remskive til børnMåske lærer du om enkle maskiner, eller måske er du bare interesseret i, hvordan de fungerer. I begge tilfælde er en god måde at få nogle praktisk erfaring med enkle maskiner på at bygge din egen rems

Sådan laver du en remskive til børnMåske lærer du om enkle maskiner, eller måske er du bare interesseret i, hvordan de fungerer. I begge tilfælde er en god måde at få nogle praktisk erfaring med enkle maskiner på at bygge din egen rems

- Sådan laver du en 3D topografisk kort til et skoleprojekt

- IBMs lab-on-a-chip gennembrud har til formål at hjælpe læger med at opdage kræft

- Bekymring for klimaet, da Sveriges højeste top smelter væk (Opdatering)

- Mystiske cellulære dråber kommer i fokus

- Taber flad øl sit alkoholindhold?

- Flyveaske geopolymerbeton:Betydeligt forbedret modstandsdygtighed over for ekstremt alkaliangreb