Forskere udvikler nye strategier til at lære computere at lære ligesom mennesker gør

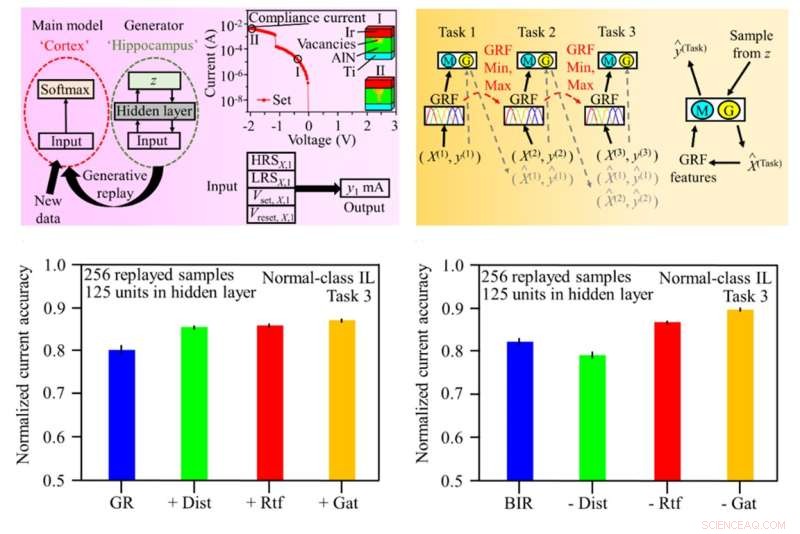

Grafik af den generative replay-opsætning (øverst venstre panel) og skema til træning af kunstigt neuralt netværk (ANN) med generativ replay (øverst højre panel). Den normaliserede elektriske strømnøjagtighed for de konventionelle (nederste venstre panel) og hjerneinspirerede replay (BIR) modeller (nederste højre panel). Kredit:SUTD

Som demonstreret af gennembrud inden for forskellige områder af kunstig intelligens (AI), såsom billedbehandling, smart sundhedspleje, selvkørende køretøjer og smarte byer, er dette uden tvivl den gyldne periode med dyb læring. I løbet af det næste årti eller deromkring vil kunstig intelligens og computersystemer i sidste ende blive udstyret med evnen til at lære og tænke på den måde, som mennesker gør – at behandle kontinuerlig informationsstrøm og interagere med den virkelige verden.

Nuværende AI-modeller lider dog af et ydeevnetab, når de trænes fortløbende på ny information. Dette skyldes, at hver gang nye data genereres, skrives de oven på eksisterende data, og dermed slettes tidligere information. Denne effekt er kendt som "katastrofal glemsel." En vanskelighed opstår fra stabilitet-plasticitet-problemet, hvor AI-modellen skal opdatere sin hukommelse for løbende at tilpasse sig den nye information og samtidig bevare stabiliteten af sin nuværende viden. Dette problem forhindrer state-of-the-art AI i konstant at lære af oplysninger fra den virkelige verden.

Edge computing-systemer gør det muligt at flytte computere fra cloud-lageret og datacentrene til tæt på den originale kilde, såsom enheder, der er forbundet til Internet of Things (IoT'er). Det er fortsat en udfordring at anvende kontinuerlig læring effektivt på ressourcebegrænsede computersystemer, selvom mange modeller for kontinuerlig læring er blevet foreslået for at løse dette problem. Traditionelle modeller kræver høj computerkraft og stor hukommelseskapacitet.

En ny type kode til at realisere et energieffektivt kontinuerligt læringssystem er for nylig blevet designet af et team af forskere fra Singapore University of Technology and Design (SUTD), herunder Shao-Xiang Go, Qiang Wang, Bo Wang, Yu Jiang og Natasa Bajalovic. Holdet blev ledet af hovedforsker, adjunkt Desmond Loke fra SUTD. Undersøgelsen af disse forskere, "Continual Learning Electrical Conduction in Resistive-Switching-Memory Materials," blev offentliggjort i tidsskriftet Advanced Theory and Simulations .

Holdet foreslog Brain-Inspired Replay (BIR), en model inspireret af hjernen, som udfører kontinuerlig læring naturligt. BIR-modellen, baseret på brugen af et kunstigt neuralt netværk og en variationsautoencoder, imiterer den menneskelige hjernes funktioner og kan fungere godt i klassetrinvise læringssituationer uden at lagre data. Forskerne brugte også BIR-modellen til at repræsentere ledende filamentvækst ved hjælp af elektrisk strøm i digitale hukommelsessystemer.

"I denne model er viden bevaret i trænede modeller for at minimere ydeevnetab ved introduktion af yderligere opgaver, uden at det er nødvendigt at referere til data fra tidligere arbejder," forklarede adjunkt Loke. "Så dette sparer os en betydelig mængde energi."

"Ydermere blev der opnået en avanceret nøjagtighed på 89% på udfordrende overholdelse af aktuelle læringsopgaver uden at lagre data, hvilket er omkring to gange højere end traditionelle modeller for kontinuerlig læring, samt høj energieffektivitet," " tilføjede han.

For at give modellen mulighed for uafhængigt at behandle information på stedet i den virkelige verden planlægger teamet at udvide modellens justerbare muligheder i den næste fase af deres forskning.

"Baseret på demonstrationer i lille skala er denne forskning stadig i sin tidlige fase," sagde adjunkt Loke. "Adoptionen af denne tilgang forventes at give Edge AI-systemer mulighed for at udvikle sig uafhængigt uden menneskelig kontrol." + Udforsk yderligere

En kunstig synapse med ultralav effekt til næste generations AI-systemer

Varme artikler

Varme artikler

-

Uber introducerer Express Pool service, der lyder lidt som en busFørst, Uber indrammede sig selv som et alternativ til taxaer. Nu ruller San Francisco-selskabet ud for en ny service, der ligner en bus. Ride-hailing virksomheden introducerer Express Pool til flere

Uber introducerer Express Pool service, der lyder lidt som en busFørst, Uber indrammede sig selv som et alternativ til taxaer. Nu ruller San Francisco-selskabet ud for en ny service, der ligner en bus. Ride-hailing virksomheden introducerer Express Pool til flere -

Ny rapport søger at sikre vandkraft bæredygtighed midt i klimaændringerORNL studerer, hvordan klimaændringer kan påvirke vandtilgængeligheden til vandkraftanlæg såsom Shasta Dam og Lake i Californien. Kredit:U.S. Bureau of Reclamation Det amerikanske energiministerium

Ny rapport søger at sikre vandkraft bæredygtighed midt i klimaændringerORNL studerer, hvordan klimaændringer kan påvirke vandtilgængeligheden til vandkraftanlæg såsom Shasta Dam og Lake i Californien. Kredit:U.S. Bureau of Reclamation Det amerikanske energiministerium -

Dine rødder viser:Fotoredigeringsapps stiger, efter at saloner er lukket midt i coronavirusKredit:CC0 Public Domain Faith Zellman brugte fotoredigeringsappen Facetune til at pifte sit hår op, da alle saloner i byen er lukket på grund af coronavirus. Den 24-årige bartender mistede for n

Dine rødder viser:Fotoredigeringsapps stiger, efter at saloner er lukket midt i coronavirusKredit:CC0 Public Domain Faith Zellman brugte fotoredigeringsappen Facetune til at pifte sit hår op, da alle saloner i byen er lukket på grund af coronavirus. Den 24-årige bartender mistede for n -

Digital autoritarisme i kinesisk stil vokser globalt:studieKinesiske embedsmænd har holdt sessioner om kontrol af information med 36 af de 65 lande vurderet af en menneskerettighedsundersøgelse Regeringer verden over optrapper brugen af onlineværktøjer,

Digital autoritarisme i kinesisk stil vokser globalt:studieKinesiske embedsmænd har holdt sessioner om kontrol af information med 36 af de 65 lande vurderet af en menneskerettighedsundersøgelse Regeringer verden over optrapper brugen af onlineværktøjer,

- Miljøvenlig medicinproduktion Nobelvinderens stolteste præstation

- Lyskontrollerede lægemiddelfrie makromolekyler til præcis tumorterapi

- Samsung lancerer foldbar smartphone efter større forsinkelse

- Udskriv dit eget mikroskop i laboratoriekvalitet for 18 $

- Sådan bestemmes Shock Spring Rate

- Sådan læses vindretning på vejrkort