Det selvkørende trolleyproblem:Hvordan vil fremtidige AI-systemer træffe de mest etiske valg for os alle?

Kredit:Shutterstock

Kunstig intelligens (AI) træffer allerede beslutninger inden for områderne forretning, sundhedspleje og fremstilling. Men AI-algoritmer får generelt stadig hjælp fra folk, der anvender checks og foretager det sidste opkald.

Hvad ville der ske, hvis AI-systemer skulle træffe uafhængige beslutninger, og dem, der kunne betyde liv eller død for mennesker?

Popkulturen har længe skildret vores generelle mistillid til AI. I sci-fi-filmen "I, Robot" fra 2004 er detektiv Del Spooner (spillet af Will Smith) mistænksom over for robotter efter at være blevet reddet af en fra en bilulykke, mens en 12-årig pige blev efterladt til at drukne. Han siger:"Jeg var det logiske valg. Det beregnede, at jeg havde 45 % chance for at overleve. Sarah havde kun en chance på 11 %. Det var en persons baby - 11 % er mere end nok. Et menneske ville have vidst det ."

I modsætning til mennesker mangler robotter en moralsk samvittighed og følger den "etik", der er programmeret ind i dem. Samtidig er den menneskelige moral meget varierende. Den "rigtige" ting at gøre i enhver situation vil afhænge af, hvem du spørger.

For at maskiner kan hjælpe os til deres fulde potentiale, skal vi sørge for, at de opfører sig etisk. Så spørgsmålet bliver:hvordan påvirker AI-udvikleres og -ingeniørers etik de beslutninger, AI træffer?

Den selvkørende fremtid

Forestil dig en fremtid med selvkørende biler, der er fuldt autonome. Hvis alt fungerer efter hensigten, vil morgenpendlen være en mulighed for at forberede sig til dagens møder, følge med i nyheder eller læne sig tilbage og slappe af.

Men hvad hvis det går galt? Bilen nærmer sig et lyskryds, men pludselig svigter bremserne, og computeren må tage en beslutning på et splitsekund. Den kan svinge ind i en nærliggende pæl og dræbe passageren, eller blive ved og dræbe fodgængeren foran.

Computeren, der styrer bilen, vil kun have adgang til begrænset information indsamlet gennem bilsensorer, og skal tage en beslutning ud fra dette. Hvor dramatisk dette end kan virke, er vi kun et par år væk fra potentielt at stå over for sådanne dilemmaer.

Autonome biler vil generelt give mere sikker kørsel, men ulykker vil være uundgåelige – især i en overskuelig fremtid, når disse biler vil dele vejene med menneskelige bilister og andre trafikanter.

Tesla producerer endnu ikke helt autonome biler, selvom det planlægger det. I kollisionssituationer fungerer eller deaktiverer Tesla-biler ikke automatisk det automatiske nødbremsesystem (AEB), hvis en menneskelig fører har kontrol.

Med andre ord bliver førerens handlinger ikke forstyrret – heller ikke selvom de selv forårsager sammenstødet. I stedet, hvis bilen registrerer en potentiel kollision, sender den advarsler til føreren om at handle.

I "autopilot"-tilstand skal bilen dog automatisk bremse for fodgængere. Nogle hævder, at hvis bilen kan forhindre en kollision, så er der en moralsk forpligtelse for den til at tilsidesætte førerens handlinger i alle scenarier. Men vil vi have en autonom bil til at træffe denne beslutning?

Hvad er et liv værd?

Hvad hvis en bils computer kunne vurdere den relative "værdi" af passageren i bilen og fodgængeren? Hvis dens beslutning betragtede denne værdi, ville den teknisk set blot være at lave en cost-benefit-analyse.

Dette kan lyde alarmerende, men der er allerede udviklet teknologier, der kan tillade dette at ske. For eksempel har den nyligt omdannede Meta (tidligere Facebook) en stærkt udviklet ansigtsgenkendelse, der nemt kan identificere individer i en scene.

Hvis disse data blev inkorporeret i et autonomt køretøjs AI-system, kunne algoritmen sætte en dollarværdi på hvert liv. Denne mulighed er afbildet i en omfattende undersøgelse fra 2018 udført af eksperter ved Massachusetts Institute of Technology og kolleger.

Gennem Moral Machine-eksperimentet stillede forskere forskellige selvkørende bilscenarier, der tvang deltagerne til at beslutte, om de skulle dræbe en hjemløs fodgænger eller en udøvende fodgænger.

Resultaterne viste, at deltagernes valg afhang af niveauet af økonomisk ulighed i deres land, hvor mere økonomisk ulighed betød, at de var mere tilbøjelige til at ofre den hjemløse mand.

Selvom det ikke er helt så udviklet, er sådan dataaggregering allerede i brug med Kinas sociale kreditsystem, som afgør, hvilke sociale rettigheder folk har.

Sundhedsindustrien er et andet område, hvor vi vil se AI træffe beslutninger, der kan redde eller skade mennesker. Eksperter udvikler i stigende grad kunstig intelligens for at opdage uregelmæssigheder i medicinsk billeddannelse og for at hjælpe læger med at prioritere lægebehandling.

Indtil videre har lægerne det sidste ord, men efterhånden som disse teknologier bliver mere og mere avancerede, hvad vil der så ske, når en læge og AI-algoritme ikke stiller den samme diagnose?

Et andet eksempel er et automatiseret medicinpåmindelsessystem. Hvordan skal systemet reagere, hvis en patient nægter at tage sin medicin? Og hvordan påvirker det patientens autonomi og systemets overordnede ansvarlighed?

AI-drevne droner og våben er også etisk bekymrende, da de kan træffe beslutningen om at dræbe. Der er modstridende synspunkter om, hvorvidt sådanne teknologier helt skal forbydes eller reguleres. For eksempel kan brugen af autonome droner begrænses til overvågning.

Nogle har opfordret til, at militærrobotter skal programmeres med etik. Men dette rejser spørgsmål om programmørens ansvarlighed i tilfælde, hvor en drone dræber civile ved en fejltagelse.

Filosofiske dilemmaer

Der har været mange filosofiske debatter om de etiske beslutninger, AI skal træffe. Det klassiske eksempel på dette er trolleyproblemet.

Folk kæmper ofte med at træffe beslutninger, der kan have et livsændrende resultat. Når vi evaluerer, hvordan vi reagerer på sådanne situationer, rapporterede en undersøgelse, at valg kan variere afhængigt af en række faktorer, herunder respondentens alder, køn og kultur.

Når det kommer til AI-systemer, er algoritmernes træningsprocesser afgørende for, hvordan de vil fungere i den virkelige verden. Et system udviklet i ét land kan påvirkes af det pågældende lands synspunkter, politik, etik og moral, hvilket gør det uegnet til brug på et andet sted og tidspunkt.

Hvis systemet styrede fly eller styrede et missil, ville du gerne have et højt niveau af tillid, det var trænet med data, der er repræsentative for det miljø, det bliver brugt i.

Eksempler på fejl og skævheder i teknologiimplementering har inkluderet racistisk sæbedispenser og upassende automatisk billedmærkning.

Hvis du nogensinde har haft problemer med at forstå vigtigheden af mangfoldighed inden for teknologi og dens indvirkning på samfundet, så se denne video pic.twitter. com/ZJ1Je1C4NW

— Chukwuemeka Afigbo (@nke_ise) 16. august 2017

AI er ikke "god" eller "ond". De virkninger, det har på mennesker, vil afhænge af udviklernes etik. Så for at få mest muligt ud af det, skal vi nå til enighed om, hvad vi betragter som "etisk".

Mens private virksomheder, offentlige organisationer og forskningsinstitutioner har deres egne retningslinjer for etisk AI, har FN anbefalet at udvikle, hvad de kalder "et omfattende globalt standardsættende instrument" for at levere en global etisk AI-ramme – og sikre, at menneskerettighederne er beskyttet.

Varme artikler

Varme artikler

-

Åbning af 10 nye olie- og gasanlæg er en sejr for fossile brændstoffer, men et svimlende tab for …Kredit:Jan-Rune Smenes Reite/Pexels, CC BY Føderale ressourceminister Madeleine King overrakte i går Australiens fossile brændstofindustri to betydelige sejre. Ministeren meddelte, at olie- og gas

Åbning af 10 nye olie- og gasanlæg er en sejr for fossile brændstoffer, men et svimlende tab for …Kredit:Jan-Rune Smenes Reite/Pexels, CC BY Føderale ressourceminister Madeleine King overrakte i går Australiens fossile brændstofindustri to betydelige sejre. Ministeren meddelte, at olie- og gas -

Banebrydende forskning viser, at hyperspektral billeddannelse kan karakterisere byggematerialernes s…Kredit:CC0 Public Domain Professor Debra Laefer fra NYUs Center for Urban Science and Progress (CUSP), i samarbejde med professor Aoife Gowen og Zohreh Zahiri fra University College Dublin, for ny

Banebrydende forskning viser, at hyperspektral billeddannelse kan karakterisere byggematerialernes s…Kredit:CC0 Public Domain Professor Debra Laefer fra NYUs Center for Urban Science and Progress (CUSP), i samarbejde med professor Aoife Gowen og Zohreh Zahiri fra University College Dublin, for ny -

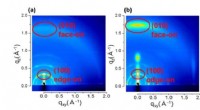

Meget effektive vådbehandlede solceller med molekyler i samme retning2-D-GIWAXS-billeder af tynde DRCN5T-film deponeret på PEDOT:PSS-substrater 327 (a) uden og (b) med et CuI-bufferlag. Kredit:Kanazawa University Forskere ved Kanazawa University rapporterer i tidss

Meget effektive vådbehandlede solceller med molekyler i samme retning2-D-GIWAXS-billeder af tynde DRCN5T-film deponeret på PEDOT:PSS-substrater 327 (a) uden og (b) med et CuI-bufferlag. Kredit:Kanazawa University Forskere ved Kanazawa University rapporterer i tidss -

Ocean Resort Casino slutter sig til New Jersey internetbettingmarkedDenne 18. juni, 2018 foto viser ydersiden af Ocean Resort Casino i Atlantic City, N.J. Søndag den 15. juli, Ocean Resorts internetgamblingwebsted blev godkendt af spillemyndighederne i New Jersey fo

Ocean Resort Casino slutter sig til New Jersey internetbettingmarkedDenne 18. juni, 2018 foto viser ydersiden af Ocean Resort Casino i Atlantic City, N.J. Søndag den 15. juli, Ocean Resorts internetgamblingwebsted blev godkendt af spillemyndighederne i New Jersey fo

- Kryptologi fra krypten:Hvordan jeg knækkede en 70 år gammel kodet besked fra hinsides graven

- Fremme af midlertidige kontrakter har ikke den ønskede effekt med at øge beskæftigelsen

- Neurovidenskabsmænd træner et dybt neuralt netværk til at behandle lyde, som mennesker gør

- Sådan fortæller du tiden med din Shadow

- Trump-administrationen trækker stikket på energieffektive pæreregler

- Hvilke tilpasninger har ulve?