Kunstig intelligens er smart, men spiller den godt sammen med andre?

Når de spillede det kooperative kortspil Hanabi, følte mennesker sig frustrerede og forvirrede over deres AI-holdkammerats bevægelser. Kredit:Bryan Mastergeorge

Når det kommer til spil som skak eller Go, har kunstig intelligens (AI) programmer langt overgået de bedste spillere i verden. Disse "overmenneskelige" AI'er er uovertrufne konkurrenter, men måske sværere end at konkurrere mod mennesker er det at samarbejde med dem. Kan den samme teknologi komme overens med mennesker?

I en ny undersøgelse søgte forskere fra MIT Lincoln Laboratory at finde ud af, hvor godt mennesker kunne spille det kooperative kortspil Hanabi med en avanceret AI-model, der er trænet til at udmærke sig til at spille med holdkammerater, den aldrig havde mødt før. I enkelt-blinde eksperimenter spillede deltagerne to serier af spillet:Den ene med AI-agenten som deres holdkammerat og den anden med en regelbaseret agent, en bot manuelt programmeret til at spille på en foruddefineret måde.

Resultaterne overraskede forskerne. Ikke alene var scoringerne ikke bedre med AI-holdkammeraten end med den regelbaserede agent, men mennesker hadede konsekvent at spille med deres AI-holdkammerat. De fandt, at det var uforudsigeligt, upålideligt og utroværdigt, og følte sig negativt, selv når holdet scorede godt. Et papir, der beskriver denne undersøgelse, er blevet accepteret til 2021-konferencen om neurale informationsbehandlingssystemer (NeurIPS).

"Det fremhæver virkelig den nuancerede skelnen mellem at skabe AI, der yder objektivt godt, og at skabe AI, der er subjektivt tillid til eller foretrukket," siger Ross Allen, medforfatter af papiret og en forsker i Artificial Intelligence Technology Group. "Det kan se ud til, at disse ting er så tæt på, at der ikke rigtig er dagslys mellem dem, men denne undersøgelse viste, at det faktisk er to separate problemer. Vi skal arbejde på at skille dem ad."

Mennesker, der hader deres AI-holdkammerater, kan være bekymrende for forskere, der designer denne teknologi til en dag at arbejde sammen med mennesker om virkelige udfordringer – som at forsvare sig mod missiler eller udføre kompleks kirurgi. Denne dynamik, kaldet teaming-intelligens, er en næste frontlinje inden for AI-forskning, og den bruger en særlig form for AI kaldet forstærkningslæring.

En forstærkningslærende AI får ikke at vide, hvilke handlinger den skal tage, men opdager i stedet, hvilke handlinger der giver den mest numeriske "belønning" ved at prøve scenarier igen og igen. Det er denne teknologi, der har givet de overmenneskelige skak- og Go-spillere. I modsætning til regelbaserede algoritmer er disse kunstige intelligenser ikke programmeret til at følge "hvis/så"-udsagn, fordi de mulige resultater af de menneskelige opgaver, de skal løse, som at køre bil, er alt for mange til at kode.

"Forstærkningslæring er en meget mere generel måde at udvikle AI på. Hvis du kan træne den til at lære at spille skak, vil den agent ikke nødvendigvis køre bil. Men du kan bruge de samme algoritmer til at træne en anden agent til at køre bil, givet de rigtige data," siger Allen. "Himlen er grænsen for, hvad den i teorien kunne gøre."

Dårlige tip, dårlige spil

I dag bruger forskere Hanabi til at teste ydeevnen af forstærkningslæringsmodeller, der er udviklet til samarbejde, stort set på samme måde som skak har fungeret som benchmark for test af konkurrerende AI i årtier.

Spillet Hanabi er beslægtet med en multiplayer-form af Solitaire. Spillere arbejder sammen om at stable kort i samme kulør i rækkefølge. Spillere må dog ikke se deres egne kort, kun de kort, som deres holdkammerater har. Hver spiller er strengt begrænset i, hvad de kan kommunikere til deres holdkammerater for at få dem til at vælge det bedste kort fra deres egen hånd til at stable det næste.

Lincoln Laboratory-forskerne udviklede hverken AI eller regelbaserede midler, der blev brugt i dette eksperiment. Begge agenter repræsenterer de bedste inden for deres felter for Hanabi-præstationer. Faktisk, da AI-modellen tidligere var parret med en AI-holdkammerat, den aldrig havde spillet med før, opnåede holdet den højeste score nogensinde for Hanabi-spil mellem to ukendte AI-agenter.

"Det var et vigtigt resultat," siger Allen. "Vi tænkte, at hvis disse AI, som aldrig har mødt hinanden før, kan komme sammen og spille rigtig godt, så burde vi være i stand til at bringe mennesker, som også ved, hvordan man spiller meget godt sammen med AI'en, og de vil også klare sig meget godt. Det er derfor, vi troede, at AI-holdet objektivt set ville spille bedre, og også derfor, vi troede, at mennesker ville foretrække det, for generelt vil vi kunne lide noget bedre, hvis vi gør det godt."

Ingen af disse forventninger gik i opfyldelse. Objektivt set var der ingen statistisk forskel i scorerne mellem AI og den regelbaserede agent. Subjektivt rapporterede alle 29 deltagere i undersøgelser en klar præference over for den regelbaserede holdkammerat. Deltagerne blev ikke informeret om, hvilken agent de spillede med til hvilke spil.

"En deltager sagde, at de var så stressede over det dårlige spil fra AI-agenten, at de faktisk fik hovedpine," siger Jaime Pena, en forsker i AI Technology and Systems Group og en forfatter på papiret. "En anden sagde, at de troede, at den regelbaserede agent var dum, men brugbar, hvorimod AI-agenten viste, at den forstod reglerne, men at dens træk ikke stemte overens med, hvordan et hold ser ud. For dem var det at give dårlige hints, laver dårlige spil."

Umenneskelig kreativitet

Denne opfattelse af AI, der laver "dårlige spil", forbinder overraskende adfærd, forskere har observeret tidligere i forstærkende læringsarbejde. For eksempel, i 2016, da DeepMinds AlphaGo første gang besejrede en af verdens bedste Go-spillere, var et af de mest roste træk foretaget af AlphaGo træk 37 i spil 2, et træk så usædvanligt, at menneskelige kommentatorer troede, det var en fejltagelse. Senere analyse afslørede, at flytningen faktisk var ekstremt velovervejet og blev beskrevet som "genial."

Sådanne træk kan blive rost, når en AI-modstander udfører dem, men de er mindre tilbøjelige til at blive fejret i et hold. Lincoln Laboratory-forskerne fandt ud af, at mærkelige eller tilsyneladende ulogiske træk var de værste lovovertrædere i at bryde menneskers tillid til deres AI-holdkammerat i disse tæt koblede teams. Sådanne bevægelser formindskede ikke kun spillernes opfattelse af, hvor godt de og deres AI-holdkammerat arbejdede sammen, men også hvor meget de overhovedet ønskede at arbejde med AI, især når en potentiel gevinst ikke umiddelbart var indlysende.

"Der var mange kommentarer om at give op, kommentarer som "Jeg hader at arbejde med denne ting," tilføjer Hosea Siu, også forfatter til papiret og forsker i Control and Autonomous Systems Engineering Group.

Deltagere, der vurderede sig selv som Hanabi-eksperter, hvilket størstedelen af spillerne i denne undersøgelse gjorde, opgav oftere AI-spilleren. Siu finder dette bekymrende for AI-udviklere, fordi nøglebrugere af denne teknologi sandsynligvis vil være domæneeksperter.

"Lad os sige, at du træner en supersmart AI-vejledningsassistent til et missilforsvarsscenarie. Du afleverer det ikke til en praktikant; du afleverer det til dine eksperter på dine skibe, som har gjort dette i 25 år Så hvis der er en stærk ekspertbias mod det i spilscenarier, vil det sandsynligvis dukke op i den virkelige verden," tilføjer han.

Squishy mennesker

Forskerne bemærker, at den AI, der blev brugt i denne undersøgelse, ikke var udviklet til menneskelig præference. Men det er en del af problemet - det er der ikke mange, der er. Som de fleste kollaborative AI-modeller er denne model designet til at score så højt som muligt, og dens succes er blevet benchmarket af dens objektive ydeevne.

Hvis forskere ikke fokuserer på spørgsmålet om subjektiv menneskelig præference, "så vil vi ikke skabe AI, som mennesker faktisk ønsker at bruge," siger Allen. "Det er nemmere at arbejde med kunstig intelligens, der forbedrer et meget rent tal. Det er meget sværere at arbejde med kunstig intelligens, der fungerer i denne mere musher verden af menneskelige præferencer."

At løse dette sværere problem er målet for MeRLin-projektet (Mission-Ready Reinforcement Learning), som dette eksperiment blev finansieret under i Lincoln Laboratorys teknologikontor i samarbejde med U.S. Air Force Artificial Intelligence Accelerator og MIT Department of Electrical Engineering and Computer Videnskab. Projektet studerer, hvad der har forhindret kollaborativ AI-teknologi i at springe ud af spilrummet og ind i mere rodet virkelighed.

Forskerne tror, at evnen for AI til at forklare sine handlinger vil skabe tillid. Dette vil være i fokus for deres arbejde det næste år.

"Du kan forestille dig, at vi gentog eksperimentet, men efter kendsgerningen - og det er meget lettere sagt end gjort - kunne mennesket spørge:'Hvorfor gjorde du det træk, jeg forstod det ikke?' If the AI could provide some insight into what they thought was going to happen based on their actions, then our hypothesis is that humans would say, 'Oh, weird way of thinking about it, but I get it now,' and they'd trust it. Our results would totally change, even though we didn't change the underlying decision-making of the AI," Allen says.

Like a huddle after a game, this kind of exchange is often what helps humans build camaraderie and cooperation as a team.

"Maybe it's also a staffing bias. Most AI teams don't have people who want to work on these squishy humans and their soft problems," Siu adds, laughing. "It's people who want to do math and optimization. And that's the basis, but that's not enough."

Mastering a game such as Hanabi between AI and humans could open up a universe of possibilities for teaming intelligence in the future. But until researchers can close the gap between how well an AI performs and how much a human likes it, the technology may well remain at machine versus human.

Varme artikler

Varme artikler

-

AI kan hjælpe droner med at køre luftstrømme som fugleSvæveflypiloter leder efter opdrift for at forblive i luften. Kredit:Shutterstock Fugle har længe inspireret mennesker til at skabe deres egne måder at flyve på. Vi ved, at skyhøje fuglearter, der

AI kan hjælpe droner med at køre luftstrømme som fugleSvæveflypiloter leder efter opdrift for at forblive i luften. Kredit:Shutterstock Fugle har længe inspireret mennesker til at skabe deres egne måder at flyve på. Vi ved, at skyhøje fuglearter, der -

Sådan bygger man en bedre vindmølleparkKredit:CC0 Public Domain Beliggenhed, beliggenhed, beliggenhed – når det kommer til placeringen af vindmøller, gælder det gamle ejendomsordsprog ifølge ny forskning offentliggjort i Proceedings o

Sådan bygger man en bedre vindmølleparkKredit:CC0 Public Domain Beliggenhed, beliggenhed, beliggenhed – når det kommer til placeringen af vindmøller, gælder det gamle ejendomsordsprog ifølge ny forskning offentliggjort i Proceedings o -

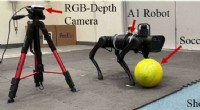

En forstærkende læringsramme til at forbedre fodboldskydningsfærdighederne hos firbenede robotterKredit:Ji et al. Forskerne University of California, Berkeley (UC Berkeley), Université de Montréal og Mila har for nylig udviklet en hierarkisk forstærkende læringsramme for at forbedre præcisione

En forstærkende læringsramme til at forbedre fodboldskydningsfærdighederne hos firbenede robotterKredit:Ji et al. Forskerne University of California, Berkeley (UC Berkeley), Université de Montréal og Mila har for nylig udviklet en hierarkisk forstærkende læringsramme for at forbedre præcisione -

Hvor smart er din by?Smart Cities er meget mere end teknologi. Det handler om at bruge teknologi bæredygtigt og på en måde, der forbedrer livet for de mennesker, der bor der. Kredit:Shutterstock Andelen af verdens b

Hvor smart er din by?Smart Cities er meget mere end teknologi. Det handler om at bruge teknologi bæredygtigt og på en måde, der forbedrer livet for de mennesker, der bor der. Kredit:Shutterstock Andelen af verdens b

- Hvordan sker der et jordskælv?

- Masseturisme sætter gang i kampen om Montmartres sjæl

- Kan data redde delfiner? Hvordan videnskabsmænd bruger NASA-data til at studere sammenhængen melle…

- Er der en sammenhæng mellem kontantløse betalinger og usundt forbrug?

- Vitale infrastrukturer i Holland sårbare over for hackere

- Hvor stærke er magneterne i en MR -maskine?