Regeringers brug af automatiserede beslutningstagningssystemer afspejler systemiske spørgsmål om uretfærdighed og ulighed

Software og teknologi kan behandle store mængder data øjeblikkeligt, hvilket gør dem yderst attraktive for offentlig brug. Kredit:Shutterstock

I 2019 sagde den tidligere FN-specialrapportør Philip Alston, at han var bekymret for, at vi "snublede zombie-agtigt ind i en digital velfærdsdystopi." Han havde forsket i, hvordan offentlige myndigheder rundt om i verden henvendte sig til automatiserede beslutningstagningssystemer (ADS) for at reducere omkostningerne, øge effektiviteten og målrette ressourcer. ADS er tekniske systemer designet til at hjælpe eller erstatte menneskelig beslutningstagning ved hjælp af algoritmer.

Alston var bekymret med god grund. Forskning viser, at ADS kan bruges på måder, der diskriminerer, forværrer ulighed, krænker rettigheder, sorterer mennesker i forskellige sociale grupper, fejlagtigt begrænser adgangen til tjenester og intensiverer overvågningen.

For eksempel er familier gået konkurs og tvunget ud i kriser efter at være blevet falsk anklaget for ydelsessvig.

Forskere har identificeret, hvordan ansigtsgenkendelsessystemer og risikovurderingsværktøjer er mere tilbøjelige til forkert at identificere personer med mørkere hudtoner og kvinder. Disse systemer har allerede ført til uretmæssige anholdelser og misinformerede domsafgørelser.

Ofte lærer folk først, at de er blevet påvirket af en ADS-applikation, når en af to ting sker:efter at tingene går galt, som det var tilfældet med A-niveau-skandalen i Det Forenede Kongerige; eller når kontroverser offentliggøres, som det var tilfældet med brug af ansigtsgenkendelsesteknologi i Canada og USA.

Automatiske problemer

Større gennemsigtighed, ansvar, ansvarlighed og offentlig involvering i udformningen og brugen af ADS er vigtigt for at beskytte folks rettigheder og privatliv. Der er tre hovedårsager til dette:

- disse systemer kan forårsage meget skade;

- de bliver introduceret hurtigere end nødvendige beskyttelser kan implementeres, og;

- der er mangel på mulighed for, at de berørte kan træffe demokratiske beslutninger om, hvorvidt de skal bruges, og i givet fald hvordan de skal bruges.

Vores seneste forskningsprojekt, Automating Public Services:Learning from Cancelled Systems , giver resultater, der har til formål at hjælpe med at forebygge skader og bidrage til meningsfuld debat og handling. Rapporten giver den første omfattende oversigt over systemer, der bliver annulleret på tværs af vestlige demokratier.

At undersøge de faktorer og begrundelser, der fører til annullering af ADS-systemer, hjælper os med bedre at forstå deres grænser. I vores rapport identificerede vi 61 annoncer, der blev annulleret i Australien, Canada, Europa, New Zealand og USA. Vi præsenterer en detaljeret redegørelse for annullerede systemer inden for områderne afsløring af bedrageri, børnevelfærd og politi. Vores resultater viser vigtigheden af omhyggelig overvejelse og bekymring for retfærdighed.

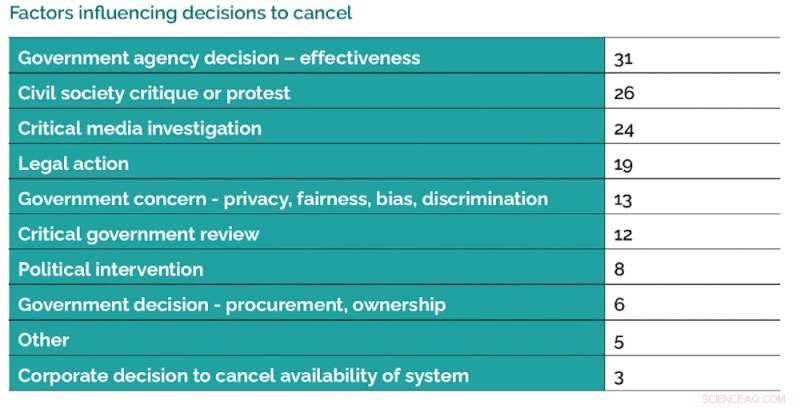

Der er en række faktorer, der påvirker beslutninger om at annullere brugen af ADS-systemer. Kredit:Data Justice Lab, forfatter leveret

Årsager til annullering

Der er en række faktorer, der påvirker beslutninger om at annullere brugen af ADS. Et af vores vigtigste resultater er, hvor ofte systemer annulleres, fordi de ikke er så effektive som forventet. Et andet nøgleresultat er den betydelige rolle, som samfundsmobilisering og forskning, efterforskningsrapportering og retslige handlinger spiller.

Vores resultater viser, at der er konkurrerende forståelser, visioner og politik omkring brugen af ADS.

Forhåbentlig vil vores anbefalinger føre til øget borgerdeltagelse og forbedret tilsyn, ansvarlighed og skadesforebyggelse.

I rapporten peger vi på udbredte opfordringer til regeringer om at etablere ressourcebaserede ADS-registre som et grundlæggende første skridt til større gennemsigtighed. Nogle lande, såsom Storbritannien, har erklæret planer om at gøre det, mens andre lande som Canada endnu ikke har bevæget sig i denne retning.

Vores resultater viser, at brugen af ADS kan føre til større ulighed og systemisk uretfærdighed. Dette forstærker behovet for at være opmærksom på, hvordan brugen af ADS kan skabe differentierede systemer med fordele og ulemper.

Ansvarlighed og gennemsigtighed

ADS skal udvikles med omhu og ansvarlighed ved at engagere sig meningsfuldt med berørte lokalsamfund. Der kan være skadelige konsekvenser, når offentlige myndigheder ikke engagerer offentligheden i diskussioner om passende brug af ADS før implementering.

Dette engagement bør omfatte muligheden for, at fællesskabsmedlemmer kan bestemme områder, hvor de ikke ønsker, at ADS skal bruges. Eksempler på god regeringspraksis kan omfatte at tage sig tid til at sikre, at der gennemføres uafhængige ekspertvurderinger og konsekvensanalyser, der fokuserer på ligestilling og menneskerettigheder.

Regeringer kan tage flere forskellige tilgange til at implementere ADS-systemer på en mere ansvarlig måde. Kredit:Data Justice Lab, forfatter leveret

Vi anbefaler at styrke ansvarligheden for dem, der ønsker at implementere ADS, ved at kræve bevis for nøjagtighed, effektivitet og sikkerhed samt vurderinger af lovlighed. Som minimum bør folk være i stand til at finde ud af, om en ADS har brugt deres data, og om nødvendigt have adgang til ressourcer til at udfordre og rette op på forkerte vurderinger.

Der er en række tilfælde anført i vores rapport, hvor offentlige myndigheders partnerskab med private virksomheder om at levere ADS-tjenester har givet problemer. I et tilfælde besluttede et statsligt organ ikke at bruge et kautionssystem, fordi systemets proprietære karakter betød, at tiltalte og embedsmænd ikke ville være i stand til at forstå, hvorfor en beslutning blev truffet, hvilket gjorde en effektiv udfordring umulig.

Offentlige myndigheder skal have ressourcer og færdigheder til grundigt at undersøge, hvordan de anskaffer ADS-systemer.

En omsorgspolitik

Alle disse anbefalinger peger på vigtigheden af en omsorgspolitik. Dette kræver, at de, der ønsker at implementere ADS, forstår kompleksiteten af mennesker, fællesskaber og deres rettigheder.

Nøglespørgsmål skal stilles om, hvordan brugen af ADS fører til blinde vinkler på grund af den måde, de øger afstanden mellem administratorer og de mennesker, det er meningen, de skal betjene gennem scorings- og sorteringssystemer, der oversimplifiserer, udleder skyld, fejlagtigt målretter og stereotyper mennesker gennem kategoriseringer og kvantificeringer.

God praksis, hvad angår en politik for omsorg, indebærer, at man tager sig tid til nøje at overveje de potentielle virkninger af ADS før implementering og at være lydhør over for kritik, sikre løbende tilsyn og gennemgang og søge uafhængig og lokal gennemgang. + Udforsk yderligere

Ansigtsgenkendelse, kameraer og andre værktøjer, politiet bruger rejser spørgsmål om ansvarlighed

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Tjenende lederskab er godt for erhvervslivet - og kvinder er bedre til detKredit:CC0 Public Domain I årtier, undersøgelser har vist, at mænd er mere tilbøjelige end kvinder til at blive opfattet som gode ledere – selv når de gør eller siger de samme ting. Men når det ko

Tjenende lederskab er godt for erhvervslivet - og kvinder er bedre til detKredit:CC0 Public Domain I årtier, undersøgelser har vist, at mænd er mere tilbøjelige end kvinder til at blive opfattet som gode ledere – selv når de gør eller siger de samme ting. Men når det ko -

Jeg sover dårligt, når jeg er død:Den søvnberøvede maskulinitetsstereotypeKredit:CC0 Public Domain I USA, den gennemsnitlige amerikaner sover mindre end de minimum syv timers søvn pr. nat anbefalet af Center for Disease Control, og næsten halvdelen af amerikanerne rap

Jeg sover dårligt, når jeg er død:Den søvnberøvede maskulinitetsstereotypeKredit:CC0 Public Domain I USA, den gennemsnitlige amerikaner sover mindre end de minimum syv timers søvn pr. nat anbefalet af Center for Disease Control, og næsten halvdelen af amerikanerne rap -

Mode til spidse sko udløste en plag af knyster i middelalderens StorbritannienUdgravede middelalderlige fodknogler, der viser hallux valgus, med lateral afvigelse af stortåen. Kredit:Jenna Dittmar Briterne har lidt for deres mode i århundreder ifølge en ny undersøgelse, der

Mode til spidse sko udløste en plag af knyster i middelalderens StorbritannienUdgravede middelalderlige fodknogler, der viser hallux valgus, med lateral afvigelse af stortåen. Kredit:Jenna Dittmar Briterne har lidt for deres mode i århundreder ifølge en ny undersøgelse, der -

En interaktiv gravitationsbølgedetektormodel designet til at undervise på museer og messerKredit:Unsplash/CC0 Public Domain Observationer af gravitationsbølger i rummet har vakt offentlig interesse for rumteknologi, og en interaktiv udstilling baseret på en virkelig gravitationsbølgede

En interaktiv gravitationsbølgedetektormodel designet til at undervise på museer og messerKredit:Unsplash/CC0 Public Domain Observationer af gravitationsbølger i rummet har vakt offentlig interesse for rumteknologi, og en interaktiv udstilling baseret på en virkelig gravitationsbølgede

- Forskere kobler magnetisering til superledning til kvanteopdagelser

- Barometrisk tryk vs. Vindhastigheden af en orkan

- Jern-svovl-klyngeforskning giver nye muligheder for at undersøge sygdom

- Rapport offentliggjort om nye forretningsmodeller, der skærer ned på engangsplastik

- EU -ledere undlader at sætte 2050 -målet om nul netto CO2 -emissioner

- Fordele og ulemper ved biomasse energi