Teknologiske ledere underskriver et globalt løfte mod autonome våben

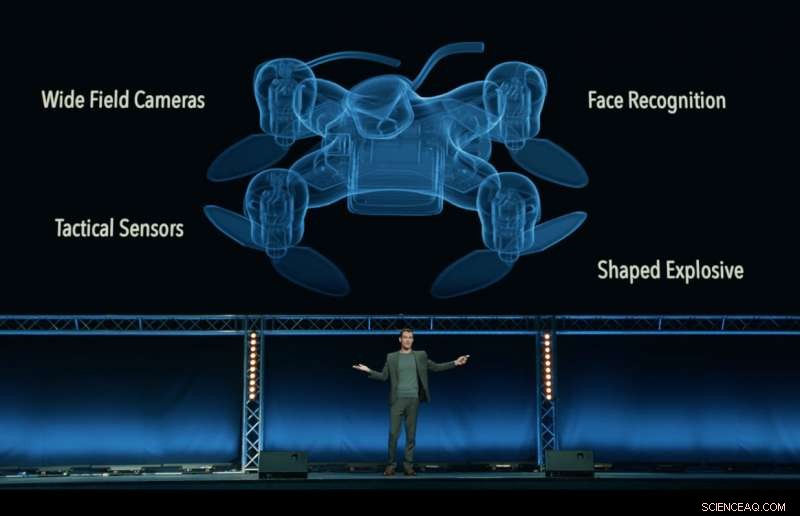

Stadig fra 'Slaughterbots'-videoen, produceret af Future of Life Institute, som viser en fiktiv dystopisk fremtid med dræberdroner, der myldrer verden over. Kredit:Future of Life Institute

En hvem er hvem af administrerende direktører, ingeniører og videnskabsmænd fra teknologiindustrien – inklusive Google DeepMind, XPRIZE Foundation og Elon Musk - har underskrevet et løfte om at "hverken deltage i eller støtte udviklingen, fremstille, handle, eller brug af dødelige autonome våben".

Udgivet i Stockholm ved 2018 International Joint Conference on Artificial Intelligence (IJCAI), verdens førende AI-forskningsmøde med over 5, 000 deltagere, løftet blev underskrevet af 150 virksomheder og mere end 2, 400 personer fra 90 lande, der arbejder med kunstig intelligens (AI) og robotteknologi.

Virksomhedens underskrivere inkluderer Google DeepMind, University College London, XPRIZE Foundation, ClearPath Robotics/OTTO Motors, European Association for AI, og Swedish AI Society. Enkeltpersoner omfatter forskningschef hos Google.ai Jeff Dean, AI-pionererne Stuart Russell, Yoshua Bengio, Anca Dragan og Toby Walsh, og det britiske Labour-parlamentsmedlem Alex Sobel.

Løftet, arrangeret af Future of Life Institute, udfordrer regeringer, akademi og industri til at følge deres spor, siger:"Vi, undertegnede, opfordrer regeringer og regeringsledere til at skabe en fremtid med stærke internationale normer, regler og love mod dødelige autonome våben. ... Vi beder om, at teknologivirksomheder og organisationer, såvel som ledere, politiske beslutningstagere, og andre individer, slutte sig til os i dette løfte."

Max Tegmark, en fysikprofessor ved Massachusetts Institute of Technology og præsident for Future of Life Institute, meddelte løftet.

"Jeg er glad for at se AI-ledere skifte fra snak til handling, at implementere en politik, som politikerne hidtil ikke har formået at gennemføre, " sagde Tegmark. "AI har et enormt potentiale til at hjælpe verden - hvis vi stigmatiserer og forhindrer misbrug af det. AI-våben, der selvstændigt beslutter at dræbe mennesker, er lige så modbydelige og destabiliserende som biovåben, og bør behandles på samme måde."

Dødelige autonome våbensystemer (LAWS) - også kaldet 'dræberrobotter' - er våben, der kan identificere, mål, og dræbe en person, uden et menneskeligt 'in-the-loop'. Det er, ingen person træffer den endelige beslutning om at tillade dødelig magt:Beslutningen og autorisation om, hvorvidt nogen skal dø eller ej, overlades til det autonome våbensystem. Dette inkluderer ikke nutidens droner, som er under menneskelig kontrol; heller ikke autonome systemer, der blot forsvarer sig mod andre våben.

Løftet begynder med udtalelsen:"Kunstig intelligens er klar til at spille en stigende rolle i militære systemer. Der er en presserende mulighed og nødvendighed for borgerne, politiske beslutningstagere, og ledere til at skelne mellem acceptabel og uacceptabel brug af kunstig intelligens."

En anden nøglearrangør af løftet, Toby Walsh, en professor i kunstig intelligens ved Australiens University of New South Wales i Sydney, påpeger de vanskelige etiske spørgsmål omkring LOVE:"Vi kan ikke overlade beslutningen om, hvem der lever, og hvem der dør til maskiner. De har ikke etikken til at gøre det. Jeg opfordrer dig og dine organisationer til at forpligte sig til at sikre, at krig ikke sker. blive mere forfærdelige på denne måde."

Ryan Gariepy, Grundlægger og CTO af både Clearpath Robotics og OTTO Motors, en stærk modstander af dødelige autonome våben, gentog opfordringen:"Clearpath tror fortsat på, at spredningen af dødelige autonome våbensystemer forbliver en klar og nuværende fare for borgerne i alle lande i verden. Ingen nation vil være sikker, uanset hvor kraftig.

"Clearpaths bekymringer deles af en lang række andre centrale virksomheder og udviklere af autonome systemer, og vi håber, at regeringer over hele verden beslutter at investere deres tid og kræfter i autonome systemer, som gør deres befolkninger sundere, sikrere, og mere produktive i stedet for systemer, hvis eneste anvendelse er indsættelse af dødelig magt, " han tilføjede.

Toby Walsh, professor i kunstig intelligens ved Australiens University of New South Wales i Sydney, med en Baxter-robot. Kredit:Grant Turner/UNSW

Ud over de bekymrende etiske spørgsmål omkring dødelige autonome våben, mange fortalere for et internationalt forbud mod LOVGIVNING er bekymrede for, at de vil være svære at kontrollere - nemmere at hacke, mere tilbøjelige til at ende på det sorte marked, og lettere for terrorister og despoter at få fat i – hvilket kan blive destabiliserende for alle lande. Et sådant scenarie udspilles i den FLI-udgivne video Slaughterbots.

I december 2016 FN's Revisionskonference for Konventionen om Konventionelle Våben (CCW) indledte en formel diskussion om LOVE. 26 lande, der deltager i konferencen, har indtil videre annonceret støtte til en form for forbud, inklusive Kina.

Et sådant forbud er ikke uden fortilfælde:biologiske våben og kemiske våben blev også forbudt, ikke kun af etiske og humanitære årsager, men også for den destabiliserende trussel, de udgjorde.

Det næste FN-møde om LOV vil blive afholdt i august 2018, og underskriverne af løftet håber, at deres løfte vil opmuntre lovgivere til at udvikle en forpligtelse til en international aftale mellem lande.

Som det hedder i løftet:"Vi, undertegnede, opfordrer regeringer og regeringsledere til at skabe en fremtid med stærke internationale normer, regler og love mod dødelige autonome våben. ... Vi beder om, at teknologivirksomheder og organisationer, såvel som ledere, politiske beslutningstagere, og andre individer, slutte sig til os i dette løfte."

Den fulde tekst af løftet

Kunstig intelligens (AI) er klar til at spille en stigende rolle i militære systemer. Der er en presserende mulighed og nødvendighed for borgerne, politiske beslutningstagere, og ledere til at skelne mellem acceptabel og uacceptabel brug af kunstig intelligens.

I dette lys, vi undertegnede er enige om, at beslutningen om at tage et menneskeliv aldrig bør delegeres til en maskine. Der er en moralsk komponent i denne position, at vi ikke skal tillade maskiner at træffe livsbekræftende beslutninger, som andre – eller ingen – vil være skyld i.

Der er også et stærkt pragmatisk argument:dødelige autonome våben, at udvælge og engagere mål uden menneskelig indgriben, ville være farligt destabiliserende for hvert land og individ. Tusindvis af AI-forskere er enige om, at ved at fjerne risikoen, henførbarhed, og vanskeligheder med at tage menneskeliv, dødelige autonome våben kan blive magtfulde instrumenter til vold og undertrykkelse, især når det er knyttet til overvågnings- og datasystemer.

I øvrigt, dødelige autonome våben har karakteristika, der er helt anderledes end nukleare, kemiske og biologiske våben, og en enkelt gruppes ensidige handlinger kan alt for let udløse et våbenkapløb, som det internationale samfund mangler de tekniske værktøjer og globale styringssystemer til at styre. Stigmatisering og forebyggelse af et sådant våbenkapløb bør være en høj prioritet for national og global sikkerhed.

Vi, undertegnede, opfordrer regeringer og regeringsledere til at skabe en fremtid med stærke internationale normer, regler og love mod dødelige autonome våben. Disse mangler i øjeblikket, vi vælger at holde os til en høj standard:vi vil hverken deltage i eller støtte udviklingen, fremstille, handle, eller brug af dødelige autonome våben. Vi beder om, at teknologivirksomheder og organisationer, såvel som ledere, politiske beslutningstagere, og andre individer, slutte sig til os i dette løfte.

Varme artikler

Varme artikler

-

Røde Kors lærer Fortnite-spillere at spare, ikke tage, livEn ny Fortnite-spiltilstand, kaldet Liferun, blev udviklet i samarbejde med Den Internationale Røde Kors Komité for at lære spillerne de fire hovedaktiviteter, som Røde Kors-arbejdere udfører At l

Røde Kors lærer Fortnite-spillere at spare, ikke tage, livEn ny Fortnite-spiltilstand, kaldet Liferun, blev udviklet i samarbejde med Den Internationale Røde Kors Komité for at lære spillerne de fire hovedaktiviteter, som Røde Kors-arbejdere udfører At l -

Ford tilbagekalder 2 mio. Pickupper med brandrisikoFord F-150er var blandt pickup-lastbiler, der blev genstand for en ny tilbagekaldelse for at løse et sikkerhedssele-problem, der kunne forårsage brand Ford tilbagekalder to millioner pick -up truc

Ford tilbagekalder 2 mio. Pickupper med brandrisikoFord F-150er var blandt pickup-lastbiler, der blev genstand for en ny tilbagekaldelse for at løse et sikkerhedssele-problem, der kunne forårsage brand Ford tilbagekalder to millioner pick -up truc -

Router-phishing-svindel retter sig mod global frygt for coronavirusKredit:bitdefender Der er ingen tragedie, der er alvorlig nok, som kryber et sted rundt om i verden ikke vil drage fordel af. Cybersikkerhedsorganisationen Bitdefender rapporterede i denne uge, at

Router-phishing-svindel retter sig mod global frygt for coronavirusKredit:bitdefender Der er ingen tragedie, der er alvorlig nok, som kryber et sted rundt om i verden ikke vil drage fordel af. Cybersikkerhedsorganisationen Bitdefender rapporterede i denne uge, at -

Ansigtsgenkendelse gør subtile fremskridt i StorbritannienKritikere har advaret om, at ansigtsgenkendelsesteknologi risikerer at underminere menneskerettighederne Eksperimentet blev udført diskret. Mellem 2016 og 2018, to overvågningskameraer blev instal

Ansigtsgenkendelse gør subtile fremskridt i StorbritannienKritikere har advaret om, at ansigtsgenkendelsesteknologi risikerer at underminere menneskerettighederne Eksperimentet blev udført diskret. Mellem 2016 og 2018, to overvågningskameraer blev instal

- For nanomedicin, cellekøn betyder noget

- Nye nanorørfibre har en uovertruffen kombination af styrke, ledningsevne, fleksibilitet (m/ video)

- Den mystiske stjerne MWC349

- Tåregas bør forbydes, forskere finder; her er hvorfor

- Forskere afslører historien om de ældste stjerner og galakser, kompileret ud fra 20 års simulerin…

- At slå coronavirus kræver trosledere til at bygge bro mellem religion og videnskab