Team bryder exaop-barrieren med deep learning-applikation

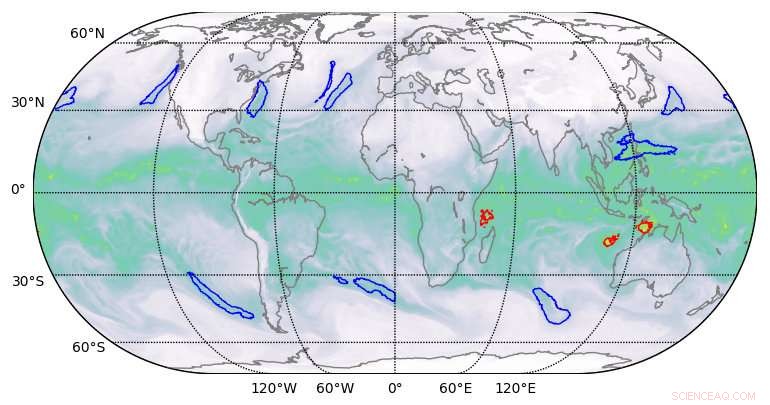

Segmenteringsresultater af høj kvalitet produceret af deep learning på klimadatasæt. Kredit:Berkeley Lab

Et team af beregningsforskere fra Lawrence Berkeley National Laboratory (Berkeley Lab) og Oak Ridge National Laboratory (ORNL) og ingeniører fra NVIDIA har, for første gang, demonstreret en deep learning-applikation i exascale-klassen, der har brudt exaop-barrieren.

Ved at bruge et klimadatasæt fra Berkeley Lab på ORNL's Summit-system på Oak Ridge Leadership Computing Facility (OLCF), de trænede et dybt neuralt netværk til at identificere ekstreme vejrmønstre fra klimasimuleringer i høj opløsning. Summit er en IBM Power Systems AC922 supercomputer drevet af mere end 9, 000 IBM POWER9 CPU'er og 27, 000 NVIDIA Tesla V100 Tensor Core GPU'er. Ved at udnytte de specialiserede NVIDIA Tensor Cores indbygget i GPU'erne i stor skala, forskerne opnåede en toppræstation på 1,13 exaops og en vedvarende præstation på 0,999 - den hurtigste deep learning-algoritme, der er rapporteret til dato, og en præstation, der gav dem en plads på dette års liste over finalister til Gordon Bell-prisen.

"Dette samarbejde har givet en række unikke resultater, " sagde Prabhat, der leder Data &Analytics Services-teamet på Berkeley Labs National Energy Research Scientific Computing Center og er medforfatter på Gordon Bell-indsendelsen. "Det er det første eksempel på deep learning-arkitektur, der har været i stand til at løse segmenteringsproblemer i klimavidenskab, og inden for deep learning, det er det første eksempel på en rigtig applikation, der har brudt exascale-barrieren."

Disse resultater blev muliggjort gennem en innovativ blanding af hardware- og softwarefunktioner. På hardwaresiden, Summit er designet til at levere 200 petaflops med høj præcision computerydelse og blev for nylig kåret som den hurtigste computer i verden, i stand til at udføre mere end tre exaops (3 milliarder milliarder beregninger) i sekundet. Systemet har en hybrid arkitektur; hver af sine 4, 608 compute nodes indeholder to IBM POWER9 CPU'er og seks NVIDIA Volta Tensor Core GPU'er, alle forbundet via NVIDIA NVLink højhastighedsforbindelsen. NVIDIA GPU'erne er en nøglefaktor i Summits ydeevne, muliggør op til 12 gange højere peak teraflops til træning og 6 gange højere peak teraflops til konklusioner i deep learning-applikationer sammenlignet med sin forgænger, Tesla P100.

"Vores samarbejde med Berkeley Lab og Oak Ridge National Laboratory viste det sande potentiale i NVIDIA Tensor Core GPU'er til AI- og HPC-applikationer, " sagde Michael Houston, senior distinguished engineer of deep learning hos NVIDIA. "For at gøre exascale til virkelighed, vores team udnyttede multipræcisionskapaciteterne pakket ind i de tusindvis af NVIDIA Volta Tensor Core GPU'er på Summit for at opnå toppræstation i træning og konklusioner i deep learning-applikationer."

Forbedret skalerbarhed og kommunikation

På softwaresiden, udover at levere klimadatasættet, Berkeley Lab-teamet udviklede mønstergenkendelsesalgoritmer til træning af DeepLabv3+ neurale netværk til at udtrække klassifikationer på pixelniveau af ekstreme vejrmønstre, som kunne hjælpe med forudsigelsen af, hvordan ekstreme vejrbegivenheder ændrer sig, når klimaet opvarmes. Ifølge Thorsten Kurth, en applikationsydelsesspecialist hos NERSC, der ledede dette projekt, holdet lavede ændringer til DeepLabv3+, der forbedrede netværkets skalerbarhed og kommunikationsmuligheder og gjorde exaops-opnåelsen mulig. Dette omfattede tweaking af netværket for at træne det til at udtrække funktioner på pixelniveau og per-pixel klassificering og forbedre node-til-node kommunikation.

"Det, der er imponerende ved denne indsats, er, at vi kunne skalere en højproduktiv ramme som TensorFlow, som er teknisk designet til hurtig prototyping på små til mellemstore skalaer, til 4, 560 noder på Summit, " sagde han. "Med en række præstationsforbedringer, vi var i stand til at få rammerne til at køre på næsten hele supercomputeren og opnå ydeevne på exaop-niveau, som mig bekendt er det hidtil bedst opnåede i en tæt koblet ansøgning."

Andre innovationer omfattede højhastigheds parallel datainddeling, en optimeret dataindtagelsespipeline og multi-kanal segmentering. Traditionelle billedsegmenteringsopgaver fungerer på tre-kanals rød/blå/grønne billeder. Men videnskabelige datasæt omfatter ofte mange kanaler; i klimaet, for eksempel, disse kan omfatte temperatur, vindhastigheder, trykværdier og luftfugtighed. Ved at køre det optimerede neurale netværk på Summit, de yderligere beregningsmuligheder tillod brugen af alle 16 tilgængelige kanaler, hvilket dramatisk forbedrede modellernes nøjagtighed.

"Vi har vist, at vi kan anvende deep-learning-metoder til segmentering på pixelniveau på klimadata, og potentielt på andre videnskabelige domæner, " sagde Prabhat. "Mere generelt, vores projekt har lagt grunden til exascale deep learning for naturvidenskab, såvel som kommercielle applikationer."

Sidste artikelNye Pentagon-våbensystemer, der nemt hackes:rapport

Næste artikelRetten beordrer dieselforbud på større Berlin-veje

Varme artikler

Varme artikler

-

Kinesisk teknologifirma sælger homoseksuelle dating-app Grindr for 608 millioner dollarsGrindr regner sig selv som verdens største sociale netværksrum for LGBT-personer Et af Kinas største mobilspilselskaber sælger den populære homoseksuelle dating-app Grindr for 608 millioner dollar

Kinesisk teknologifirma sælger homoseksuelle dating-app Grindr for 608 millioner dollarsGrindr regner sig selv som verdens største sociale netværksrum for LGBT-personer Et af Kinas største mobilspilselskaber sælger den populære homoseksuelle dating-app Grindr for 608 millioner dollar -

Kina manipulerer ikke valuta, men mangler gennemsigtighed, siger USUSAs finansminister Steven Mnuchin har afholdt sig fra at eskalere en kamp om Kinas valuta Washington afviste onsdag igen at kalde Kina for en valutamanipulator, men sagde, at yuanens fald og Beij

Kina manipulerer ikke valuta, men mangler gennemsigtighed, siger USUSAs finansminister Steven Mnuchin har afholdt sig fra at eskalere en kamp om Kinas valuta Washington afviste onsdag igen at kalde Kina for en valutamanipulator, men sagde, at yuanens fald og Beij -

Ny algoritme finder effektivt antibiotikakandidaterKredit:CC0 Public Domain Hvis du leder efter en nål i en høstak, det er bedst at vide, hvordan hø ser ud. Et internationalt team af forskere har anvendt denne idé til at søge efter nye lægemidler,

Ny algoritme finder effektivt antibiotikakandidaterKredit:CC0 Public Domain Hvis du leder efter en nål i en høstak, det er bedst at vide, hvordan hø ser ud. Et internationalt team af forskere har anvendt denne idé til at søge efter nye lægemidler, -

Senatpanelet åbner høring om udformning af amerikansk lov om fortrolighedI denne 5. september, 2018, fil foto, Senator John Thune, R-S.D., taler med journalister efter republikanernes politiske frokost på Capitol Hill i Washington. Trump -administrationen håber, at kongres

Senatpanelet åbner høring om udformning af amerikansk lov om fortrolighedI denne 5. september, 2018, fil foto, Senator John Thune, R-S.D., taler med journalister efter republikanernes politiske frokost på Capitol Hill i Washington. Trump -administrationen håber, at kongres

- Forskning knytter vedholdenhed af hvid flyvning til race, ikke socioøkonomiske faktorer

- Ny bog undersøger kritisk anti-bias-meddelelser i børneunderholdning

- Kobberkatalyseret enantioselektiv trifluormethylering af benzylradikaler udviklet

- Computersimulering af kogende fænomener, bobledannelse og to-faset boblende flow inde i atomreaktor…

- Tweaking-værktøjer til at spore tweets over tid

- Natriumnitrat og saltsyre