En ny udviklingsforstærkende læringstilgang til sansemotorisk rumudvidelse

Kredit:Zimmer, Boniface, og Dutech.

Forskere ved University of Lorraine har for nylig udtænkt en ny type overførselslæring baseret på modelfri dyb forstærkningslæring med kontinuerlig sansemotorisk rumudvidelse. Deres tilgang, præsenteret i et papir offentliggjort under den ottende fælles IEEE internationale konference om udvikling og læring og om epigenetisk robotik, og frit tilgængelig på HAL archives-ouvertes, er inspireret af børns udvikling, især ved væksten af det sansemotoriske rum, der opstår, mens et barn tilegner sig nyttige nye strategier.

"Den formelle ramme for forstærkende læring kan bruges til at modellere en bred vifte af problemer, " sagde Matthieu Zimmer, en af de forskere, der har udført undersøgelsen. "I denne ramme, en agent bruger en trial-and-error-metode til langsomt at lære, hvilken rækkefølge af handlinger der er mest passende for at nå et ønsket mål. Hvis nogle krav er opfyldt, så fortæller teorien os, at vi har algoritmer, som agenten kan bruge til at finde den optimale løsning på problemet, men det kan tage lange perioder. For at fremskynde denne proces, vi undersøgte måder, hvorpå en agent kan opnå gode resultater i færre forsøg, selv når den næsten ikke har kendskab til den opgave, den skal løse."

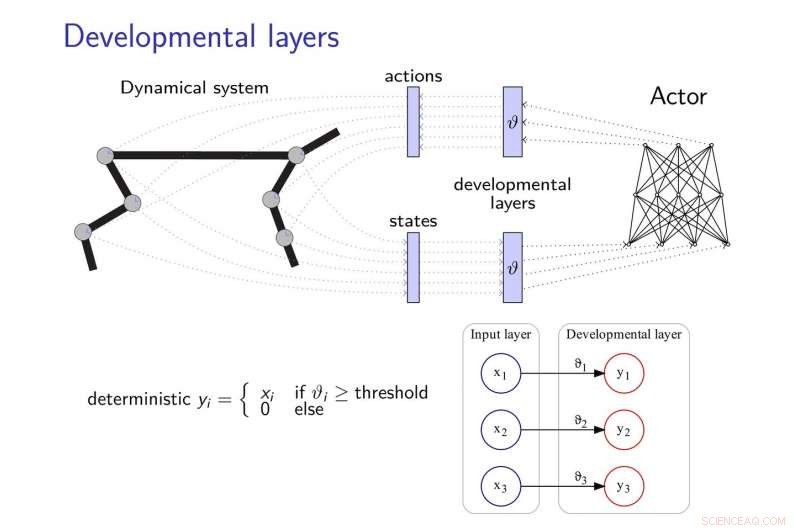

Overførselslæringsmetoden foreslået af Zimmer og hans kolleger tilføjer udviklingslag til neurale netværk, giver dem mulighed for at udvikle nye strategier til at fuldføre opgaver, især når disse opgaver på en eller anden måde er relaterede. Disse udviklingslag afdækker gradvist nogle dimensioner af det sansemotoriske rum, efter en indre motivationsheuristik.

For at afbøde virkningerne af "katastrofal glemsel, "et almindeligt problem i udviklingen af neurale netværk, forskerne tog inspiration fra teorien om elastisk vægtkonsolidering, bruge det til at regulere indlæringen af den neurale controller.

Kredit:Zimmer, Boniface, og Dutech.

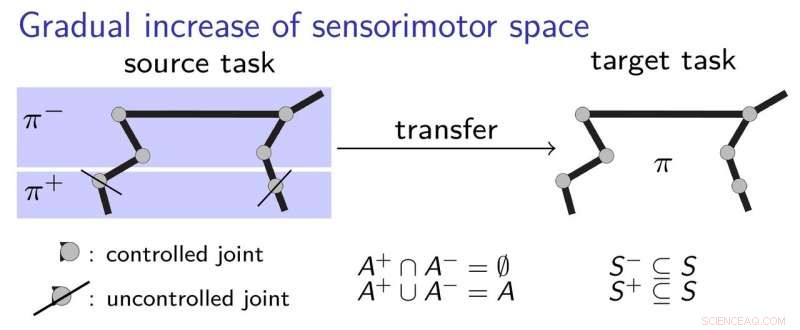

"Den grundlæggende idé med vores arbejde er, at agenten starter med meget begrænsede opfattelses- og handlingsevner og derefter udvikler disse på en udviklingsmæssig måde, inspireret af, hvordan et barn lærer, " sagde Alain Dutech, en anden forsker, der har udført undersøgelsen. "Det rum, hvor agenten søger efter en løsning, er således reduceret, og denne løsning, omend til et forringet problem, kan findes lettere. Så øger vi agentens muligheder, drage fordel af den tidligere fundet løsning."

For bedre at forklare, hvordan deres transferlæringstilgang fungerer, forskerne bruger eksemplet med et barn, der lærer at gribe en kuglepen. I første omgang, barnet må kun bruge sin albue og skulder, lære at røre ved pennen. Efterfølgende, hun beslutter sig måske for at begynde at bruge hånden og fingrene, efter at have forstået det grundlæggende i, hvordan man bedst får den første kontakt med pennen. Dette indebærer en gradvis læringsproces, hvor barnet tilegner sig sansemotoriske strategier trin for trin, uden at skulle lære for mange ting på én gang.

Forskerne validerede deres nye tilgang ved hjælp af to state-of-the-art deep learning algoritmer, nemlig DDPG og NFAC, testet på Half-Cheetah og Humanoid, to højdimensionelle miljøbenchmarks. Deres resultater tyder på, at søgning efter en suboptimal løsning i en delmængde af parameterrummet, før man overvejer den fulde plads, er en nyttig teknik til at bootstrap indlæringsalgoritmer, opnå bedre præstationer med kortere træning.

"I det meget aktive og stimulerende område med dyb-forstærkende læring, vi har vist, at udviklingsmetoder som vores, såvel som andre lignende udforskede af andre forskere, kunne kombineres med dyb læringsmetoder for at tillade læring fra bunden, med ringe forhåndsviden, " sagde Zimmer.

På trods af dets lovende resultater, undersøgelsen udført af Zimmer og hans kolleger fremhævede også den kløft, der stadig eksisterer mellem evnerne hos dybe neurale netværk og mennesker. Faktisk, selv når du bruger udviklingsforstærkende læring, de fleste eksisterende midler er stadig langt mindre alsidige og effektive end mennesker.

"Sommetider, mennesker kan lære i kun én prøve, men selv den mest effektive kunstige læring vil kræve en kompleks kombination af forskellige algoritmer for at lære, skøn, lære udenad, sammenligne, og optimere, " sagde Zimmer. "Desuden, nogle af disse algoritmer er stadig ikke klart definerede."

Dutech og hans kolleger udforsker nu nye horisonter inden for AI og deep learning. For eksempel, de vil gerne udvikle nye måder for en lærende agent til korrekt at kategorisere de stimuli, den opfatter.

"Læring er meget mere effektiv, når agenten kan fortolke, hvad der er 'ser' eller 'føler', Dutech forklarede. "I dag, tendensen er at bruge dyb læring og neurale netværk til at gøre dette. Vi udforsker nu andre metoder til at udvinde relevant og nyttig information fra den rå opfattelse af kunstige midler, som er mindre afhængige af at have et enormt korpus af eksempler; såsom uovervåget læring og selvorganisering."

© 2018 Tech Xplore

Varme artikler

Varme artikler

-

Et lovende skridt til at vende tilbage bipedal mobilitetNy forskningsindsats har til formål at hjælpe folk til at gå igen ved at kombinere eksoskeletoner med spinal stimulation. Kredit:California Institute of Technology Ingeniører hos Caltech har lance

Et lovende skridt til at vende tilbage bipedal mobilitetNy forskningsindsats har til formål at hjælpe folk til at gå igen ved at kombinere eksoskeletoner med spinal stimulation. Kredit:California Institute of Technology Ingeniører hos Caltech har lance -

Strøm sultede Nigeria på randen, efter at seks fabrikker lukkedeSeks varmekraftværker kan i øjeblikket ikke producere elektricitet og er derfor blevet lukket ned, sagde transmissionsselskabet i Nigeria Nigerianske embedsmænd arbejdede mandag på at forhindre ko

Strøm sultede Nigeria på randen, efter at seks fabrikker lukkedeSeks varmekraftværker kan i øjeblikket ikke producere elektricitet og er derfor blevet lukket ned, sagde transmissionsselskabet i Nigeria Nigerianske embedsmænd arbejdede mandag på at forhindre ko -

Maskinelæring, og hvordan det hjælper forskere med at gøre videnskabelige opdagelser meget hurtig…Forskerne Arthur Mar (til venstre) og Jillian Buriak med prøver af udskrivbare solceller. Brug af maskinlæring, Mars forskerhold var i stand til at øge effektiviteten af Buriaks solcelleteknologi me

Maskinelæring, og hvordan det hjælper forskere med at gøre videnskabelige opdagelser meget hurtig…Forskerne Arthur Mar (til venstre) og Jillian Buriak med prøver af udskrivbare solceller. Brug af maskinlæring, Mars forskerhold var i stand til at øge effektiviteten af Buriaks solcelleteknologi me -

Austrias Post Office under beskydning over datadelingDen østrigske post solgte navnene, adresser, alder og køn på omkring tre millioner kunder til målrettede marketingformål, ifølge undersøgelsesjournalistikwebstedet Addendum Østrigs nationale postk

Austrias Post Office under beskydning over datadelingDen østrigske post solgte navnene, adresser, alder og køn på omkring tre millioner kunder til målrettede marketingformål, ifølge undersøgelsesjournalistikwebstedet Addendum Østrigs nationale postk

- Antallet af børnefattigdom kan halveres i det næste årti efter forslag i en ny ekspertrapport

- Vulkan i det sydlige Japan går i udbrud; ingen skader eller skader

- At præsentere fakta som konsensus bygger bro mellem konservativ-liberal kløft over klimaændringer

- Undersøgelse viser, hvordan virksomheder påvirker politik gennem nonprofit-donationer

- Identifikation af fælles grundlag for bæredygtigt landbrug i Europa

- Simuleringer karakteriserer turbulens forårsaget af fælles forbindelse til dialyse