En tilgang til at forbedre forklaringer på maskinlæring

Det originale inputbillede. Kredit:Lee et al.

Forskere hos IBM Research UK, U.S.Military Academy og Cardiff University har for nylig foreslået en ny tilgang til at forbedre følsomheden af LIME (Local Interpretable Model Agnostic Explanations), en teknik til at opnå en bedre forståelse af de konklusioner, der er nået med maskinlæringsalgoritmer. Deres papir, udgivet på SPIE digitale bibliotek, kunne informere udviklingen af kunstig intelligens (AI) værktøjer, der giver udtømmende forklaringer på, hvordan de nåede et bestemt resultat eller konklusion.

"Vi tror på, at AI og maskinlæring kan understøtte og forstærke menneskelig beslutningstagning, men at der også er en nødvendighed for forklarelig AI, "Eunjin Lee, medforfatter af det originale forskningspapir og Emerging Technology Specialist og Senior Inventor hos IBM Research U.K., fortalte TechXplore. "I dag, beslutninger truffet af mange maskinlæringssystemer er uforklarlige, dvs. der er ingen måde for os mennesker at vide, hvordan systemerne kom til disse beslutninger. Vores forskning adresserer dette problem ved at undersøge, hvordan man kan forbedre forklaringsteknikker, der har til formål at belyse maskinlæringsprocessers 'black-box' karakter. "

LIME er en særlig populær forklaringsteknik, der kan anvendes på mange maskinlæringsmodeller. På trods af sin alsidighed, det ses ofte som upålideligt og dermed ineffektivt med at give forklaringer, også på grund af variationen i de resultater, den producerer. I stedet for at udvikle en helt ny forklaringsteknik, Lee og hendes kolleger satte sig for at identificere mekanismer, der kunne forbedre LIME -forklaringer.

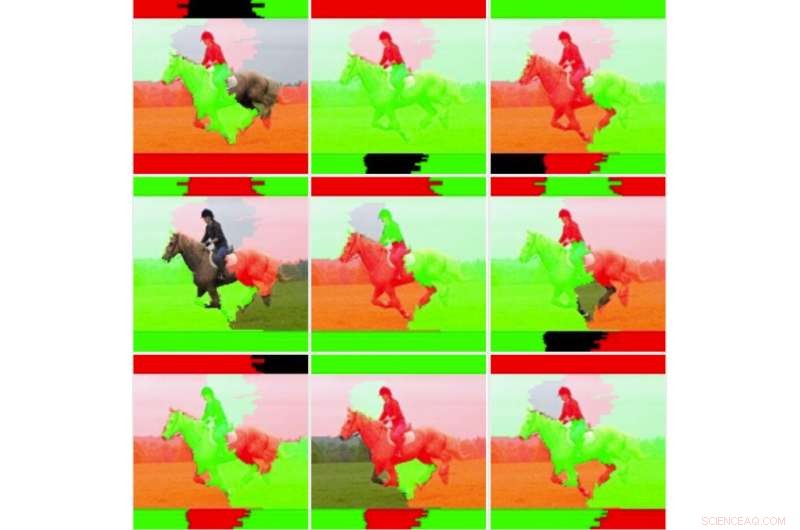

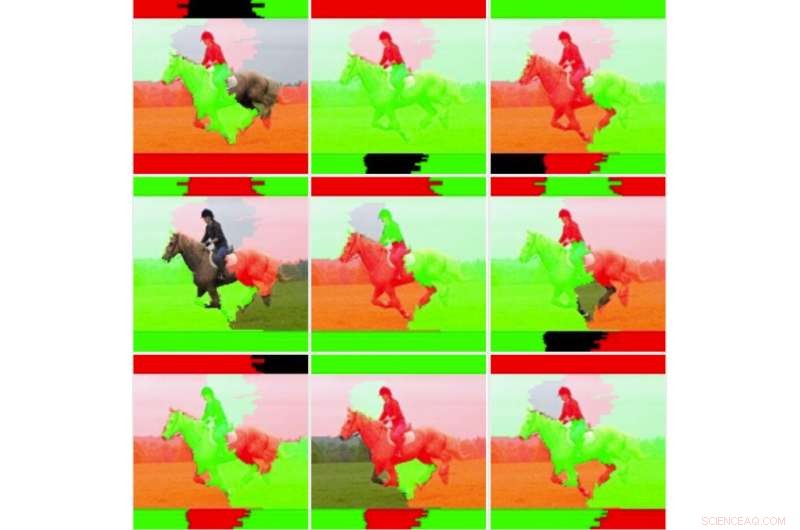

"Vi ville først se dybere ind på den ustabilitet, som andre forskere har observeret for at afgøre, om LIME virkelig var ustabil, "Forklarede Lee." For at gøre dette, vi testede LIME mod vores datasæt og maskinindlæringsmodel uden at ændre den underliggende kode. Vi fandt straks, at de resulterende forklaringsbilleder varierede betydeligt og ikke virkede konsekvente. Dette er måske det punkt, hvor mange simpelthen ville stoppe med at bruge teknikken. "

Ni billedoutput til den umodificerede LIME -teknik. Kredit:Lee et al.

Da Lee og hendes kolleger gravede dybere ned i LIMEs underliggende statistik, de opdagede, at selvom de billeder, det genererede, syntes at være "visuelt ustabile, "standardforklaringen tog ikke alle statistiske oplysninger i betragtning. F.eks. farvningen af forklaringsbilleder var for enkel og overvejede ikke de fulde underliggende data (f.eks. ikke tog højde for teknikker som skygge eller gennemsigtighed). Dette fund forklarer delvis, hvorfor forklaringer genereret af LIME undertiden ikke formidler sikkerhed for klassificering til menneskelige brugere.

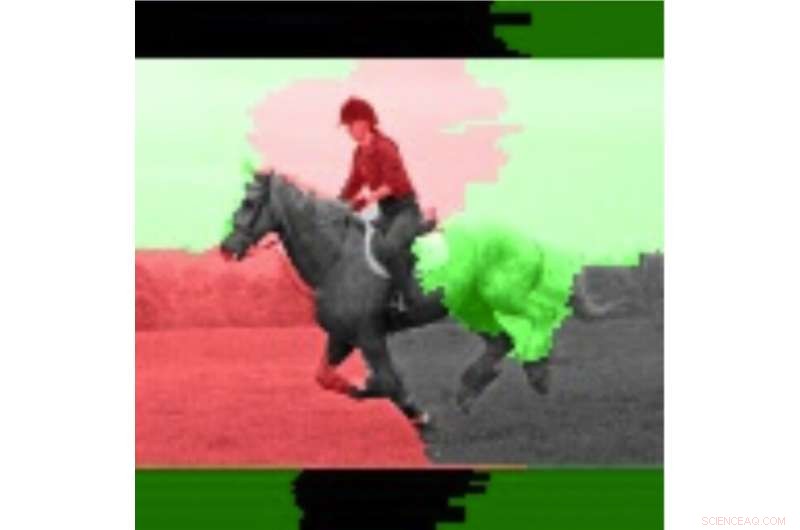

"Det er ofte tilfældet for dynamiske systemer, som dem vi undersøgte i denne undersøgelse, at det kan være gavnligt at køre adskillige tests og undersøge gennemsnitsværdier, "Sagde Lee." Ved at følge denne tilgang, vi indså, at forklaringernes stabilitet blev forbedret, når man overvejede gennemsnitlige værdier og standardafvigelser over flere kørsler i stedet for bare at køre forklaringen en gang. "

I deres undersøgelse, Lee og hendes kolleger uddannede en konvolutionsnervalt neuralt netværk (CNN) ved hjælp af to klasser af billeder, nemlig "gun-wielder" og "non-wielder." De fandt ud af, at LIMEs følsomhed blev forbedret, når flere outputvægte for individuelle billeder blev gennemsnittet og visualiseret.

Forskerne sammenlignede derefter disse gennemsnitlige billeder med individuelle billeder for at evaluere variationen og pålideligheden af de to LIME -metoder (dvs. den traditionelle metode og den, de foreslog). De fandt ud af, at traditionelle LIME -teknikker, uden de justeringer, de foretog, syntes at være ustabil på grund af den enkle binære farvning, de vedtog, og den lethed, hvormed farvede områder vendte, når man sammenlignede forskellige analyser. Lee og hendes kolleger observerede også, at de betydeligt vægtede områder af billeder var konsistente, mens de lavere vægtede regioner vendte stater, på grund af den iboende ustabilitet ved LIME -teknikker.

Billedet fremhævet ved hjælp af gennemsnitsoplysningerne. Kredit:Lee et al.

"Teknikker som LIME viser et stort løfte om AI -forklarbarhed, især på et tidspunkt, hvor der ikke er let, let tilgængelige forklaringsmuligheder for maskinlæringssystemer, "Sagde Lee." Selvom den opfattede ustabilitet er berettiget, der er teknikker, der kan hjælpe med at afhjælpe dette problem. Disse teknikker har yderligere beregningsomkostninger, f.eks. kører forklaringen flere gange, hvilket betyder, at brugeren vil have en større forsinkelse i at generere forklaringen. "

Undersøgelsen Lee og hendes kolleger har udført giver en værdifuld forklaring på nogle af faktorerne bag LIME ustabilitet, som observeret i tidligere undersøgelser. Deres resultater tyder på, at forbedring af vægtningsmetoder til forklaringsteknikker kan forbedre deres stabilitet og føre til mere pålidelige forklaringer, i sidste ende fremme større tillid til AI. Fremtidig forskning kan identificere mere avancerede numeriske teknikker til yderligere at forbedre stabiliteten af LIME og andre forklaringsmetoder, samtidig med at den yderligere omkostning reduceres.

"Vi har en løbende interesse i ansvarlige AI -systemer, der indeholder forklaringer, men også reducerer bias og øger robusthed og gennemsigtighed, "Sagde Lee." At forbedre udviklernes evne til lettere at integrere forklaringsteknikker i deres AI -løsninger er et centralt mål for os. For nylig, IBM lancerede en softwaretjeneste, der automatisk registrerer bias og forklarer, hvordan AI træffer beslutninger. "

© 2019 Science X Network

Varme artikler

Varme artikler

-

For helvede, R2! Hvornår giver vi robotter skylden?Kredit:iwouldificould. Delt under en Creative Commons-licens. En nylig undersøgelse fra North Carolina State University viser, at folk sandsynligvis vil give robotter skylden for arbejdsulykker, m

For helvede, R2! Hvornår giver vi robotter skylden?Kredit:iwouldificould. Delt under en Creative Commons-licens. En nylig undersøgelse fra North Carolina State University viser, at folk sandsynligvis vil give robotter skylden for arbejdsulykker, m -

Sidste års bedste:De bedste TechXplore-artikler i 2019Kredit:CC0 Public Domain Det var et godt år for teknologiudvikling, da et par ingeniører ved Iowa State University løste et 50 år gammelt puslespil inden for signalbehandling – de fandt på en algo

Sidste års bedste:De bedste TechXplore-artikler i 2019Kredit:CC0 Public Domain Det var et godt år for teknologiudvikling, da et par ingeniører ved Iowa State University løste et 50 år gammelt puslespil inden for signalbehandling – de fandt på en algo -

I højteknologisk Japan, kontanter er stadig kongeKun to eller tre personer om ugen bruger PayPay -systemet på Katsuyuki Hasegawas cykelværksted Engang en pioner inden for kontantløse transaktioner, Japan halter nu bagud, da verdens største økono

I højteknologisk Japan, kontanter er stadig kongeKun to eller tre personer om ugen bruger PayPay -systemet på Katsuyuki Hasegawas cykelværksted Engang en pioner inden for kontantløse transaktioner, Japan halter nu bagud, da verdens største økono -

Ford, GM:Nordamerikanske fabrikker lukker på grund af virusI denne 27. sept. 2018, fil foto a United Auto Workers montører arbejder på en 2018 Ford F-150 lastbil, der samles på Ford Rouge samlefabrik i Dearborn, Mich. United Auto Workers union ønsker, at Detr

Ford, GM:Nordamerikanske fabrikker lukker på grund af virusI denne 27. sept. 2018, fil foto a United Auto Workers montører arbejder på en 2018 Ford F-150 lastbil, der samles på Ford Rouge samlefabrik i Dearborn, Mich. United Auto Workers union ønsker, at Detr

- Sådan fungerer Sarin

- Tilføjelse af fremmede atomer til grafen øger dets egenskaber

- Sådan konverteres blandede fraktioner til forhold

- Anvendelsen af polynomier

- En ToM-baseret algoritme til estimering af menneskelige hensigter til robotiserede lagre

- Funktionsbaseret sekventeringsteknik tillader analyse af kun en enkelt bakteriecelle