Dette datasæt til genkendelse af objekter overrumplede verdens bedste computervisionsmodeller

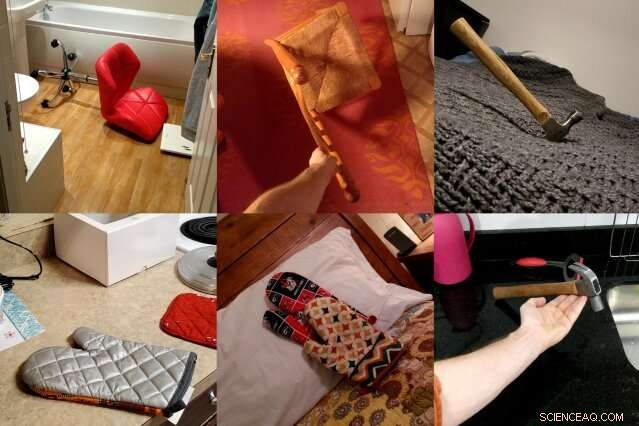

ObjectNet, et datasæt af fotos lavet af MIT og IBM forskere, viser objekter fra ulige vinkler, i flere retninger, og mod forskellige baggrunde for bedre at repræsentere kompleksiteten af 3D-objekter. Forskerne håber, at datasættet vil føre til nye computersynsteknikker, der fungerer bedre i det virkelige liv. Kredit:Massachusetts Institute of Technology

Computervisionsmodeller har lært at identificere objekter på fotos så præcist, at nogle kan udkonkurrere mennesker på nogle datasæt. Men når de samme objektdetektorer bliver løsnet i den virkelige verden, deres ydeevne falder mærkbart, skabe pålidelighedsproblemer for selvkørende biler og andre sikkerhedskritiske systemer, der bruger maskinsyn.

I et forsøg på at lukke dette præstationskløft, et hold af MIT- og IBM-forskere satte sig for at skabe en meget anderledes slags objektgenkendelsesdatasæt. Det hedder ObjectNet, et spil på ImageNet, den crowdsourcede database med billeder, der er ansvarlig for at lancere en stor del af det moderne boom inden for kunstig intelligens.

I modsætning til ImageNet, som indeholder billeder taget fra Flickr og andre sociale medier, ObjectNet indeholder billeder taget af betalte freelancere. Objekter vises tippet på siden, skudt i ulige vinkler, og vises i rodet rum. Da førende objektdetektionsmodeller blev testet på ObjectNet, deres nøjagtighedsrater faldt fra et maksimum på 97 procent på ImageNet til kun 50-55 procent.

"Vi oprettede dette datasæt for at fortælle folk, at objektgenkendelsesproblemet fortsat er et svært problem, " siger Boris Katz, en forsker ved MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) og Center for Brains, Minds and Machines (CBMM). "Vi har brug for bedre, smartere algoritmer." Katz og hans kolleger vil præsentere ObjectNet og deres resultater på konferencen om neurale informationsbehandlingssystemer (NeurIPS).

Dyb læring, teknikken, der driver en stor del af de seneste fremskridt inden for kunstig intelligens, bruger lag af kunstige "neuroner" til at finde mønstre i enorme mængder af rådata. Den lærer at vælge ud, sige, stolen på et foto efter træning i hundreder til tusindvis af eksempler. Men selv datasæt med millioner af billeder kan ikke vise hvert objekt i alle dets mulige orienteringer og indstillinger, skabe problemer, når modellerne møder disse objekter i det virkelige liv.

ObjectNet adskiller sig fra konventionelle billeddatasæt på en anden vigtig måde:det indeholder ingen træningsbilleder. De fleste datasæt er opdelt i data til træning af modellerne og test af deres ydeevne. Men træningssættet deler ofte subtile ligheder med testsættet, giver i realiteten modellerne et sneak peak på testen.

Ved første øjekast, ImageNet, med 14 millioner billeder, virker enorm. Men når træningssættet er udelukket, det er sammenligneligt i størrelse med ObjectNet, ved 50, 000 billeder.

"Hvis vi vil vide, hvor godt algoritmer vil fungere i den virkelige verden, vi bør teste dem på billeder, der er upartiske, og som de aldrig har set før, " siger studiemedforfatter Andrei Barbu, en forsker ved CSAIL og CBMM.

Et datasæt, der forsøger at fange kompleksiteten af objekter i den virkelige verden

De færreste ville finde på at dele billederne fra ObjectNet med deres venner, og det er meningen. Forskerne hyrede freelancere fra Amazon Mechanical Turk til at tage billeder af hundredvis af tilfældigt poserede husholdningsgenstande. Arbejdere modtog fotoopgaver på en app, med animerede instruktioner, der fortæller dem, hvordan de skal orientere det tildelte objekt, hvilken vinkel man skal skyde fra, og om man skal stille genstanden i køkkenet, badeværelse, soveværelse, eller stue.

De ønskede at eliminere tre almindelige skævheder:objekter vist frontalt, i ikoniske positioner, og i højt korrelerede omgivelser - f.eks. tallerkener stablet i køkkenet.

Det tog tre år at udtænke datasættet og designe en app, der ville standardisere dataindsamlingsprocessen. "Det var utroligt vanskeligt at opdage, hvordan man indsamler data på en måde, der kontrollerer forskellige skævheder, " siger studiemedforfatter David Mayo, en kandidatstuderende ved MIT's Institut for Elektroteknik og Datalogi. "Vi var også nødt til at køre eksperimenter for at sikre, at vores instruktioner var klare, og at arbejderne vidste præcis, hvad der blev bedt om dem."

Det tog endnu et år at indsamle de faktiske data, og til sidst, halvdelen af alle de fotos, freelancere indsendte, måtte kasseres, fordi de ikke opfyldte forskernes specifikationer. I et forsøg på at være behjælpelig, nogle arbejdere føjede etiketter til deres objekter, iscenesat dem på hvid baggrund, eller på anden måde forsøgt at forbedre æstetikken i de billeder, de fik til opgave at tage.

Mange af billederne er taget uden for USA, og dermed, nogle genstande kan se ukendte ud. Modne appelsiner er grønne, bananer kommer i forskellige størrelser, og tøj vises i en række forskellige former og teksturer.

Object Net vs. ImageNet:hvordan førende objektgenkendelsesmodeller sammenlignes

Da forskerne testede state-of-the-art computersynsmodeller på ObjectNet, de fandt et præstationsfald på 40-45 procentpoint fra ImageNet. Resultaterne viser, at objektdetektorer stadig kæmper for at forstå, at objekter er tredimensionelle og kan roteres og flyttes ind i nye sammenhænge, siger forskerne. "Disse forestillinger er ikke indbygget i arkitekturen af moderne objektdetektorer, " siger studiemedforfatter Dan Gutfreund, en forsker hos IBM.

For at vise, at ObjectNet er svært netop på grund af, hvordan objekter ses og placeres, forskerne lod modellerne træne på halvdelen af ObjectNet-dataene, før de testede dem på den resterende halvdel. Træning og test på det samme datasæt forbedrer typisk ydeevnen, men her forbedrede modellerne sig kun lidt, tyder på, at objektdetektorer endnu ikke fuldt ud har forstået, hvordan objekter eksisterer i den virkelige verden.

Computersynsmodeller er gradvist blevet forbedret siden 2012, da en objektdetektor kaldet AlexNet knuste konkurrencen ved den årlige ImageNet-konkurrence. Efterhånden som datasæt er blevet større, ydeevnen er også forbedret.

Men ved at designe større versioner af ObjectNet, med dens tilføjede betragtningsvinkler og orienteringer, vil ikke nødvendigvis føre til bedre resultater, advarer forskerne. Målet med ObjectNet er at motivere forskere til at komme med den næste bølge af revolutionære teknikker, ligesom den første lancering af ImageNet-udfordringen gjorde.

"Folk fodrer disse detektorer med enorme mængder data, men der er aftagende afkast, " siger Katz. "Du kan ikke se et objekt fra alle vinkler og i enhver sammenhæng. Vores håb er, at dette nye datasæt vil resultere i robust computersyn uden overraskende fejl i den virkelige verden."

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Renaults bestyrelse fastholder Ghosn som administrerende direktør, siger, at lønnen var lovligCarlos Ghosn har været varetægtsfængslet i Japan siden den 19. november anklaget for økonomisk uredelighed og underrapportering af sin løn som chef for Renaults partner Nissan Bestyrelsen for den

Renaults bestyrelse fastholder Ghosn som administrerende direktør, siger, at lønnen var lovligCarlos Ghosn har været varetægtsfængslet i Japan siden den 19. november anklaget for økonomisk uredelighed og underrapportering af sin løn som chef for Renaults partner Nissan Bestyrelsen for den -

Smartphones:Det kulturelle, individuelle og tekniske processer, der gør dem smarteHvad er en smartphone? Kredit:Maxx-Studio/Shutterstock.com Har der nogensinde været en opfindelse, der er så integreret i vores liv, og så intimt, som smartphone? Alligevel er de glatte ting. Smar

Smartphones:Det kulturelle, individuelle og tekniske processer, der gør dem smarteHvad er en smartphone? Kredit:Maxx-Studio/Shutterstock.com Har der nogensinde været en opfindelse, der er så integreret i vores liv, og så intimt, som smartphone? Alligevel er de glatte ting. Smar -

Berlins punk-rock-distrikt går i kamp mod GoogleAktivister i Kreuzberg trækker ingen slag i deres kamp mod Google Globale byer fra Seoul til Tel Aviv har taget imod Google med åbne arme, men i det bohemiske Berlin-kvarter Kreuzberg har Silicon

Berlins punk-rock-distrikt går i kamp mod GoogleAktivister i Kreuzberg trækker ingen slag i deres kamp mod Google Globale byer fra Seoul til Tel Aviv har taget imod Google med åbne arme, men i det bohemiske Berlin-kvarter Kreuzberg har Silicon -

Teknologien er bedre end nogensinde – men tusindvis af amerikanere dør stadig i bilulykker hvert å…35, 092 mennesker døde i ulykker på amerikanske veje i 2015. Kredit:Honeybee49/shutterstock.com I dag, kørsel er uden tvivl mere sikkert end nogensinde før. Moderne køretøjer har nu en række sikk

Teknologien er bedre end nogensinde – men tusindvis af amerikanere dør stadig i bilulykker hvert å…35, 092 mennesker døde i ulykker på amerikanske veje i 2015. Kredit:Honeybee49/shutterstock.com I dag, kørsel er uden tvivl mere sikkert end nogensinde før. Moderne køretøjer har nu en række sikk

- For mange fagfolk gør sig skyldige i at anvende traditionelle værdier til adoption af samme køn

- Seks ting at vide om Florida red tide

- En ny måde at skabe bløde robotter på - DNA-triggere, der får hydrogeler til at ændre form

- Bio-inspirerede algoritmer muliggør et mønster af tusindvis af huller i nanoskala i metalfilm til …

- Fine mønstre, der kombinerer enkelt-atom-tykt grafen, bornitrid peger mod 2-D elektroniske enheder

- Indias Vistara afgiver $3,1 mia. ordre hos Airbus, Boeing