Er det enden på statistisk signifikans? Kampen for at gøre videnskaben mere usikker

En hurtig guide til p-værdier. Kredit:Repapetilto/Wikimedia, CC BY-SA

Den videnskabelige verden bugner efter anbefalinger fra to af de mest prestigefyldte videnskabelige tidsskrifter – Den amerikanske statistiker og Natur – at udtrykket "statistisk signifikans" udgår.

I deres introduktion til specialnummeret af The American Statistician om emnet, tidsskriftets redaktører opfordrer til "at flytte til en verden hinsides 's <0,05, '" den berømte tærskel på 5 procent til at bestemme, om et studies resultat er statistisk signifikant. Hvis en undersøgelse består denne test, det betyder, at sandsynligheden for, at et resultat alene skyldes tilfældigheder, er mindre end 5 procent. Dette har ofte været forstået således, at undersøgelsen er værd at være opmærksom på.

Tidsskriftets grundlæggende budskab – men ikke nødvendigvis konsensus i de 43 artikler i dette nummer, en af dem, jeg bidrog med – var, at videnskabsmænd først og fremmest skulle "omfavne usikkerhed" og "være betænksomme, åben og beskeden."

Selvom det er fine egenskaber, Jeg mener, at videnskabsmænd ikke må lade dem sløre for den præcision og stringens, som videnskaben kræver. Usikkerhed er iboende i data. Hvis videnskabsmænd yderligere svækker den i forvejen meget svage tærskel på 0,05, så ville det uundgåeligt gøre videnskabelige resultater sværere at fortolke og mindre tilbøjelige til at være tillid til.

Pælebesvær oveni besvær

I traditionel videnskabspraksis, en videnskabsmand genererer en hypotese og designer eksperimenter for at indsamle data til støtte for hypoteser. Han eller hun indsamler derefter data og udfører statistiske analyser for at afgøre, om dataene faktisk understøttede hypotesen.

En standard statistisk analyse er p-værdien. Dette genererer et tal mellem 0 og 1, der indikerer stærkt, marginal eller svag understøttelse af en hypotese.

Men jeg er bekymret for, at det at opgive evidensdrevne standarder for disse domme vil gøre det endnu sværere at designe eksperimenter, meget mindre vurdere deres resultater. For eksempel, hvordan kunne man overhovedet bestemme en passende stikprøvestørrelse uden et målrettet præcisionsniveau? Og hvordan skal forskningsresultater fortolkes?

Det er vigtige spørgsmål, ikke kun for forskere ved finansierings- eller reguleringsorganer, men for enhver, hvis dagligdag er påvirket af statistiske vurderinger. Det inkluderer alle, der tager medicin eller bliver opereret, kører eller kører i køretøjer, er investeret i aktiemarkedet, har livsforsikring eller afhænger af nøjagtige vejrudsigter ... og listen fortsætter. Tilsvarende mange regulerende agenturer er afhængige af statistik til at træffe beslutninger hver dag.

Forskere skal have sproget til at indikere, at en undersøgelse, eller gruppe af undersøgelser, givet væsentlige beviser til fordel for et forhold eller en effekt. Statistisk signifikans er det udtryk, der tjener dette formål.

Grupperne bag denne bevægelse

Fjendtlighed over for udtrykket "statistisk signifikans" opstår fra to grupper.

Den første består i vid udstrækning af forskere, der er skuffede, da deres undersøgelser producerer p=0,06. Med andre ord, dem, hvis studier bare ikke klarer sig. Det er i høj grad videnskabsmænd, som finder, at 0,05-standarden er en for høj hindring for at blive publiceret i de videnskabelige tidsskrifter, der er en vigtig kilde til akademisk viden - såvel som ansættelse og forfremmelse.

Den anden gruppe er bekymret over den manglende gentagelse af videnskabelige undersøgelser, og de giver til dels signifikanstestning skylden for denne fiasko.

For eksempel, en gruppe videnskabsmænd gentog for nylig 100 offentliggjorte psykologiske eksperimenter. 97 af de 100 originale undersøgelser rapporterede et statistisk signifikant fund (s <0,05), men kun 36 af de gentagne forsøg var i stand til også at opnå et signifikant resultat.

Manglen på at replikere så mange undersøgelser kan delvis skydes på publikationsbias, hvilket resulterer, når kun væsentlige resultater offentliggøres. Publikationsbias får videnskabsmænd til at overvurdere størrelsen af en effekt, såsom forholdet mellem to variable, hvilket gør replikering mindre sandsynlig.

Det, der komplicerer situationen yderligere, er det faktum, at nyere forskning viser, at p-værdi cutoff ikke giver meget bevis for, at der er fundet en reel sammenhæng. Faktisk, i replikationsstudier i samfundsvidenskab, det ser nu ud til, at p-værdier tæt på standardtærsklen på 0,05 sandsynligvis betyder, at en videnskabelig påstand er forkert. Det er kun, når p-værdien er meget mindre, måske mindre end 0,005, at videnskabelige påstande sandsynligvis viser en reel sammenhæng.

Den forvirring, der førte til denne bevægelse

Mange ikke-statistikere forveksler p-værdi med sandsynligheden for, at der ikke blev gjort nogen opdagelse.

Lad os se på et eksempel fra Nature-artiklen. To undersøgelser undersøgte den øgede risiko for sygdom efter at have taget et lægemiddel. Begge undersøgelser vurderede, at patienter havde en 20 procent højere risiko for at få sygdommen, hvis de tager stoffet, end hvis de ikke gjorde det. Med andre ord, begge undersøgelser estimerede den relative risiko til at være 1,20.

Imidlertid, den relative risiko estimeret fra den ene undersøgelse var mere præcis end den anden, fordi dens estimat var baseret på resultater fra mange flere patienter. Dermed, estimatet fra en undersøgelse var statistisk signifikant, og skønnet fra den anden var det ikke.

Forfatterne nævner denne inkonsistens – at den ene undersøgelse opnåede et signifikant resultat og den anden ikke – som bevis på, at statistisk signifikans fører til fejlfortolkning af videnskabelige resultater.

Imidlertid, Jeg føler, at en rimelig opsummering simpelthen er, at en undersøgelse indsamlede statistisk signifikant evidens, og en gjorde ikke, men estimaterne fra begge undersøgelser antydede, at den relative risiko var tæt på 1,2.

Hvor skal man hen herfra

Jeg er enig i Nature-artiklen og The American Statistician-redaktionen i, at data indsamlet fra alle veldesignede videnskabelige undersøgelser bør gøres offentligt tilgængelige, med omfattende opsummeringer af statistiske analyser. Sammen med hver undersøgelses p-værdier, det er vigtigt at offentliggøre estimater af effektstørrelser og konfidensintervaller for disse estimater, samt fuldstændige beskrivelser af alle dataanalyser og databehandling.

På den anden side, kun undersøgelser, der giver stærke beviser til fordel for vigtige associationer eller nye effekter, bør publiceres i førende tidsskrifter. For disse tidsskrifter, bevisstandarder bør øges ved at kræve mindre p-værdier for den indledende rapport om relationer og nye opdagelser. Med andre ord, få videnskabsmænd til at offentliggøre resultater, som de er endnu mere sikre på.

Den nederste linje er, at afviklingen af accepterede standarder for statistisk evidens vil mindske den usikkerhed, som videnskabsmænd har i forbindelse med publicering af deres egen forskning. Men det vil også øge offentlighedens usikkerhed med hensyn til at acceptere de resultater, de publicerer – og det kan være problematisk.

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Pandemivirkninger på små virksomhederKredit:CC0 Public Domain Alle verden over er blevet upåvirket af fremkomsten af en ny coronavirus, navngivet SARS-CoV-2 i slutningen af 2019, som førte til den nuværende COVID-19-pandemi. Vore

Pandemivirkninger på små virksomhederKredit:CC0 Public Domain Alle verden over er blevet upåvirket af fremkomsten af en ny coronavirus, navngivet SARS-CoV-2 i slutningen af 2019, som førte til den nuværende COVID-19-pandemi. Vore -

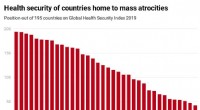

Coronavirus:Det internationale samfund skal overvåge reaktionen fra lande, der har haft massegrusom…CC BY-SA Det er 15 år siden, at FN enstemmigt godkendte ansvaret for at beskytte, hvor alle lande har et ansvar for at beskytte mennesker over hele verden mod fire forbrydelser:folkedrab, forbryde

Coronavirus:Det internationale samfund skal overvåge reaktionen fra lande, der har haft massegrusom…CC BY-SA Det er 15 år siden, at FN enstemmigt godkendte ansvaret for at beskytte, hvor alle lande har et ansvar for at beskytte mennesker over hele verden mod fire forbrydelser:folkedrab, forbryde -

Analyse af antallet af politirelaterede dødsfald finder betydelige racerelaterede forskelleEstimerede årlige rater af fatal politivold pr. 100, 000 beboere, af MSA. Estimerede MSA-specifikke rater af fatal politivold pr. 100, 000 beboere om året kortlægges. Quintiler er mærket i legenden sa

Analyse af antallet af politirelaterede dødsfald finder betydelige racerelaterede forskelleEstimerede årlige rater af fatal politivold pr. 100, 000 beboere, af MSA. Estimerede MSA-specifikke rater af fatal politivold pr. 100, 000 beboere om året kortlægges. Quintiler er mærket i legenden sa -

Anvendelse af menneskecentreret design på afstemningsstederKredit:Pixabay/CC0 Public Domain Mens USA forbereder sig til parlamentsvalget i november, næsten alle trin i afstemningsprocessen bliver fornyet og revurderet for at sikre, at COVID-19 ikke sprede

Anvendelse af menneskecentreret design på afstemningsstederKredit:Pixabay/CC0 Public Domain Mens USA forbereder sig til parlamentsvalget i november, næsten alle trin i afstemningsprocessen bliver fornyet og revurderet for at sikre, at COVID-19 ikke sprede

- Ny forskning viser, at fugle og flyvende krybdyr var venner, ikke fjender

- Undersøgelse:Polarisationsdynamik i kystnære vådområder i det nordøstlige Italien fra 1984 til …

- Rutsjebaneforskning landede, næste flyvning:Månen og Mars

- Krav til en videnskabelig hypotese

- Online landmænd markedsfører værdifuldt, når krisehændelser som COVID opstår

- 5 mest bizarre årsprognoser 2012