Dyb læring fra et dynamisk synspunkt

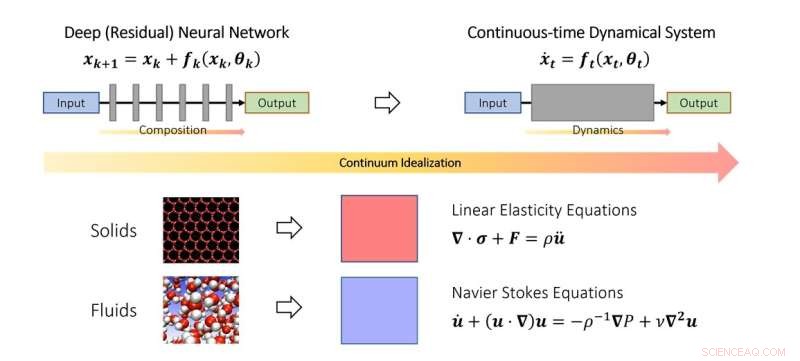

Det kontinuerlige synspunkt om dyb læring. I lighed med hvordan videnskabsmænd studerer faststof- og væskemekanik i kontinuumgrænsen, kan man også idealisere dybe neurale netværk som en diskretisering af et kontinuerligt dynamisk system. I skemaet repræsenterer den fiktive tidsparameter en kontinuerlig analog af lag, og dynamikken modellerer lagstablingen. Kredit:Qianxiao Li

NUS-matematikere har udviklet en ny teoretisk ramme baseret på dynamiske systemer for at forstå, hvornår og hvordan et dybt neuralt netværk kan lære vilkårlige relationer.

På trods af at man har opnået udbredt succes i praksis, er det stadig en udfordrende opgave at forstå de teoretiske principper for dyb læring. Et af de mest fundamentale spørgsmål er:kan dybe neurale netværk lære vilkårlige input-output-forhold (i matematik kaldes disse funktioner), og adskiller den måde, de opnår dette på, fra traditionelle metoder?

For at forstå dette spørgsmål er det nødvendigt at tænke over, hvad der præcist er nyt i dybe neurale netværk sammenlignet med traditionelle funktionstilnærmelsesparadigmer. For eksempel tilnærmer klassisk Fourier-serie komplicerede funktioner som en vægtet sum af simplere funktioner, såsom sinus og cosinus. Dybe neurale netværk fungerer helt anderledes. I stedet for vægtede summer bygger de komplekse funktioner ud af den gentagne stabling af simple funktioner (lag). Dette er også kendt som funktionssammensætning i matematik. Nøglespørgsmålet er, hvordan komplicerede funktioner kan bygges ud af simple ved at stable dem sammen. Det viser sig, at dette er et ganske nyt problem i den gren af matematik, der er kendt som tilnærmelsesteori.

I denne undersøgelse offentliggjort i Journal of the European Mathematical Society , udviklede adjunkt Qianxiao LI fra Institut for Matematik, National University of Singapore og hans samarbejdspartnere en ny teori om tilnærmelsesevner for funktionssammensætning. En interessant observation er, at selvom funktionssammensætning er udfordrende at analysere i praksis på grund af dens diskrete og ikke-lineære struktur, er det ikke første gang, der er sådanne problemer.

I studiet af faste stoffers og væskers bevægelse idealiseres de ofte som et kontinuum af partikler, der opfylder nogle kontinuerlige ligninger (almindelige eller partielle differentialligninger). Dette gør det muligt at omgå vanskeligheden ved at modellere sådanne systemer på det diskrete, atomare niveau. I stedet blev kontinuumsligninger, der modellerer deres adfærd på makroskopisk niveau, udledt.

Nøgleideen i undersøgelsen er, at dette koncept kan udvides til dybe neurale netværk ved at idealisere den lagdelte struktur som et kontinuerligt dynamisk system. Dette forbinder dyb læring med den gren af matematik, der er kendt som dynamiske systemer. Sådanne forbindelser giver mulighed for udvikling af nye værktøjer til at forstå matematikken i dyb læring, herunder en generel karakterisering af, hvornår den faktisk kan tilnærme vilkårlige sammenhænge.

Prof Li sagde:"Deep learnings dynamiske systemsynspunkt tilbyder en lovende matematisk ramme, der fremhæver de kendetegnende aspekter af dybe neurale netværk sammenlignet med traditionelle paradigmer. Dette bringer spændende nye matematiske problemer på grænsefladen mellem dynamiske systemer, tilnærmelsesteori og maskinlæring. "

"Et lovende område for fremtidig udvikling er at udvide denne ramme til at studere andre aspekter af dybe neurale netværk, såsom hvordan man træner dem effektivt, og hvordan man sikrer, at de fungerer bedre på usete datasæt," tilføjede Prof Li. + Udforsk yderligere

Rationelt neuralt netværk fremmer indlæring af partiel differentieringsligning

Varme artikler

Varme artikler

-

Sådan fungerer Dark MatterDu kigger uden tvivl på et af de bedste kort over mørkt stof, vi har. Astronomer tonede koncentrationer af mørkt stof i den gigantiske galaksehob Abell 1689 blå. De fandt ud af placeringen af disse

Sådan fungerer Dark MatterDu kigger uden tvivl på et af de bedste kort over mørkt stof, vi har. Astronomer tonede koncentrationer af mørkt stof i den gigantiske galaksehob Abell 1689 blå. De fandt ud af placeringen af disse -

Som en handling af selvafsløring, kreativitet på arbejdspladsen kan være risikabel forretningDet er mere og mere almindeligt, at ledere instruerer medarbejderne i at være kreative under brainstormingsessioner. Men ifølge et nyt papir fra Jack Goncalo, en professor i forretningsadministration

Som en handling af selvafsløring, kreativitet på arbejdspladsen kan være risikabel forretningDet er mere og mere almindeligt, at ledere instruerer medarbejderne i at være kreative under brainstormingsessioner. Men ifølge et nyt papir fra Jack Goncalo, en professor i forretningsadministration -

Undersøgelse identificerer dinosaurs manglende ledForenklet tidskalibreret strengt konsensustræ, hvor Chilesaurusis kom sig i Ornithischia. Silhuetter repræsenterer supraspecifikke taxa - fra venstre mod højre:Sauropodomorpha, Heterodontosauridae, Ge

Undersøgelse identificerer dinosaurs manglende ledForenklet tidskalibreret strengt konsensustræ, hvor Chilesaurusis kom sig i Ornithischia. Silhuetter repræsenterer supraspecifikke taxa - fra venstre mod højre:Sauropodomorpha, Heterodontosauridae, Ge -

En ny matematikindsats hjælper med at indsnævre præstationskløften blandt førskolebørnKredit:CC0 Public Domain Når de når børnehaven, børn fra dårligt stillede baggrunde er måske allerede bagud i matematik. Men at identificere, hvilke elever der har brug for hjælp – og på hvilke om

En ny matematikindsats hjælper med at indsnævre præstationskløften blandt førskolebørnKredit:CC0 Public Domain Når de når børnehaven, børn fra dårligt stillede baggrunde er måske allerede bagud i matematik. Men at identificere, hvilke elever der har brug for hjælp – og på hvilke om

- Billede sort hul som at lytte til ødelagt klaver, siger videnskabsmand

- Sprængning af molekyler med ekstreme røntgenstråler

- Typer af fossil bevarelse

- Smagsligheden mellem fødevarer kan sammenlignes ved hjælp af elektroencefalografi

- Test udført på droneløsning til levering af krydsfiner

- Apple lukker iPhone-sikkerhedskløften brugt af retshåndhævelse