Baggrundsswap-teknologi egnet til mobiltelefoner annonceret

Kredit:Google

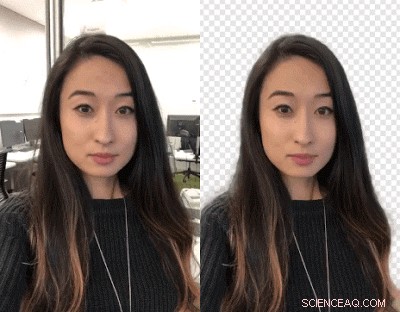

Videooprettere:Vil du bytte baggrunde? Slå jer ud. Google -forskere har arbejdet på en måde, så du kan skifte dine videobaggrunde ud ved hjælp af et neuralt netværk - ingen grøn skærm kræves.

Det ruller ud til YouTube Stories på mobilen på en begrænset måde, sagde TechCrunch .

John Anon, Android -overskrifter , sagde YouTube -skabere kan ændre baggrunden for at skabe mere engagerende videoer.

Valentin Bazarevsky og Andrei Tkachenka, software ingeniører, Google Research, meddelte, med titlen "Mobile real-time videosegmentering."

Skabere af videoindhold ved, at en scenes baggrund kan adskilles fra baggrunden behandlet som to forskellige lag. Manøvren er udført for at opnå en stemning, eller indsæt et sjovt sted eller forstærk virkningen af beskeden.

Operationen, sagde de to på Google Research -webstedet, er "en tidskrævende manuel proces (f.eks. en kunstner, der roterer alle rammer) eller kræver et studiemiljø med en grøn skærm til fjernelse af realtid i baggrunden (en teknik kaldet chroma keying)."

Oversættelse:Hillary Grigonis in Digitale tendenser sagde, "At udskifte baggrunden på en video kræver typisk avanceret desktop -software og masser af fritid, eller et fuldgyldigt studie med en grøn skærm. "

Nu har de to annonceret en ny teknik, og det vil fungere på mobiltelefoner.

Deres teknik gør det muligt for skabere at udskifte og ændre baggrunde uden specialudstyr.

De kaldte det YouTubes nye lette videoformat, designet specielt til YouTube -skabere.

De udsendte en 1. marts meddelelse om en "præcis, realtid, segmentering af mobilvideo på enheden til YouTube-appen ved at integrere denne teknologi i historier. "

Hvordan gjorde de dette? Anon sagde "kernen i det hele er maskinlæring."

Bazarevsky og Tkachenka sagde, at de udnyttede "maskinlæring til at løse en semantisk segmenteringsopgave ved hjælp af konvolutionelle neurale netværk."

Oversættelse:"Google udvikler et alternativ til kunstig intelligens, der fungerer i realtid, fra et smartphone kamera, "Skrev Grigonis.

De to ingeniører beskrev en arkitektur og uddannelsesprocedure, der er egnet til mobiltelefoner. De huskede på, at "En mobil løsning skal være let og køre mindst 10-30 gange hurtigere end eksisterende state-of-the-art fotosegmenteringsmodeller."

Hvad angår et datasæt, de "kommenterede titusinder af billeder". Disse fangede et bredt spektrum af forgrundsstillinger og baggrundsindstillinger.

"Med det datasæt, gruppen uddannede programmet til at adskille baggrunden fra forgrunden, sagde Grigonis.

Devin Coldewey i TechCrunch :"Netværket lærte at vælge de fælles træk ved hoved og skuldre, og en række optimeringer sænkede mængden af data, den havde brug for at knuse for at gøre det. "

Digitale tendenser forklaret, hvordan det fungerer:"Når softwaren maskerer baggrunden på det første billede, programmet bruger den samme maske til at forudsige baggrunden i det næste billede. Når den næste ramme kun har mindre justeringer fra den første ... foretager programmet små justeringer af masken. Når den næste ramme er meget forskellig fra den sidste ... vil softwaren kassere denne maskeforudsigelse helt og oprette en ny maske. "

Et slutresultat af deres arbejde, som sagt på Google Research -bloggen, er, at "vores netværk kører bemærkelsesværdigt hurtigt på mobile enheder, opnåelse af 100+ FPS på iPhone 7 og 40+ FPS på Pixel 2 med høj nøjagtighed (realisering af 94,8% IOU på vores valideringsdatasæt), leverer en række glidende og responsive effekter i YouTube -historier. "

Hvad er det næste?

Det er i begrænset beta. "Vores umiddelbare mål er at bruge den begrænsede udbredelse i YouTube -historier til at teste vores teknologi på dette første sæt effekter. Når vi forbedrer og udvider vores segmenteringsteknologi til flere etiketter, Vi planlægger at integrere det i Googles bredere Augmented Reality -tjenester. "

© 2018 Tech Xplore

Varme artikler

Varme artikler

-

Siemens, Alstom rejser tvivl om megafusionAldrig vil de to mødes? Tilliden til, at den politisk følsomme fusion af deres jernbanevirksomheder ville blive vinket igennem af Europa-Kommissionen, ebbede af hos både Siemens og Alstom torsdag.

Siemens, Alstom rejser tvivl om megafusionAldrig vil de to mødes? Tilliden til, at den politisk følsomme fusion af deres jernbanevirksomheder ville blive vinket igennem af Europa-Kommissionen, ebbede af hos både Siemens og Alstom torsdag. -

Skæring af affald, brug af fossile brændstoffer, og drivhusgasemissioner ved at gøre ubrugt mad t…Marianna Bailey 18 forbereder en reaktor fyldt med madaffaldsslam til den hydrotermiske fortætningsreaktion. Kredit:Worcester Polytechnic Institute Finansieret af et tilskud fra det amerikanske en

Skæring af affald, brug af fossile brændstoffer, og drivhusgasemissioner ved at gøre ubrugt mad t…Marianna Bailey 18 forbereder en reaktor fyldt med madaffaldsslam til den hydrotermiske fortætningsreaktion. Kredit:Worcester Polytechnic Institute Finansieret af et tilskud fra det amerikanske en -

På trods af den digitale revolution, afstanden har stadig betydningKredit:CC0 Public Domain Selv når folk har godt forbundne sociale netværk ud over deres hjembyer og på tværs af statsgrænser, de interagerer stadig oftest med mennesker, der er meget geografisk tæ

På trods af den digitale revolution, afstanden har stadig betydningKredit:CC0 Public Domain Selv når folk har godt forbundne sociale netværk ud over deres hjembyer og på tværs af statsgrænser, de interagerer stadig oftest med mennesker, der er meget geografisk tæ -

At lære iCub-robotten at udtrykke grundlæggende menneskelige følelseriCub-robotten udtrykker forskellige følelser. Kredit:Churamani et al. Når robotter kommer ind i en række forskellige miljøer og begynder at interagere med mennesker på en regelmæssig basis, de ska

At lære iCub-robotten at udtrykke grundlæggende menneskelige følelseriCub-robotten udtrykker forskellige følelser. Kredit:Churamani et al. Når robotter kommer ind i en række forskellige miljøer og begynder at interagere med mennesker på en regelmæssig basis, de ska

- Overbevisninger om COVID-19-konspiration steg blandt brugere af konservative og sociale medier

- Smart lægemiddelleveringssystem - Guld nanokage dækket med polymer (m/ video)

- Studiet sporer DACAs fordele, begrænsninger for papirløse indvandrere

- Coenzymes rolle

- Tidlig begyndelse af det 20. århundredes tilbagegang i arktisk havis

- Forskelle mellem ferrimagnetisme og ferromagnetisme