DeepMind -forskere udvikler neurale aritmetiske logiske enheder (NALU)

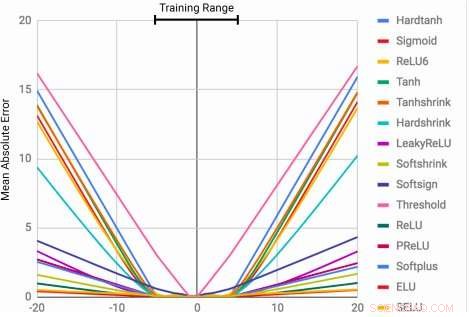

MLP'er lærer identitetsfunktionen kun for de intervalværdier, de er uddannet i. Den gennemsnitlige fejl stiger kraftigt både under og over antallet af tal, der ses under træning. Kredit:Trask et al.

Evnen til at repræsentere og manipulere numeriske størrelser kan observeres hos mange arter, herunder insekter, pattedyr og mennesker. Dette tyder på, at grundlæggende kvantitativ ræsonnement er en vigtig komponent i intelligens, som har flere evolutionære fordele.

Denne evne kan være ganske værdifuld i maskiner, muliggør hurtigere og mere effektiv udførelse af opgaver, der involverer talmanipulation. Endnu, indtil nu, neurale netværk, der er uddannet til at repræsentere og manipulere numerisk information, har sjældent været i stand til at generalisere godt uden for de værdier, der stødte på under træningsprocessen.

Et team af forskere på Google DeepMind har for nylig udviklet en ny arkitektur, der adresserer denne begrænsning, opnå bedre generalisering både inden for og uden for de numeriske værdier, som det neurale netværk blev trænet på. Deres undersøgelse, som blev forhåndspubliceret på arXiv, kunne informere udviklingen af mere avancerede maskinlæringsværktøjer til at fuldføre kvantitative ræsonnementsopgaver.

"Når standard neurale arkitekturer trænes i at tælle til et tal, de kæmper ofte for at tælle til en højere, "Andrew Trask, ledende forsker på projektet, fortalte Tech Xplore. "Vi undersøgte denne begrænsning og fandt ud af, at den også strækker sig til andre aritmetiske funktioner, fører til vores hypotese om, at neurale netværk lærer tal, der ligner, hvordan de lærer ord, som et begrænset ordforråd. Dette forhindrer dem i korrekt at ekstrapolere funktioner, der kræver tidligere usete (højere) tal. Vores mål var at foreslå en ny arkitektur, der kunne udføre bedre ekstrapolering. "

Neural Accumulator (NAC) er en lineær transformation af dets input. Transformationsmatricen er det elementære produkt af tanh (Wˆ) og σ (Mˆ). Neural Arithmetic Logic Unit (NALU) bruger to NAC'er med bundne vægte for at muliggøre addition/subtraktion (mindre lilla celle) og multiplikation/division (større lilla celle), styret af en port (orange celle). Kredit:Trask et al.

Forskerne udtænkte en arkitektur, der tilskynder til en mere systematisk talekstrapolering ved at repræsentere numeriske størrelser som lineære aktiveringer, der manipuleres ved hjælp af primitive aritmetiske operatorer, som styres af indlærte porte. De kaldte dette nye modul for den neurale aritmetiske logiske enhed (NALU), inspireret af den aritmetiske logiske enhed i traditionelle processorer.

"Tal kodes normalt i neurale netværk ved hjælp af enten one-hot eller distribuerede repræsentationer, og funktioner over tal læres inden for en række lag med ikke-lineære aktiveringer, "Trask forklaret." Vi foreslår, at tal i stedet skal gemmes som skalarer, lagring af et enkelt tal i hver neuron. For eksempel, hvis du vil gemme nummeret 42, du skal bare have en neuron, der indeholder en aktivering på nøjagtigt '42, 'i stedet for en række 0-1 neuroner, der koder for det. "

Forskerne har også ændret den måde, hvorpå det neurale netværk lærer funktioner over disse tal. I stedet for at bruge standardarkitekturer, som kan lære enhver funktion, de udtænkte en arkitektur, der fremover formerer et foruddefineret sæt funktioner, der ses som potentielt nyttige (f.eks. multiplikation eller division), ved hjælp af neurale arkitekturer, der lærer opmærksomhedsmekanismer over disse funktioner.

"Disse opmærksomhedsmekanismer bestemmer derefter, hvornår og hvor hver potentielt nyttig funktion kan anvendes i stedet for at lære selve funktionen, "Trask sagde." Dette er et generelt princip for at skabe dybe neurale netværk med en ønskelig indlæringsbias over numeriske funktioner. "

(ovenfor) Rammer fra gridworld -tidssporingsopgaven. Agenten (grå) skal flytte til destinationen (rød) på et bestemt tidspunkt. (nedenfor) NAC forbedrer ekstrapoleringsevne, som A3C -agenter har lært til datingopgaven. Kredit:Trask et al.

Deres test viste, at NALU-forbedrede neurale netværk kunne lære at udføre en række opgaver, såsom tidsregistrering, udførelse af aritmetiske funktioner over billeder af tal, oversættelse af numerisk sprog til reelt værdsatte skalarer, eksekvering af computerkode og tælling af objekter i billeder.

Sammenlignet med konventionelle arkitekturer, deres modul opnåede betydeligt bedre generalisering både inden for og uden for de numeriske værdier, det blev præsenteret for under træning. Selvom NALU måske ikke er den ideelle løsning til enhver opgave, deres undersøgelse giver en generel designstrategi til at skabe modeller, der fungerer godt på en bestemt klasse af funktioner.

"Forestillingen om, at et dybt neuralt netværk skal vælge fra et foruddefineret sæt funktioner og lære opmærksomhedsmekanismer, der styrer, hvor de bruges, er en meget udvidelig idé, "Trask forklaret." I dette arbejde, vi udforskede simple aritmetiske funktioner (tilføjelse, subtraktion, multiplikation og division), men vi er begejstrede for potentialet til at lære opmærksomhedsmekanismer over meget mere kraftfulde funktioner i fremtiden, måske bringe de samme ekstrapolationsresultater, som vi har observeret, til en lang række områder. "

© 2018 Tech Xplore

Varme artikler

Varme artikler

-

Hvordan Cambridge Analyticas Facebook-målretningsmodel virkelig fungerede - ifølge den person, der…Hvor præcist kan du blive profileret online? Kredit:Andrew Krasovitckii/Shutterstock.com Forskeren, hvis arbejde er i centrum for Facebook-Cambridge Analyticas dataanalyse og politiske reklameopst

Hvordan Cambridge Analyticas Facebook-målretningsmodel virkelig fungerede - ifølge den person, der…Hvor præcist kan du blive profileret online? Kredit:Andrew Krasovitckii/Shutterstock.com Forskeren, hvis arbejde er i centrum for Facebook-Cambridge Analyticas dataanalyse og politiske reklameopst -

Hvad er fremtiden for kontanter? Afbrydelser i målregisteret beviser, at fysisk tyvegods stadig har…Kredit:CC0 Public Domain Har brugen af kontanter en udløbsdato? Beviset for, at fysisk tyveri er på lånt tid, stiger langsomt, men sikkert. Men læs ikke de sidste ritualer for kontanter endnu.

Hvad er fremtiden for kontanter? Afbrydelser i målregisteret beviser, at fysisk tyvegods stadig har…Kredit:CC0 Public Domain Har brugen af kontanter en udløbsdato? Beviset for, at fysisk tyveri er på lånt tid, stiger langsomt, men sikkert. Men læs ikke de sidste ritualer for kontanter endnu. -

Flying-V flykoncept markerer et spektakulært nyt look inden for flyrejserKredit:Delft University of Technology Sæde flypassagerer i kulissen? Tænk over det. Et V-formet fly designet til at transportere passagerer, last, og brændstoftanke i vingerne bliver sået som en g

Flying-V flykoncept markerer et spektakulært nyt look inden for flyrejserKredit:Delft University of Technology Sæde flypassagerer i kulissen? Tænk over det. Et V-formet fly designet til at transportere passagerer, last, og brændstoftanke i vingerne bliver sået som en g -

Disse nye bløde aktuatorer kan gøre bløde robotter mindre omfangsrigeElektrisk styret, ubundet blød robot bygget af fire bløde rørformede aktuatorer, en mikrocontroller og batteri. Robotten kan programmeres til at gå eller bære en genstand. Kredit:David Baillot/UC San

Disse nye bløde aktuatorer kan gøre bløde robotter mindre omfangsrigeElektrisk styret, ubundet blød robot bygget af fire bløde rørformede aktuatorer, en mikrocontroller og batteri. Robotten kan programmeres til at gå eller bære en genstand. Kredit:David Baillot/UC San

- Australien skal stoppe med at bygge boliger i sådanne brandudsatte områder

- Sådan tolkes en beta-koefficient

- Unik udbetaling i Alaska fra olierigdom kan være i fare

- Fysikere fremskynder planerne for en ny Large Hadron Collider tre gange så stor

- Harvey-prøver sadlet med antibiotikaresistente gener

- Plast, brændstoffer og kemiske råstoffer fra CO2? De arbejder på det