AI-system trænet til at reagere som en hund

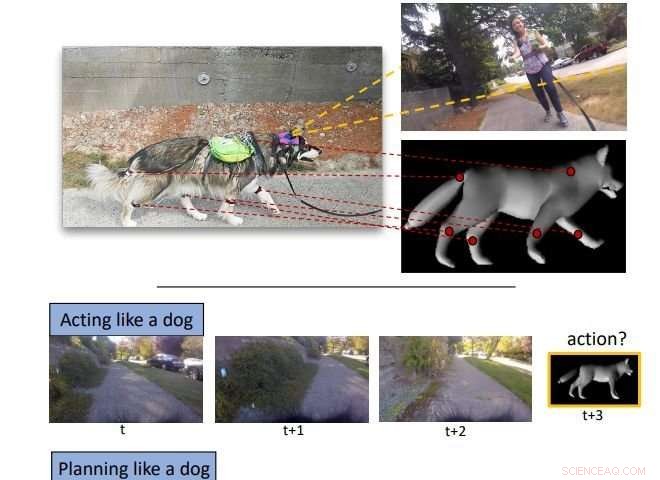

Forskerne behandlede tre problemer:(1) At opføre sig som en hund:hvor målet er at forudsige hundens fremtidige bevægelser givet en sekvens af tidligere sete billeder. (2) Planlægning som en hund:hvor målet er at finde en sekvens af handlinger, der flytter hunden mellem placeringerne af det givne par billeder. (3) At lære af en hund:hvor vi bruger den indlærte repræsentation til en tredje opgave (f.eks. estimering af gangbar overflade). Kredit:arXiv:1803.10827 [cs.CV]

Et team af forskere fra University of Washington og Allen Institute for AI har trænet et AI-system til at reagere som en hund ved hjælp af data fra et faktisk dyr. I deres papir uploadet til arXiv preprint server, gruppen beskriver deres system, og hvad det kan og ikke kan. Holdet vil også præsentere deres arbejde på konferencen om computersyn og mønstergenkendelse til sommer.

AI-systemer er typisk baseret på deep-learning algoritmer, der behandler data, der beskriver hændelser, og derefter bruge det, de har lært, til at forudsige fremtidig adfærd. I denne nye indsats, forskerne har anvendt en sådan strategi på hundeadfærd. Deres mål var at bygge et AI-system, der kunne reagere på måder, der ligner en hund under givne omstændigheder. For at nå dette mål, de satte et væld af sensorer på en malamute ved navn Kelp M. Redmon. De satte en GoPro og mikrofon på hans hoved, inerti sensorer på hans krop, ben og hale, og en Arduino-enhed på ryggen til at indsamle og behandle dataene, mens de strømmede ind. Så lod de hunden lave hundeting, som leg i parken.

AI-systemet blev sat op til at nå tre hovedmål:forudsige fremtidige bevægelser, planlægge en opgave og lære af hundens adfærd. Ideen var at få systemet til at lære at forudsige, hvad en hund ville gøre næste gang i et givet scenarie, som når man ser et egern. At efterligne en hund, systemet ville være nødt til at skabe en handlingsplan for at udføre de forudsagte fremtidige bevægelser og selvfølgelig, skal være i stand til at lære at gøre hundeting ved at lære, hvordan en faktisk hund gør dem.

I alt, holdet samlede 24, 500 billeder video, som var synkroniseret med kropsmomenter og lyd. De brugte 21, 000 af disse frames til at træne deres AI-system og resten til at teste det. De rapporterer, at systemet fungerer godt, udkonkurrerede baselines på opgaver, de anså for udfordrende. AI-systemet var ikke forbundet til en hunderobot, men det er helt klart den retning, forskningen er på vej mod - det vil sandsynligvis ikke vare længe, før AI-adfærdssystemer er forbundet med projekter, der har fokuseret på at få hundelignende robotter til at bevæge sig som rigtige dyr på nyttige måder.

© 2018 Tech Xplore

Varme artikler

Varme artikler

-

Web opfinder opfordrer brugere til at søge fuldstændig kontrol over dataKredit:CC0 Public Domain World Wide Web-opfinderen Tim Berners-Lee kritiserede mandag den stigende kommodificering af personlige oplysninger og appellerede til internetbrugere om at stræbe efter a

Web opfinder opfordrer brugere til at søge fuldstændig kontrol over dataKredit:CC0 Public Domain World Wide Web-opfinderen Tim Berners-Lee kritiserede mandag den stigende kommodificering af personlige oplysninger og appellerede til internetbrugere om at stræbe efter a -

En ladeboks til Skydio 2 -droner kan tiltrække forretningsbrugereKredit:Skydio Skydio 2 Dock er fra firmaet med samme navn, Skydio. Virksomheden viste en video af det onsdag. De sagde i videobemærkningerne, at Vi ser frem til at samarbejde med vores første kund

En ladeboks til Skydio 2 -droner kan tiltrække forretningsbrugereKredit:Skydio Skydio 2 Dock er fra firmaet med samme navn, Skydio. Virksomheden viste en video af det onsdag. De sagde i videobemærkningerne, at Vi ser frem til at samarbejde med vores første kund -

Opstart af kontordeling, WeWork, sænker værdiansættelsesmålet forud for børsnoteringenVi arbejder, startupet, der søger at revolutionere erhvervsejendomme med delt kontorplads, har skåret sit værdiansættelsesmål ned forud for et aktieudbud WeWork har reduceret sit værdiansættelsesm

Opstart af kontordeling, WeWork, sænker værdiansættelsesmålet forud for børsnoteringenVi arbejder, startupet, der søger at revolutionere erhvervsejendomme med delt kontorplads, har skåret sit værdiansættelsesmål ned forud for et aktieudbud WeWork har reduceret sit værdiansættelsesm -

Undersøgelse tyder på, at Facebooks krig mod falske nyheder vinder fremKredit:CC0 Public Domain I de to år, siden falske nyheder på internettet blev en fuldstændig krise, Facebook har taget adskillige skridt for at bremse strømmen af misinformation på sit websted.

Undersøgelse tyder på, at Facebooks krig mod falske nyheder vinder fremKredit:CC0 Public Domain I de to år, siden falske nyheder på internettet blev en fuldstændig krise, Facebook har taget adskillige skridt for at bremse strømmen af misinformation på sit websted.

- Ny måde at genbruge plantebaseret plast i stedet for at lade dem rådne på losseplads

- Forskere efterligner naturen for hurtigt, farverig 3-D print

- Ud over 1984:Snævert fokus på naturbrandtendenser undervurderer fremtidige risici for vandsikkerhe…

- Opsparere med individuelle personlige pensioner taber på grund af manglende regulering

- For at dæmme op for seksuelle overgreb, hjælpe folk til bedre at forstå samtykke

- For kunstnere i lockdown, online bliver det nye live